Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Независимый анализ моделей ИИ и хостинг-провайдеров - выберите лучшую модель и поставщика API для вашего сценария использования

DeepSeek запускает V3.1, объединяя V3 и R1 в гибридную модель рассуждений с постепенным увеличением интеллекта

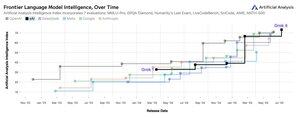

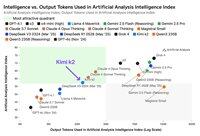

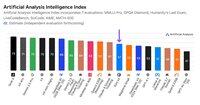

Постепенное увеличение интеллекта: Первые результаты бенчмаркинга для DeepSeek V3.1 показывают индекс искусственного анализа интеллекта 60 в режиме рассуждений, по сравнению с результатом R1 в 59. В режиме без рассуждений V3.1 достигает результата 49, что является большим увеличением по сравнению с предыдущим результатом V3 0324 в 44. Это оставляет V3.1 (рассуждение) позади последней версии Qwen3 235B 2507 от Alibaba (рассуждение) - DeepSeek не вернул лидерство.

Гибридное рассуждение: @deepseek_ai впервые перешел на гибридную модель рассуждений - поддерживая как режимы рассуждений, так и без рассуждений. Переход DeepSeek к единой гибридной модели рассуждений имитирует подход, принятый OpenAI, Anthropic и Google. Однако интересно отметить, что Alibaba недавно отказалась от гибридного подхода, который они предпочитали для Qwen3, выпустив отдельные версии моделей рассуждений и инструкций Qwen3 2507.

Вызов функций / использование инструментов: Хотя DeepSeek утверждает, что улучшил вызов функций для модели, DeepSeek V3.1 не поддерживает вызов функций в режиме рассуждений. Это, вероятно, существенно ограничит его способность поддерживать агентные рабочие процессы с требованиями к интеллекту, включая кодирующие агенты.

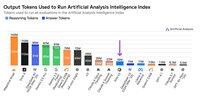

Использование токенов: DeepSeek V3.1 показывает постепенно более высокий результат в режиме рассуждений, чем DeepSeek R1, и использует немного меньше токенов в оценках, которые мы используем для индекса искусственного анализа интеллекта. В режиме без рассуждений он использует немного больше токенов, чем V3 0324 - но все равно в несколько раз меньше, чем в собственном режиме рассуждений.

API: Первоначальный API DeepSeek теперь обслуживает новую модель DeepSeek V3.1 как на их чат-эндпоинтах, так и на эндпоинтах рассуждений - просто изменяя, предоставляется ли токен конца размышления </think> модели в шаблоне чата, чтобы контролировать, будет ли модель рассуждать.

Архитектура: DeepSeek V3.1 архитектурно идентичен предыдущим моделям V3 и R1, с 671B общими параметрами и 37B активными параметрами.

Последствия: Мы бы посоветовали проявлять осторожность в том, чтобы делать какие-либо предположения о том, что этот релиз подразумевает о прогрессе DeepSeek к будущей модели, упоминаемой в слухах как V4 или R2. Мы отмечаем, что DeepSeek ранее выпустил последнюю модель, построенную на их архитектуре V2, 10 декабря 2024 года, всего за две недели до выпуска V3.

71,03K

Объявляем о запуске Artificial Analysis Long Context Reasoning (AA-LCR) — нового бенчмарка для оценки производительности в условиях длинного контекста, который проверяет способности к рассуждению на основе нескольких длинных документов (~100k токенов).

Основное внимание в AA-LCR уделяется воспроизведению реальной интеллектуальной работы и задач рассуждения, тестируя способности, критически важные для современных AI-приложений, охватывающих анализ документов, понимание кодовой базы и сложные многоступенчатые рабочие процессы.

AA-LCR состоит из 100 сложных текстовых вопросов, которые требуют рассуждения на основе нескольких реальных документов, представляющих ~100k входных токенов. Вопросы разработаны так, чтобы ответы не могли быть найдены напрямую, а должны быть выведены из нескольких источников информации, при этом тестирование людьми подтверждает, что каждый вопрос требует подлинного вывода, а не простого извлечения.

Ключевые выводы:

➤ Современные ведущие модели достигают ~70% точности: три первых места занимают OpenAI o3 (69%), xAI Grok 4 (68%) и Qwen3 235B 2507 Thinking (67%)

➤👀 У нас также уже есть результаты gpt-oss! 120B показывает результаты, близкие к o4-mini (высокие), что соответствует заявлениям OpenAI о производительности модели. Вскоре мы предоставим Индекс Интеллекта для моделей.

➤ 100 сложных текстовых вопросов, охватывающих 7 категорий документов (Отчеты компаний, Отраслевые отчеты, Государственные консультации, Академия, Юридические документы, Маркетинговые материалы и Отчеты опросов)

➤ ~100k токенов входа на вопрос, что требует от моделей поддержки минимального контекстного окна в 128K для оценки по этому бенчмарку

➤ ~3M уникальных входных токенов, охватывающих ~230 документов для проведения бенчмарка (выходные токены обычно варьируются в зависимости от модели)

➤ Ссылка на набор данных на 🤗 @HuggingFace приведена ниже

Мы добавляем AA-LCR в Индекс Интеллекта Artificial Analysis и обновляем номер версии до v2.2. Индекс Интеллекта Artificial Analysis v2.2 теперь включает: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode и AA-LCR.

Все цифры обновлены на сайте. Узнайте, какие модели входят в Индекс Интеллекта Artificial Analysis v2.2 👇

28,75K

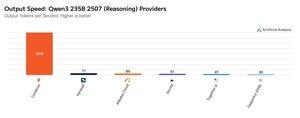

Cerebras демонстрировала свою способность хостить большие MoE на очень высоких скоростях на этой неделе, запустив конечные точки Qwen3 235B 2507 и Qwen3 Coder 480B с выходом >1,500 токенов/с

➤ @CerebrasSystems теперь предлагает конечные точки как для Qwen3 235B 2507 Reasoning, так и для Non-reasoning. Оба модели имеют 235B общих параметров с 22B активными.

➤ Qwen 3 235B 2507 Reasoning предлагает интеллект, сопоставимый с o4-mini (высокий) и DeepSeek R1 0528. Вариант Non-reasoning предлагает интеллект, сопоставимый с Kimi K2 и значительно превосходит GPT-4.1 и Llama 4 Maverick.

➤ Qwen3 Coder 480B имеет 480B общих параметров с 35B активными. Эта модель особенно сильна в агентном кодировании и может использоваться в различных инструментах кодирования агентов, включая Qwen3-Coder CLI.

Запуски Cerebras представляют собой первый случай, когда такой уровень интеллекта стал доступен на таких скоростях вывода и имеют потенциал для открытия новых случаев использования - например, использование модели рассуждения для каждого шага агента без необходимости ждать минуты.

25,24K

🇰🇷 LG недавно выпустила EXAONE 4.0 32B - он набрал 62 балла в Индексе Искусственного Интеллекта, что является самым высоким результатом для модели 32B на данный момент.

EXAONE 4.0 от @LG_AI_Research выпущен в двух вариантах: гибридная модель рассуждений 32B, для которой мы сообщаем результаты бенчмаркинга, и меньшая модель 1.2B, предназначенная для приложений на устройстве, которую мы еще не тестировали.

Вместе с недавним выпуском Solar Pro 2 от Upstage, приятно видеть, как корейские лаборатории ИИ присоединяются к США и Китаю в верхней части рейтингов интеллекта.

Ключевые результаты:

➤ 🧠 EXAONE 4.0 32B (Рассуждение): В режиме рассуждений EXAONE 4.0 набирает 62 балла в Индексе Искусственного Интеллекта. Это соответствует Claude 4 Opus и новой Llama Nemotron Super 49B v1.5 от NVIDIA, и всего на 1 балл меньше, чем Gemini 2.5 Flash.

➤ ⚡ EXAONE 4.0 32B (Без рассуждений): В режиме без рассуждений EXAONE 4.0 набирает 51 балл в Индексе Искусственного Интеллекта. Он соответствует Llama 4 Maverick по уровню интеллекта, несмотря на то, что имеет всего ~1/4 от общего количества параметров (хотя активных параметров примерно в 2 раза больше).

➤ ⚙️ Выходные токены и многословие: В режиме рассуждений EXAONE 4.0 использовал 100M выходных токенов для Индекса Искусственного Интеллекта. Это больше, чем у некоторых других передовых моделей, но соответствует недавним тенденциям, когда модели рассуждений используют больше выходных токенов для "более глубокого мышления" - аналогично Llama Nemotron Super 49B v1.5, Grok 4 и Qwen3 235B 2507 Reasoning. В режиме без рассуждений EXAONE 4.0 использовал 15M токенов - это много для модели без рассуждений, но не так много, как у Kimi K2 с 30M.

Ключевые детали:

➤ Гибридное рассуждение: Модель предлагает возможность выбора между режимом 'рассуждений' и 'без рассуждений'.

➤ Доступность: В настоящее время размещается @friendliai и имеет конкурентоспособную цену (особенно по сравнению с проприетарными вариантами) от FriendliAI в $1 за 1M входных и выходных токенов.

➤ Открытые веса: EXAONE 4.0 - это модель с открытыми весами, доступная по Лицензионному Соглашению Модели ИИ EXAONE 1.2. Лицензия ограничивает коммерческое использование.

➤ Мультимодальность: Ввод и вывод только текстовые.

➤ Контекстное окно: 131k токенов.

➤ Параметры: 32B активных и общих параметров, доступных в 16-битной и 8-битной точности (это означает, что модель может работать на одном чипе H100 в полной точности).

41,59K

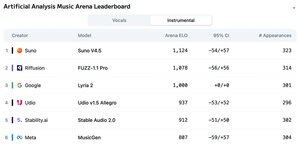

Объявляем о Лидерах Таблицы Музыкального Анализа Искусственного Интеллекта: с более чем 5 тыс. голосов, Suno v4.5 является ведущей моделью генерации музыки, за ней следует FUZZ-1.1 Pro от Riffusion.

Lyria 2 от Google занимает третье место в нашей таблице инструментальной музыки, а v1.5 Allegro от Udio занимает третье место в нашей таблице вокалов.

Инструментальная таблица выглядит следующим образом:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

Рейтинги основаны на голосах сообщества в различных жанрах и темах. Хотите увидеть свою тему в списке? Вы можете отправить темы в арену сегодня.

👇 Смотрите ниже таблицу вокалов и ссылку для участия!

22,22K

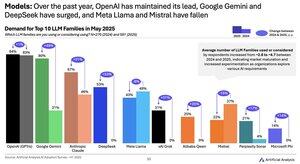

Модельное изменение спроса с 2024 по 2025 год: Google (+49 пунктов), DeepSeek (+53 пункта) и xAI (+31 пункт) добились значительного увеличения доли спроса за последний год

@Google превратился из отстающего в области ИИ в лидера в области ИИ, увеличив в ~2,5 раза долю респондентов, использующих или рассматривающих модельный ряд Gemini. Ключевым фактором этого стало то, что Google добился значительных успехов в интеллекте: Gemini 2.5 Pro теперь занимает #3 в нашем индексе искусственного интеллекта, по сравнению со значительным отставанием от OpenAI и Anthropic в начале 2024 года.

@deepseek_ai в первом полугодии 2024 года выпустила только DeepSeek 67B, модель, которая получила ограниченное распространение и уступила Llama 3 70B. DeepSeek впервые получила некоторое распространение в конце 2024 года с выпуском своей модели V2, а затем увидела быстрое внедрение в начале 2025 года со своими моделями V3 и R1, которые вывели их на лидирующие позиции среди моделей с открытыми весами.

@xai выпустила свою первую модель Grok-1 в середине первого полугодия 2024 года и с тех пор быстро поднялась до лидерства в разведке среди всех моделей с последовательными выпусками, кульминацией которых стал запуск Grok 4 на прошлой неделе.

Источник: Исследование внедрения искусственного интеллекта за 1 полугодие 2025 года (отчет доступен на веб-сайте искусственного анализа)

389,07K

Поставщики Kimi K2: Groq обслуживает Kimi K2 на скорости >400 токенов/с, в 40 раз быстрее, чем API первого уровня Moonshot.

Поздравляем ряд поставщиков с быстрым запуском API для Kimi K2, включая @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra и, конечно, @Kimi_Moonshot. Это впечатляет, учитывая размер модели в 1 триллион параметров.

Groq выделяется своей молниеносной скоростью. DeepInfra, Novita и Baseten выделяются своими ценами, будучи единственными поставщиками, которые предлагают цены аналогичные или более низкие, чем у API первого уровня Moonshot.

Смотрите ниже для дальнейших сравнений между поставщиками. Мы ожидаем быстрого увеличения скорости у некоторых поставщиков, поскольку команды оптимизируют модель K2 - наши данные ниже показывают медианные скорости за последние 72 часа, но мы уже видим, что DeepInfra поднялся до 62 токенов/с в сегодняшних измерениях.

52,34K

В то время как Kimi k2 от Moonshot AI является ведущей моделью без рассуждений с открытыми весами в индексе искусственного интеллекта, она выводит в ~3 раза больше токенов, чем другие неразумные модели, стирая границы между рассуждениями и нерассуждениями

Kimi k2 - самая большая модель с открытыми весами - 1 Тл общих параметров при 32 Б активных (для этого требуется огромный 1 ТБ памяти на родной FP8 для удержания весов). У нас k2 на 57 месте в индексе искусственного интеллекта, впечатляющий результат, который ставит его выше таких моделей, как GPT-4.1 и DeepSeek V3, но отстает от ведущих моделей рассуждений.

До сих пор существовало четкое различие между разумной и неразумной моделями в наших оценках, определяемое не только тем <reasoning> , использует ли модель теги, но в первую очередь использованием токенов. Медианное количество токенов, используемых для ответа на все оценки в индексе искусственного интеллекта, в ~10 раз выше для разумных моделей, чем для неразумных моделей.

Kimi k2 @Kimi_Moonshot использует в ~3 раза больше токенов, чем медианная необоснованная модель. Его использование токенов всего на 30% ниже, чем у Claude 4 Sonnet и Opus при запуске в режиме расширенного мышления с максимальным бюджетом, и почти в три раза выше, чем у Claude 4 Sonnet и Opus с отключенным рассуждением.

Поэтому мы рекомендуем сравнивать Kimi k2 с Claude 4 Sonnet и Opus в их максимально бюджетных расширенных режимах мышления, а не с необоснованными оценками моделей Claude 4.

Kimi k2 доступен в собственном API @Kimi_Moonshot, а также в @FireworksAI_HQ, @togethercompute, @novita_labs и @parasail_io.

Смотрите ниже и на Искусственный анализ для дальнейшего анализа 👇

60,65K

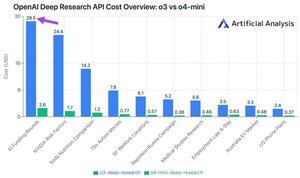

Новый API глубоких исследований OpenAI стоит до ~$30 за вызов API! Эти новые конечные точки API глубоких исследований могут стать новым самым быстрым способом потратить деньги

В ходе наших 10 глубоких тестовых запросов мы потратили $100 на o3 и $9,18 на o4-mini. Как затраты становятся такими большими? Высокие цены и миллионы токенов.

Эти конечные точки представляют собой версии o3 и o4-mini, которые были разработаны для выполнения задач глубоких исследований. Доступность через API позволяет использовать их как с инструментом веб-поиска OpenAI, так и с пользовательскими источниками данных через удаленные серверы MCP.

Цены на O4-Mini-Deep-Research в 5 раз ниже, чем на O3-Deep-Research. В наших тестовых запросах o4-mini также, похоже, использует меньше токенов - в общей сложности он оказался более чем в 10 раз дешевле по нашим 10 тестовым запросам.

Ценообразование:

➤ o3-deep-research стоит $10 /M вход ($2.50 кэшированный вход), $40 /M выход

➤ o4-mini-deep-research стоит $2/M input ($0.5 cached input), $8/M output

Эти конечные точки значительно дороже, чем стандартные конечные точки OpenAI o3 и o4-mini - они находятся по адресу:

➤ o3: $2 /M ($0,5 кэшированный) вход, $8 /M выход для o3

➤ o4-mini: $1,1 /M (0,275 кэшированного) вход, $4,4 /M выход

37,37K

Топ

Рейтинг

Избранное

В тренде ончейн

В тренде в Х

Самые инвестируемые

Наиболее известные