Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Analisi indipendente dei modelli di intelligenza artificiale e dei provider di hosting: scegli il modello e il fornitore API migliori per il tuo caso d'uso

DeepSeek lancia V3.1, unificando V3 e R1 in un modello ibrido di ragionamento con un incremento incrementale dell'intelligenza

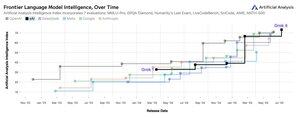

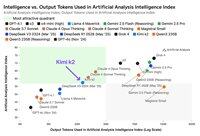

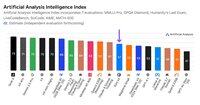

Incremento dell'intelligenza incrementale: I risultati iniziali di benchmarking per DeepSeek V3.1 mostrano un Indice di Intelligenza Analitica Artificiale di 60 in modalità ragionamento, in aumento rispetto al punteggio di 59 di R1. In modalità non ragionamento, V3.1 ottiene un punteggio di 49, un incremento maggiore rispetto al punteggio precedente di V3 0324 di 44. Questo lascia V3.1 (ragionamento) dietro l'ultimo Qwen3 235B 2507 di Alibaba (ragionamento) - DeepSeek non ha ripreso il comando.

Ragionamento ibrido: @deepseek_ai è passato per la prima volta a un modello di ragionamento ibrido - supportando sia modalità di ragionamento che non ragionamento. Il passaggio di DeepSeek a un modello di ragionamento ibrido unificato imita l'approccio adottato da OpenAI, Anthropic e Google. È interessante notare, tuttavia, che Alibaba ha recentemente abbandonato l'approccio ibrido che preferiva per Qwen3 con i loro rilasci separati dei modelli di ragionamento e istruzione di Qwen3 2507.

Chiamata di funzione / utilizzo di strumenti: Sebbene DeepSeek affermi di aver migliorato la chiamata di funzione per il modello, DeepSeek V3.1 non supporta la chiamata di funzione quando è in modalità ragionamento. Questo limiterà sostanzialmente la sua capacità di supportare flussi di lavoro agentici con requisiti di intelligenza, inclusi gli agenti di codifica.

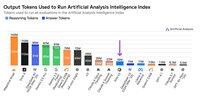

Utilizzo dei token: DeepSeek V3.1 ottiene punteggi incrementali più alti in modalità ragionamento rispetto a DeepSeek R1 e utilizza leggermente meno token nei valutazioni che utilizziamo per l'Indice di Intelligenza Analitica Artificiale. In modalità non ragionamento, utilizza leggermente più token rispetto a V3 0324 - ma comunque diverse volte meno rispetto alla sua stessa modalità di ragionamento.

API: L'API di prima parte di DeepSeek ora serve il nuovo modello DeepSeek V3.1 sia sui loro endpoint di chat che di ragionamento - cambiando semplicemente se il token di pensiero finale </think> è fornito al modello nel template di chat per controllare se il modello ragionerà.

Architettura: DeepSeek V3.1 è architettonicamente identico ai precedenti modelli V3 e R1, con 671B di parametri totali e 37B di parametri attivi.

Implicazioni: Consiglieremmo cautela nel fare qualsiasi assunzione su ciò che questa release implica riguardo ai progressi di DeepSeek verso un futuro modello indicato nei rumors come V4 o R2. Notiamo che DeepSeek ha precedentemente rilasciato il modello finale costruito sulla loro architettura V2 il 10 dicembre 2024, solo due settimane prima di rilasciare V3.

71,11K

Annuncio dell'Artificial Analysis Long Context Reasoning (AA-LCR), un nuovo benchmark per valutare le prestazioni su contesti lunghi attraverso il test delle capacità di ragionamento su più documenti lunghi (~100k token)

L'obiettivo di AA-LCR è replicare il lavoro reale di conoscenza e i compiti di ragionamento, testando capacità critiche per le moderne applicazioni di intelligenza artificiale che spaziano dall'analisi dei documenti, alla comprensione del codice, e ai complessi flussi di lavoro multi-step.

AA-LCR consiste in 100 domande difficili basate su testo che richiedono ragionamento attraverso più documenti reali che rappresentano ~100k token di input. Le domande sono progettate in modo che le risposte non possano essere trovate direttamente, ma debbano essere dedotte da più fonti di informazione, con test umani che verificano che ogni domanda richieda una vera inferenza piuttosto che un recupero.

Punti chiave:

➤ I modelli leader di oggi raggiungono un'accuratezza di ~70%: i primi tre posti vanno a OpenAI o3 (69%), xAI Grok 4 (68%) e Qwen3 235B 2507 Thinking (67%)

➤👀 Abbiamo già i risultati di gpt-oss! 120B si comporta vicino a o4-mini (alto), in linea con le affermazioni di OpenAI riguardo le prestazioni del modello. Seguirà a breve un Intelligence Index per i modelli.

➤ 100 domande difficili basate su testo che coprono 7 categorie di documenti (Relazioni Aziendali, Relazioni di Settore, Consultazioni Governative, Accademia, Legale, Materiali di Marketing e Relazioni di Indagine)

➤ ~100k token di input per domanda, richiedendo ai modelli di supportare una finestra di contesto minima di 128K per ottenere punteggi su questo benchmark

➤ ~3M di token di input unici totali che coprono ~230 documenti per eseguire il benchmark (i token di output variano tipicamente in base al modello)

➤ Il link al dataset su 🤗 @HuggingFace è qui sotto

Stiamo aggiungendo AA-LCR all'Artificial Analysis Intelligence Index, e portando il numero di versione a v2.2. L'Artificial Analysis Intelligence Index v2.2 ora include: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode e AA-LCR.

Tutti i numeri sono aggiornati sul sito ora. Scopri quali modelli sono inclusi nell'Artificial Analysis Intelligence Index v2.2 👇

28,8K

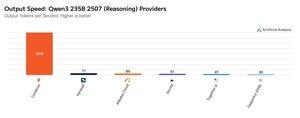

Cerebras ha dimostrato la sua capacità di ospitare grandi MoE a velocità molto elevate questa settimana, lanciando gli endpoint Qwen3 235B 2507 e Qwen3 Coder 480B a >1.500 token di output/s

➤ @CerebrasSystems ora offre endpoint sia per Qwen3 235B 2507 Reasoning che per Non-reasoning. Entrambi i modelli hanno parametri totali di 235B con 22B attivi.

➤ Qwen 3 235B 2507 Reasoning offre un'intelligenza paragonabile a o4-mini (high) e DeepSeek R1 0528. La variante Non-reasoning offre un'intelligenza paragonabile a Kimi K2 e ben superiore a GPT-4.1 e Llama 4 Maverick.

➤ Qwen3 Coder 480B ha parametri totali 480B con 35B attivi. Questo modello è particolarmente efficace per la codifica agentica e può essere utilizzato in una varietà di strumenti di agenti di codifica, tra cui l'interfaccia a riga di comando Qwen3-Coder.

I lanci di Cerebras rappresentano la prima volta che questo livello di intelligenza è stato accessibile a queste velocità di output e hanno il potenziale per sbloccare nuovi casi d'uso, come l'utilizzo di un modello di ragionamento per ogni fase di un agente senza dover attendere minuti.

25,28K

🇰🇷 LG ha recentemente lanciato EXAONE 4.0 32B - ottiene 62 nell'Artificial Analysis Intelligence Index, il punteggio più alto per un modello 32B fino ad ora.

L'EXAONE 4.0 di @LG_AI_Research è stato rilasciato in due varianti: il modello 32B di ragionamento ibrido di cui stiamo riportando i risultati di benchmarking qui, e un modello più piccolo da 1.2B progettato per applicazioni su dispositivo che non abbiamo ancora testato.

Insieme al recente rilascio di Solar Pro 2 di Upstage, è entusiasmante vedere i laboratori di intelligenza artificiale coreani unirsi a quelli degli Stati Uniti e della Cina vicino alla cima delle classifiche di intelligenza.

Risultati chiave:

➤ 🧠 EXAONE 4.0 32B (Ragionamento): In modalità ragionamento, EXAONE 4.0 ottiene 62 nell'Artificial Analysis Intelligence Index. Questo corrisponde a Claude 4 Opus e al nuovo Llama Nemotron Super 49B v1.5 di NVIDIA, e si posiziona solo 1 punto dietro Gemini 2.5 Flash.

➤ ⚡ EXAONE 4.0 32B (Non-Ragionamento): In modalità non-ragionamento, EXAONE 4.0 ottiene 51 nell'Artificial Analysis Intelligence Index. Corrisponde a Llama 4 Maverick in intelligenza nonostante abbia solo ~1/4 dei parametri totali (anche se ha ~2x i parametri attivi).

➤ ⚙️ Token di output e verbosità: In modalità ragionamento, EXAONE 4.0 ha utilizzato 100M di token di output per l'Artificial Analysis Intelligence Index. Questo è superiore a molti altri modelli all'avanguardia, ma si allinea con le recenti tendenze dei modelli di ragionamento che utilizzano più token di output per 'pensare di più' - simile a Llama Nemotron Super 49B v1.5, Grok 4 e Qwen3 235B 2507 Reasoning. In modalità non-ragionamento, EXAONE 4.0 ha utilizzato 15M di token - alto per un non-ragionatore, ma non così alto come i 30M di Kimi K2.

Dettagli chiave:

➤ Ragionamento ibrido: Il modello offre opzioni tra modalità 'ragionamento' e modalità 'non-ragionamento'.

➤ Disponibilità: Attualmente ospitato da @friendliai, e a un prezzo competitivo (soprattutto rispetto alle opzioni proprietarie) da FriendliAI a $1 per 1M di token di input e output.

➤ Pesi aperti: EXAONE 4.0 è un modello a pesi aperti disponibile sotto l'EXAONE AI Model License Agreement 1.2. La licenza limita l'uso commerciale.

➤ Multimodalità: Solo input e output testuali.

➤ Finestra di contesto: 131k token.

➤ Parametri: 32B di parametri attivi e totali, disponibili in precisione 16bit e 8bit (significa che il modello può essere eseguito su un singolo chip H100 in piena precisione).

41,65K

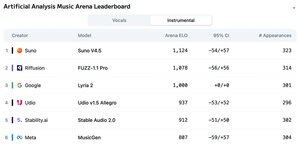

Annunciamo la classifica dell'Arena di Analisi Musicale Artificiale: con oltre 5.000 voti, Suno v4.5 è il modello di generazione musicale leader, seguito da FUZZ-1.1 Pro di Riffusion.

Lyria 2 di Google si piazza al terzo posto nella nostra classifica strumentale, e v1.5 Allegro di Udio si piazza al terzo posto nella nostra classifica vocale.

La classifica strumentale è la seguente:

🥇 @SunoMusic V4.5

🥈 @riffusionai FUZZ-1.1 Pro

🥉 @GoogleDeepMind Lyria 2

@udiomusic v1.5 Allegro

@StabilityAI Stable Audio 2.0

@metaai MusicGen

Le classifiche si basano sui voti della comunità su una vasta gamma di generi e suggerimenti. Vuoi vedere il tuo suggerimento in evidenza? Puoi inviare suggerimenti nell'arena oggi.

👇 Vedi qui sotto la classifica vocale e il link per partecipare!

22,27K

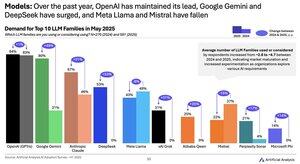

Cambiamento della domanda di modelli dal 2024 al 2025: Google (+49 punti), DeepSeek (+53 punti) e xAI (+31 punti) hanno ottenuto enormi guadagni nella quota di domanda nell'ultimo anno

@Google è passata dall'essere un ritardatario dell'IA a un leader dell'IA con un aumento di ~2,5 volte della percentuale di intervistati che utilizzano o considerano la serie di modelli Gemini. Un fattore chiave di questo è stato Google che ha ottenuto guadagni significativi in termini di intelligenza: Gemini 2.5 Pro si trova ora al #3 nel nostro indice di intelligenza artificiale, rispetto a OpenAI e Anthropic all'inizio del 2024.

@deepseek_ai nel primo semestre del 2024 aveva rilasciato solo DeepSeek 67B, un modello che ha visto un'adozione limitata e ha sottoperformato il Llama 3 70B. DeepSeek ha visto per la prima volta una certa adozione alla fine del 2024 con il rilascio del suo modello V2, e poi ha visto una rapida adozione all'inizio del 2025 con i suoi modelli V3 e R1 che l'hanno portata alla leadership tra i modelli a peso aperto.

@xai ha rilasciato il suo primo modello Grok-1 a metà del primo semestre del 2024 e da allora è rapidamente salito alla leadership dell'intelligence in tutti i modelli con rilasci successivi, culminati nel lancio della scorsa settimana di Grok 4.

Fonte: Artificial Analysis AI Adoption Survey H1 2025 (rapporto disponibile sul sito web di Artificial Analysis)

389,12K

Fornitori Kimi K2: Groq sta servendo Kimi K2 a >400 token di output/s, 40 volte più veloce dell'API di prima parte di Moonshot.

Congratulazioni a diversi fornitori per essere stati rapidi nel lanciare API per Kimi K2, tra cui @GroqInc, @basetenco, @togethercompute, @FireworksAI_HQ, @parasail_io, @novita_labs, @DeepInfra e ovviamente @Kimi_Moonshot. Questo è impressionante considerando le dimensioni del modello con 1 trilione di parametri totali.

Groq si distingue per la velocità fulminea. DeepInfra, Novita e Baseten si distinguono per i loro prezzi, essendo gli unici fornitori a offrire prezzi simili o più economici rispetto all'API di prima parte di Moonshot.

Vedi di seguito ulteriori confronti tra i fornitori. Ci aspettiamo rapidi aumenti di velocità tra alcuni fornitori mentre i team ottimizzano per il modello K2 - i nostri numeri qui sotto mostrano le velocità medie delle ultime 72 ore, ma stiamo già vedendo DeepInfra salire a 62 token/s nelle misurazioni di oggi.

52,4K

Sebbene Kimi k2 di Moonshot AI sia il principale modello di non ragionamento a pesi aperti nell'Artificial Analysis Intelligence Index, produce ~3 volte più token rispetto ad altri modelli non di ragionamento, offuscando i confini tra ragionamento e non ragionamento

Kimi k2 è il più grande modello a pesi aperti di sempre - parametri totali 1T con 32B attivi (questo richiede un enorme 1TB di memoria a FP8 nativo per sostenere i pesi). Abbiamo k2 a 57 nell'Artificial Analysis Intelligence Index, un punteggio impressionante che lo pone al di sopra di modelli come GPT-4.1 e DeepSeek V3, ma dietro ai principali modelli di ragionamento.

Fino ad ora, c'è stata una chiara distinzione tra modello di ragionamento e modelli non di ragionamento nelle nostre valutazioni, definita non solo dal fatto che il modello utilizzi <reasoning> i tag, ma principalmente dall'uso dei token. Il numero mediano di token utilizzati per rispondere a tutte le valutazioni nell'Artificial Analysis Intelligence Index è ~10 volte superiore per i modelli di ragionamento rispetto ai modelli non di ragionamento.

Kimi k2 di @Kimi_Moonshot utilizza ~3 volte il numero di token utilizzato dal modello mediano non ragionante. Il suo utilizzo di token è inferiore solo fino al 30% rispetto a Claude 4 Sonnet e Opus quando viene eseguito nella loro modalità di pensiero estesa con budget massimo, ed è quasi il triplo dell'utilizzo di token sia di Claude 4 Sonnet che di Opus con il ragionamento disattivato.

Raccomandiamo quindi che Kimi k2 sia paragonato a Claude 4 Sonnet e Opus nelle loro modalità di pensiero esteso con il budget massimo, non ai punteggi non ragionanti per i modelli Claude 4.

Kimi k2 è disponibile sulle API proprietarie di @Kimi_Moonshot, nonché su @FireworksAI_HQ, @togethercompute, @novita_labs e @parasail_io.

Vedi sotto e su Analisi Artificiale per ulteriori analisi 👇

60,7K

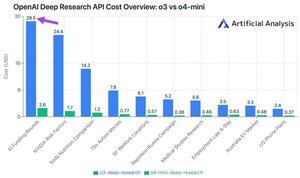

La nuova API Deep Research di OpenAI costa fino a ~$30 per chiamata API! Questi nuovi endpoint API di ricerca approfondita potrebbero essere il nuovo modo più veloce per spendere soldi

Tra le nostre 10 query di test di ricerca approfondita, abbiamo speso $ 100 su o3 e $ 9,18 su o4-mini. Come fanno i costi a diventare così grandi? Prezzi alti e milioni di token.

Questi endpoint sono versioni di o3 e o4-mini che sono state RL'd per attività di ricerca approfondita. La disponibilità tramite API consente di utilizzarli sia con lo strumento di ricerca web di OpenAI che con fonti di dati personalizzate tramite server MCP remoti.

Il prezzo di O4-Mini-Deep-Research è 5 volte inferiore a quello di O3-Deep-Research. Nelle nostre query di test, o4-mini sembra anche utilizzare meno token: è arrivato in totale oltre 10 volte più economico nelle nostre 10 query di test.

Prezzi:

➤ o3-deep-research ha un prezzo di $ 10 / M in ingresso ($ 2,50 in ingresso memorizzato nella cache), $ 40 / M in uscita

➤ o4-mini-deep-research ha un prezzo di $ 2 / M in ingresso ($ 0,5 in ingresso nella cache), $ 8 / M in uscita

Questi endpoint sono entrambi sostanzialmente più costosi degli endpoint o3 e o4-mini standard di OpenAI, che si trovano a:

➤ o3: $2/M ($0,5 cache) in ingresso, $8/M in uscita per o3

➤ o4-mini: $ 1,1 /M (0,275 cache) in ingresso, $ 4,4 /M in uscita

37,42K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari