Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Artificial Analysis

Незалежний аналіз моделей штучного інтелекту та хостинг-провайдерів - виберіть найкращу модель та API провайдера для вашого випадку використання

DeepSeek запускає версію 3.1, об'єднуючи V3 і R1 у гібридну модель міркувань з поступовим зростанням інтелекту

Поступове збільшення інтелекту: Початкові результати порівняльного аналізу для DeepSeek V3.1 показують, що індекс інтелекту штучного аналізу становить 60 балів у режимі міркувань, порівняно з результатом R1 у 59 балів. У режимі без міркувань V3.1 досягає 49 балів, що є більшим збільшенням порівняно з попереднім результатом V3 0324 у 44 балах. Це залишає V3.1 (міркування) позаду останнього Qwen3 235B 2507 від Alibaba (міркування) - DeepSeek не повернув собі лідерство.

Гібридне міркування: @deepseek_ai вперше перейшов до гібридної моделі міркування, підтримуючи як режими міркування, так і способи неміркування. Перехід DeepSeek до єдиної гібридної моделі міркувань імітує підхід, прийнятий OpenAI, Anthropic і Google. Цікаво, однак, відзначити, що Alibaba нещодавно відмовилася від свого гібридного підходу, якому вони віддали перевагу для Qwen3, випустивши окремі випуски моделей міркувань та інструкцій Qwen3 2507.

Виклик функцій / використання інструменту: У той час як DeepSeek заявляє про покращений виклик функцій для моделі, DeepSeek V3.1 не підтримує виклик функцій у режимі міркування. Це, ймовірно, суттєво обмежить його здатність підтримувати агентські робочі процеси з вимогами до інтелекту, у тому числі в агентах кодування.

Використання токенів: DeepSeek V3.1 отримує поступово вищі бали в режимі міркувань, ніж DeepSeek R1, і використовує трохи менше токенів у всіх показниках, які ми використовуємо для індексу інтелекту штучного аналізу. У режимі без міркувань він використовує трохи більше токенів, ніж V3 0324 - але все одно в кілька разів менше, ніж у власному режимі міркування.

API: Перший сторонній API DeepSeek тепер обслуговує нову модель DeepSeek V3.1 як на їхніх кінцевих точках чату, так і на кінцевих точках міркувань - просто змінюючи, чи надається токен кінцевого мислення </think> моделі в шаблоні чату, щоб контролювати, чи буде модель міркувати.

Архітектура: DeepSeek V3.1 архітектурно ідентична попереднім моделям V3 і R1, із загальними параметрами 671B і 37B активними параметрами.

Наслідки: Ми б радили з обережністю робити будь-які припущення про те, що цей реліз означає про прогрес DeepSeek у напрямку майбутньої моделі, яку в чутках називають V4 або R2. Зазначимо, що раніше DeepSeek випустила фінальну модель, побудовану на їхній архітектурі V2, 10 грудня 2024 року, всього за два тижні до релізу V3.

71,15K

Анонс Artificial Analysis Long Context Reasoning (AA-LCR), нового тесту для оцінки продуктивності тривалого контексту шляхом тестування можливостей міркування на кількох довгих документах (~100 тис. токенів)

Основна увага AA-LCR зосереджена на відтворенні реальних завдань із знаннями та міркуванням, можливостях тестування, критично важливих для сучасних додатків штучного інтелекту, що охоплюють аналіз документів, розуміння кодової бази та складні багатоетапні робочі процеси.

AA-LCR — це 100 складних текстових запитань, які вимагають обґрунтування в кількох реальних документах, які представляють ~100 тисяч вхідних токенів. Запитання розроблені таким чином, що відповіді не можуть бути знайдені безпосередньо, а мають бути аргументовані з кількох джерел інформації, а тестування на людях перевіряє, що кожне запитання вимагає справжнього висновку, а не пошуку.

Ключові моменти:

➤ Провідні моделі сьогодні досягають точності ~70%: перші три місця займають OpenAI o3 (69%), xAI Grok 4 (68%) та Qwen3 235B 2507 Thinking (67%)

👀 ➤ У нас також вже є результати gpt-oss! 120B працює близько до o4-mini (високий), що відповідає заявам OpenAI щодо продуктивності моделі. Незабаром ми представимо Індекс інтелекту для моделей.

➤ 100 складних текстових запитань, що охоплюють 7 категорій документів (звіти компаній, галузеві звіти, урядові консультації, наукові кола, юридичні, маркетингові матеріали та звіти про опитування)

➤ ~100 тисяч токенів вхідних даних на запитання, що вимагає, щоб моделі підтримували мінімум 128 тисяч контекстного вікна, щоб отримати оцінку за цим тестом

➤ ~3M унікальних вхідних токенів, що охоплюють ~230 документів для запуску тесту (вихідні токени зазвичай варіюються залежно від моделі)

➤ Посилання на набір даних про 🤗 @HuggingFace нижче

Ми додаємо AA-LCR до Індексу штучного аналізу інтелекту та переносимо номер версії до версії 2.2. Індекс штучного аналізу інтелекту v2.2 тепер включає: MMLU-Pro, GPQA Diamond, AIME 2025, IFBench, LiveCodeBench, SciCode та AA-LCR.

Зараз на сайті оновлюються всі цифри. Дізнайтеся, які моделі Artificial Analysis Intelligence Index v2.2 👇

28,84K

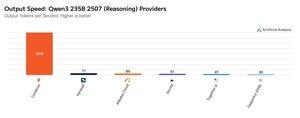

Цього тижня Cerebras продемонструвала свою здатність розміщувати великі MoEs на дуже високих швидкостях, запустивши кінцеві точки Qwen3 235B 2507 та Qwen3 Coder 480B зі швидкістю >1 500 вихідних токенів/с

➤ @CerebrasSystems тепер пропонує кінцеві точки для міркувань і неміркувань Qwen3 235B 2507. Обидві моделі мають загальні параметри 235В при 22В активних.

➤ Qwen 3 235B 2507 Reasoning пропонує інтелект, який можна порівняти з o4-mini (високий) і DeepSeek R1 0528. Варіант Non-reasoning пропонує інтелект, який можна порівняти з Kimi K2 і значно перевищує GPT-4.1 і Llama 4 Maverick.

➤ Qwen3 Coder 480B має загальні параметри 480B при 35B активних. Ця модель особливо потужна для агентного кодування і може використовуватися в різних інструментах кодувальних агентів, включаючи Qwen3-Coder CLI.

Запуск Cerebras є першим випадком, коли цей рівень інтелекту був доступний на таких вихідних швидкостях і має потенціал для відкриття нових варіантів використання - наприклад, використання моделі міркування для кожного кроку агента без необхідності чекати кілька хвилин.

25,32K

Найкращі

Рейтинг

Вибране