Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Não se pode construir produtos de IA como outros produtos.

Os produtos de IA são inerentemente não determinísticos, e você precisa constantemente negociar o equilíbrio entre agência e controle.

Quando as equipes não reconhecem essas diferenças, seus produtos enfrentam falhas inesperadas, ficam presos depurando grandes sistemas complicados que não conseguem rastrear, e a confiança do usuário no produto se erode silenciosamente.

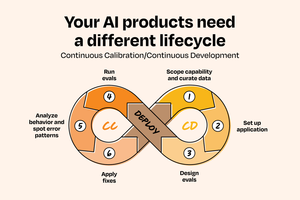

Após observar esse padrão se desenrolar em mais de 50 implementações de IA em empresas como @OpenAI, @Google, @Amazon e @Databricks, Aishwarya Naresh Reganti e Kiriti Badam desenvolveram uma solução: o framework de Calibração Contínua/Desenvolvimento Contínuo (CC/CD).

O nome é uma referência à Integração Contínua/Implantação Contínua (CI/CD), mas, ao contrário de seu homônimo, é destinado a sistemas onde o comportamento é não determinístico e a agência precisa ser conquistada.

Este framework mostra como:

- Começar com recursos de alto controle e baixa agência

- Construir sistemas de avaliação que realmente funcionam

- Escalar produtos de IA sem quebrar a confiança do usuário

É projetado para reconhecer a singularidade dos sistemas de IA e ajudar você a construir produtos de IA mais intencionais, estáveis e confiáveis.

Eles estão compartilhando isso publicamente pela primeira vez:

120,5K

Top

Classificação

Favoritos