Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Du kan ikke bygge AI-produkter som andre produkter.

AI-produkter er iboende ikke-deterministiske, og du må hele tiden forhandle om avveiningen mellom handlekraft og kontroll.

Når teamene ikke gjenkjenner disse forskjellene, står produktene deres overfor uventede feil, de blir sittende fast med å feilsøke store kompliserte systemer de ikke kan spore, og brukernes tillit til produktet eroderer stille.

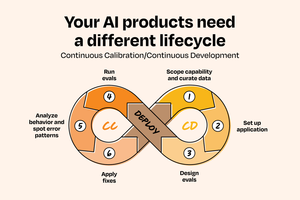

Etter å ha sett dette mønsteret utspille seg på tvers av 50+ AI-implementeringer hos selskaper inkludert @OpenAI, @Google, @Amazon og @Databricks, utviklet Aishwarya Naresh Reganti og Kiriti Badam en løsning: rammeverket Continuous Calibration/Continuous Development (CC/CD).

Navnet er en referanse til Continuous Integration/Continuous Deployment (CI/CD), men i motsetning til navnebroren er det ment for systemer der atferden er ikke-deterministisk og handlefrihet må fortjenes.

Dette rammeverket viser deg hvordan du kan:

- Start med funksjoner med høy kontroll og lite byrå

- Bygge evalueringssystemer som faktisk fungerer

- Skaler AI-produkter uten å bryte brukernes tillit

Den er utformet for å gjenkjenne det unike ved AI-systemer og hjelpe deg med å bygge mer tilsiktede, stabile og pålitelige AI-produkter.

De deler det offentlig for første gang:

120,49K

Topp

Rangering

Favoritter