Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Je kunt AI-producten niet bouwen zoals andere producten.

AI-producten zijn van nature niet-deterministisch, en je moet voortdurend de afweging maken tussen autonomie en controle.

Wanneer teams deze verschillen niet erkennen, krijgen hun producten te maken met onverwachte fouten, zitten ze vast in het debuggen van grote ingewikkelde systemen die ze niet kunnen traceren, en het vertrouwen van de gebruiker in het product vervaagt stilletjes.

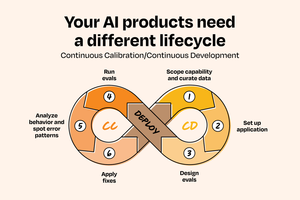

Na het zien van dit patroon bij meer dan 50 AI-implementaties bij bedrijven zoals @OpenAI, @Google, @Amazon en @Databricks, ontwikkelden Aishwarya Naresh Reganti en Kiriti Badam een oplossing: het Continuous Calibration/Continuous Development (CC/CD) framework.

De naam is een verwijzing naar Continuous Integration/Continuous Deployment (CI/CD), maar in tegenstelling tot zijn naamgenoot is het bedoeld voor systemen waar het gedrag niet-deterministisch is en autonomie verdiend moet worden.

Dit framework laat je zien hoe je:

- Begin met functies met hoge controle en lage autonomie

- Evaluatiesystemen bouwt die daadwerkelijk werken

- AI-producten schaalt zonder het vertrouwen van de gebruiker te schaden

Het is ontworpen om de uniciteit van AI-systemen te erkennen en je te helpen om meer intentionele, stabiele en betrouwbare AI-producten te bouwen.

Ze delen het voor het eerst publiekelijk:

120,48K

Boven

Positie

Favorieten