Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hva skal til for at en datamaskin skal lære reglene for RNA-baseparing?

Folk trener store språkmodeller for prediksjon av RNA-struktur. Noen av disse modellene har hundrevis av millioner parametere.

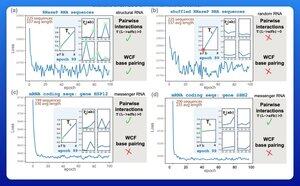

Et spennende tidlig resultat har vært at disse modellene lærer reglene for Watson-Crick-Franklin baseparing direkte fra data.

En forskergruppe ved Harvard bestemte seg for å se hva den minste mulige modellen var som kunne oppnå dette resultatet.

De trente opp en liten probabilistisk modell med bare 21 parametere ved hjelp av gradient descent.

Med så få som 50 RNA-sekvenser – uten tilsvarende strukturer – ville reglene for baseparing dukke opp etter bare noen få treningsepoker.

Så svaret på det opprinnelige spørsmålet deres var at det tar "mye mindre enn du kanskje tror" for å lære denne typen modell.

Jeg tror ikke dette betyr at den storstilte opplæringsinnsatsen nødvendigvis er dum eller misforstått. Men dette resultatet antyder at det fortsatt er mye effektivitet og ytelse som fortsatt kan hentes ut av arkitekturinnovasjon.

Det er mye underliggende struktur i biologiens språk.

3,24K

Topp

Rangering

Favoritter