Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Qu'est-ce qu'il faut pour qu'un ordinateur apprenne les règles de l'appariement des bases de l'ARN ?

Des personnes entraînent de grands modèles de langage pour la prédiction de la structure de l'ARN. Certains de ces modèles ont des centaines de millions de paramètres.

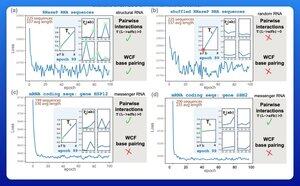

Un résultat précoce excitant a été que ces modèles apprennent les règles de l'appariement des bases de Watson-Crick-Franklin directement à partir des données.

Un groupe de recherche à Harvard a décidé de voir quel était le plus petit modèle possible capable d'atteindre ce résultat.

Ils ont entraîné un petit modèle probabiliste avec seulement 21 paramètres en utilisant la descente de gradient.

Avec aussi peu que 50 séquences d'ARN—sans structures correspondantes—les règles de l'appariement des bases apparaissaient après seulement quelques époques d'entraînement.

Ainsi, la réponse à leur question initiale était qu'il faut "beaucoup moins que ce que vous pourriez penser" pour apprendre ce type de modèle.

Je ne pense pas que cela signifie que les efforts d'entraînement à grande échelle soient nécessairement stupides ou mal orientés. Mais ce résultat suggère qu'il y a beaucoup d'efficacité et de performance qui peuvent encore être extraites de l'innovation architecturale.

Il y a beaucoup de structure sous-jacente dans le langage de la biologie.

3,26K

Meilleurs

Classement

Favoris