Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tässä on tämän viikon Ritual Research Digest, uutiskirje, joka kattaa viimeisimmät LLM-maailman ja Crypto x AI:n risteyskohdan.

Viikoittain julkaistaan satoja lehtiä, joten on mahdotonta pysyä ajan tasalla uusimmasta uutisesta. Me teemme lukemisen, jotta sinun ei tarvitse.

Monimoduulinen GRPO: Käytäntögradienttien laatiminen ja kehoteoptimointi kielimalliohjelmille

Tässä artikkelissa tarkastellaan, voidaanko jälkikoulutusta soveltaa nopeaan optimointikehykseen.

Tämä on ensimmäinen GRPO:n käyttöönotto monimutkaisiin LLM-putkiin. MM-GRPO-menetelmä parantaa suorituskykyä keskimäärin 7 % vanilja-CoT:tä vastaan. Vaikka se ei aina ylitä nopeaa optimointia, se on aina tehokas kohteliaisuus.

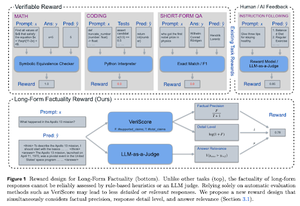

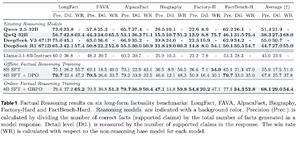

Opi perustelemaan tosiasioita

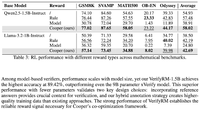

Tässä artikkelissa kehitetään palkitsemisfunktiota pitkän CoT:n (Chain of Thought) kouluttamisesta tosiasioihin liittyen. Niiden muotoilu lopettaa hakkeroinnin palkitsemisen suosimalla tarkkuutta, yksityiskohtia ja laatua samanaikaisesti.

He havaitsivat, että heidän palkitsemisfunktionsa RL:ssä ylittää perusmallin (Llama-3.1-8B-Instruct) kaikissa mittareissa useissa tietojoukoissa. Nykyiset päättelyn LLM:t (QwQ, R1) kärsivät tosiasiallisuuden heikkenemisestä verrattuna perusmalliinsa (Qwen 2.5 32B, DS v3).

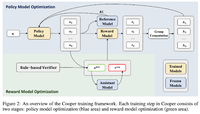

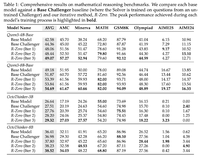

Cooper: Politiikan ja palkitsemismallien yhteisoptimointi vahvistusoppimisessa suurille kielimalleille

Tässä artikkelissa he ehdottavat RL-menetelmää, Cooperia, joka kouluttaa politiikkamallia ja palkitsemismallia samanaikaisesti.

He julkaisevat palkitsemismallinnuksen tietojoukon, joka on merkitty strategialla, jossa yhdistyvät sääntöihin perustuva ja LLM-as-a-judge-todentaminen. He huomaavat, että palkitsemismallin dynaaminen säätäminen RL:n aikana voi tehokkaasti lieventää palkkiohakkerointia.

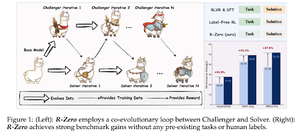

R-Zero: Itsestään kehittyvä päättely LLM nolladatasta

Tässä artikkelissa he ehdottavat R-Zeroa päättelyn LLM:ien kouluttamiseen, jotka voivat kehittyä itsestään 0 ulkoisesta datasta. Sama malli on alustettu kahdella roolilla (Challenger/Solver), jotka kehittyvät yhdessä RL:ssä.

Haastaja palkitaan siitä, että hän luo tehtäviä, jotka ovat vaikeita ratkaisijan nykyisille kyvyille, kun taas ratkaisija palkitaan näiden haastajan asettamien yhä vaikeampien tehtävien ratkaisemisesta. R-Zero on malliagnostinen kehys, ja ne osoittavat etuja Qwen3-4b-malliin verrattuna.

He esittelevät myös CompassVerifierin, joka on vankkojen todentamismallien perhe. Koulutettu alkuperäisen penkin tiedoilla, kaavalla parannetulla tiedolla ja hallusinaatiotiedoilla. Heidän mallinsa toimii paremmin kuin muut mallit, kuten Qwen2.5 & 3 -sarjat, ja se on hyödyllinen myös palkitsemismallina.

Seuraa meitä @ritualdigest saadaksesi lisätietoja kaikesta Crypto x AI -tutkimuksesta ja @ritualnet saadaksesi lisätietoja siitä, mitä Ritual rakentaa.

6,23K

Johtavat

Rankkaus

Suosikit