Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aquí está el Digest de Investigación Ritual de esta semana, un boletín que cubre lo último en el mundo de los LLM y la intersección de Crypto x AI.

Con cientos de artículos publicados semanalmente, mantenerse al día con lo último es imposible. Nosotros haremos la lectura para que tú no tengas que hacerlo.

Multi-Módulo GRPO: Composición de Gradientes de Política y Optimización de Prompts para Programas de Modelos de Lenguaje

Este artículo explora si se puede aplicar el post-entrenamiento a los marcos de optimización de prompts.

Esta es la primera implementación de GRPO en complejas tuberías de LLM. El método MM-GRPO mejora el rendimiento en un 7% en promedio en comparación con CoT básico. Aunque no siempre supera la optimización de prompts, siempre es un complemento efectivo.

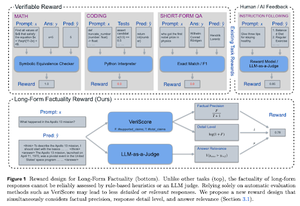

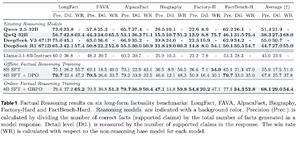

Aprendiendo a Razonar por la Veracidad

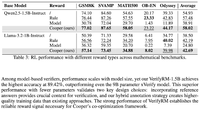

Este documento desarrolla una función de recompensa para entrenar CoT (Cadena de Pensamiento) largo para la veracidad. Su diseño detiene el hacking de recompensas al favorecer la precisión, el detalle y la calidad al mismo tiempo.

Encuentran que su función de recompensa en RL supera al modelo base (Llama-3.1-8B-Instruct) en todas las métricas a través de varios conjuntos de datos. Los LLMs de razonamiento existentes (QwQ, R1) sufren una disminución en la factualidad en comparación con su modelo base (Qwen 2.5 32B, DS v3).

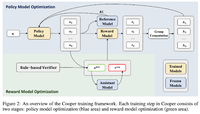

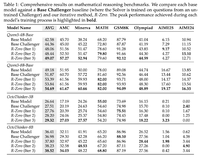

Cooper: Co-Optimizando Modelos de Política y Recompensa en Aprendizaje por Refuerzo para Modelos de Lenguaje Grandes

En este artículo, proponen un método de RL, Cooper, que entrena el modelo de política y el modelo de recompensa simultáneamente.

Liberan un conjunto de datos de modelado de recompensas, que está etiquetado utilizando una estrategia que combina verificación basada en reglas y LLM como juez. Encuentran que ajustar dinámicamente el modelo de recompensas durante el RL puede mitigar efectivamente el hacking de recompensas.

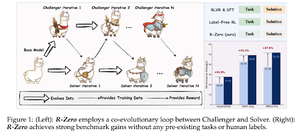

R-Zero: LLM de razonamiento auto-evolutivo desde cero datos

En este artículo, proponen R-Zero para entrenar LLMs de razonamiento que pueden auto-evolucionar a partir de 0 datos externos. El mismo modelo se inicializa con dos roles (Desafiante/Resolutor) que co-evolucionan en RL.

El Challenger es recompensado por generar tareas que son difíciles para las habilidades actuales del Solver, mientras que el Solver es recompensado por resolver estas tareas cada vez más difíciles planteadas por el Challenger. R-Zero es un marco independiente del modelo, y muestran ganancias en el modelo Qwen3-4b.

También presentan CompassVerifier, una familia de modelos de verificación robustos. Entrenados con datos del banco original, datos mejorados por fórmulas y datos de alucinación. Su modelo tiene un mejor rendimiento que otros modelos como Qwen2.5 y la serie 3, y es útil como modelo de recompensa también.

Síguenos en @ritualdigest para más información sobre todo lo relacionado con la investigación de Crypto x AI, y en @ritualnet para aprender más sobre lo que Ritual está construyendo.

4.19K

Populares

Ranking

Favoritas