المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

إليكم ملخص Ritual Research Digest لهذا الأسبوع ، وهي نشرة إخبارية تغطي أحدث ما في عالم LLMs وتقاطع Crypto x الذكاء الاصطناعي.

مع نشر مئات الصحف أسبوعيا ، من المستحيل البقاء على اطلاع دائم بالأحدث الصحف. سنقوم بالقراءة حتى لا تضطر إلى ذلك.

GRPO متعدد الوحدات: إنشاء تدرجات السياسة والتحسين الفوري لبرامج نماذج اللغة

تستكشف هذه الورقة ما إذا كان يمكن تطبيق ما بعد التدريب على أطر التحسين السريعة.

هذا هو أول تنفيذ ل GRPO لخطوط أنابيب LLM المعقدة. تعمل طريقة MM-GRPO على تحسين الأداء بنسبة 7٪ في المتوسط مقابل CoT. على الرغم من أنه لا يتجاوز دائما التحسين الفوري ، إلا أنه دائما ما يكون مجاملة فعالة.

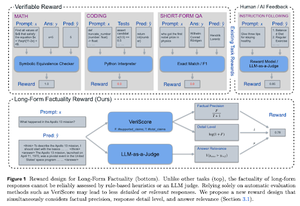

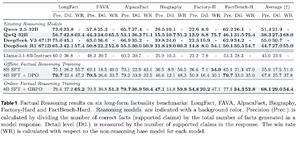

تعلم التفكير في الواقعية

تطور هذه الورقة وظيفة مكافأة لتدريب CoT (سلسلة الفكر) الطويلة من أجل الواقعية. يوقف تصميمها مكافأة القرصنة من خلال تفضيل الدقة والتفاصيل والجودة في نفس الوقت.

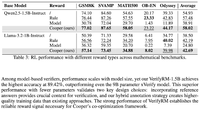

وجدوا أن وظيفة المكافأة الخاصة بهم في RL تتفوق على النموذج الأساسي (Llama-3.1-8B-Instruct) في جميع المقاييس عبر العديد من مجموعات البيانات. تعاني LLMs المنطقية الحالية (QwQ ، R1) من انخفاض الواقعية مقارنة بنموذجها الأساسي (Qwen 2.5 32B ، DS v3).

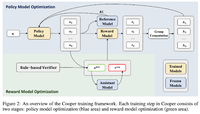

كوبر: التحسين المشترك للسياسة ونماذج المكافآت في التعلم المعزز لنماذج اللغات الكبيرة

في هذه الورقة ، يقترحون طريقة RL ، Cooper ، التي تدرب نموذج السياسة ونموذج المكافأة في وقت واحد.

يطلقون مجموعة بيانات نمذجة المكافآت ، والتي يتم تصنيفها باستخدام استراتيجية تجمع بين التحقق القائم على القواعد والتحقق من LLM-as-a-قاضي. وجدوا أن التعديل الديناميكي لنموذج المكافأة أثناء RL يمكن أن يخفف بشكل فعال من قرصنة المكافآت.

R-Zero: المنطق الذاتي المتطور LLM من Zero Data

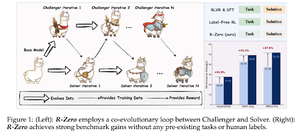

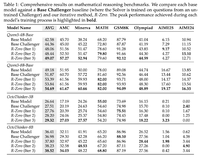

في هذه الورقة ، يقترحون R-Zero لتدريب LLMs المنطقي الذي يمكن أن يتطور ذاتيا من 0 بيانات خارجية. تتم تهيئة نفس النموذج بدورين (Challenger / Solver) يتطوران بشكل مشترك في RL.

يكافأ Challenger على توليد المهام التي يصعب على قدرات الحل الحالية ، بينما يكافأ الحل على حل هذه المهام الصعبة بشكل متزايد التي يطرحها المتحدي. R-Zero هو إطار عمل غير محدد للنموذج ، ويظهرون مكاسب في نموذج Qwen3-4b.

كما يقدمون CompassVerifier ، وهي مجموعة من نماذج التحقق القوية. تم تدريبه على البيانات من مقاعد البدلاء الأصلية والبيانات المحسنة بالصيغة وبيانات الهلوسة. يعمل نموذجهم بشكل أفضل من النماذج الأخرى مثل سلسلة Qwen2.5 و 3 وهو مفيد كنموذج مكافأة أيضا.

تابعنا @ritualdigest لمعرفة المزيد عن كل ما يتعلق بأبحاث Crypto x الذكاء الاصطناعي ، @ritualnet لمعرفة المزيد حول ما تبنيه Ritual.

6.15K

الأفضل

المُتصدِّرة

التطبيقات المفضلة