Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Berikut adalah Ritual Research Digest minggu ini, buletin yang mencakup yang terbaru di dunia LLM dan persimpangan Crypto x AI.

Dengan ratusan makalah yang diterbitkan setiap minggu, tidak mungkin mengikuti perkembangan terbaru. Kami akan melakukan pembacaan sehingga Anda tidak perlu melakukannya.

GRPO Multi-Modul: Menyusun Gradien Kebijakan dan Pengoptimalan Prompt untuk Program Model Bahasa

Makalah ini mengeksplorasi apakah pasca-pelatihan dapat diterapkan pada kerangka kerja pengoptimalan prompt.

Ini adalah implementasi pertama GRPO untuk pipeline LLM yang kompleks. Metode MM-GRPO meningkatkan kinerja rata-rata 7% terhadap vanilla CoT. Meskipun tidak selalu melampaui pengoptimalan prompt, itu selalu merupakan pujian yang efektif.

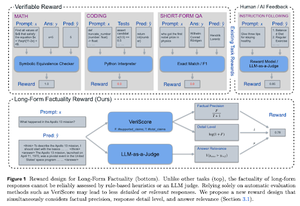

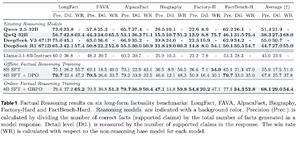

Belajar Alasan untuk Faktualitas

Makalah ini mengembangkan fungsi penghargaan untuk melatih CoT (Chain of Thought) yang panjang untuk faktualitas. Desain mereka berhenti menghargai peretasan dengan mengutamakan presisi, detail, dan kualitas pada saat yang bersamaan.

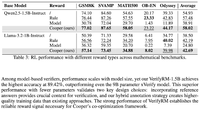

Mereka menemukan bahwa fungsi hadiah mereka di RL mengungguli model dasar (Llama-3.1-8B-Instruct) di semua metrik di beberapa kumpulan data. LLM penalaran yang ada (QwQ, R1) mengalami penurunan faktualitas dibandingkan dengan model dasarnya (Qwen 2.5 32B, DS v3).

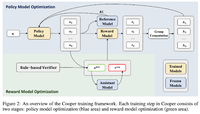

Cooper: Mengoptimalkan Kebijakan Bersama dan Model Penghargaan dalam Pembelajaran Penguatan untuk Model Bahasa Besar

Dalam makalah ini, mereka mengusulkan metode RL, Cooper, yang melatih model kebijakan dan model penghargaan secara bersamaan.

Mereka merilis kumpulan data pemodelan hadiah, yang diberi label menggunakan strategi yang menggabungkan verifikasi berbasis aturan dan LLM-as-a-judge. Mereka menemukan bahwa menyesuaikan model hadiah secara dinamis selama RL dapat secara efektif mengurangi peretasan hadiah.

R-Zero: Penalaran Yang Berkembang Sendiri LLM dari Data Nol

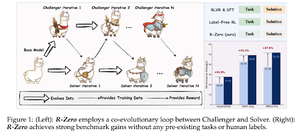

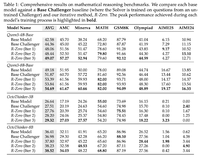

Dalam makalah ini, mereka mengusulkan R-Zero untuk melatih LLM penalaran yang dapat berevolusi sendiri dari 0 data eksternal. Model yang sama diinisialisasi dengan dua peran (Challenger/Solver) yang berevolusi bersama di RL.

Penantang dihargai karena menghasilkan tugas yang sulit bagi kemampuan Pemecah saat ini, sedangkan Pemecah dihargai karena menyelesaikan tugas-tugas yang semakin sulit yang diajukan oleh Penantang. R-Zero adalah kerangka kerja model-agnostik, dan mereka menunjukkan keuntungan pada model Qwen3-4b.

Mereka juga menyajikan CompassVerifier, keluarga model verifikasi yang kuat. Dilatih dengan data dari bangku asli, data yang ditingkatkan formula & data halusinasi. Model mereka berkinerja lebih baik daripada model lain seperti seri Qwen2.5 & 3 & juga membantu sebagai model hadiah.

Ikuti kami @ritualdigest untuk informasi lebih lanjut tentang semua hal tentang penelitian Crypto x AI, dan @ritualnet untuk mempelajari lebih lanjut tentang apa yang sedang dibangun Ritual.

4,69K

Teratas

Peringkat

Favorit