Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Aqui está o Digest do Ritual Research desta semana, um boletim informativo que cobre as últimas novidades no mundo dos LLMs e a interseção entre Crypto x AI.

Com centenas de artigos publicados semanalmente, é impossível manter-se atualizado com o que há de mais recente. Nós faremos a leitura para que você não precise.

Multi-Módulo GRPO: Composição de Gradientes de Política e Otimização de Prompt para Programas de Modelos de Linguagem

Este artigo explora se o pós-treinamento pode ser aplicado a estruturas de otimização de prompt.

Esta é a primeira implementação do GRPO em pipelines LLM complexos. O método MM-GRPO melhora o desempenho em 7% em média em comparação com o CoT padrão. Embora não supere sempre a otimização de prompts, é sempre um complemento eficaz.

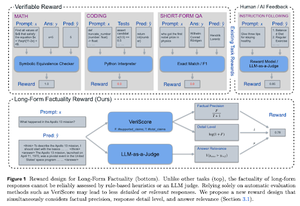

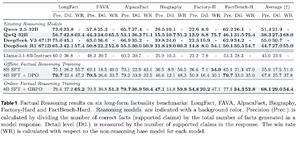

Aprender a Raciocinar para Factualidade

Este artigo desenvolve uma função de recompensa para treinar long CoT (Cadeia de Pensamento) para factualidade. O seu design impede a manipulação de recompensas ao favorecer a precisão, o detalhe e a qualidade ao mesmo tempo.

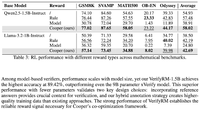

Eles descobrem que a sua função de recompensa em RL supera o modelo base (Llama-3.1-8B-Instruct) em todas as métricas em vários conjuntos de dados. Os LLMs de raciocínio existentes (QwQ, R1) sofrem de uma diminuição da factualidade em comparação com o seu modelo base (Qwen 2.5 32B, DS v3).

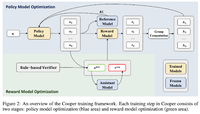

Cooper: Co-otimização de Modelos de Política e Recompensa em Aprendizagem por Reforço para Grandes Modelos de Linguagem

Neste artigo, eles propõem um método de RL, Cooper, que treina o modelo de política e o modelo de recompensa simultaneamente.

Eles lançam um conjunto de dados de modelagem de recompensas, que é rotulado usando uma estratégia que combina verificação baseada em regras e LLM como juiz. Eles descobrem que ajustar dinamicamente o modelo de recompensas durante o RL pode mitigar efetivamente a manipulação de recompensas.

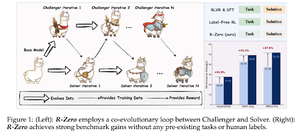

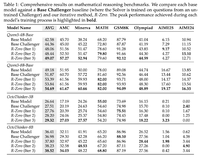

R-Zero: LLM de Raciocínio Autoevolutivo a Partir de Dados Zero

Neste artigo, propõem o R-Zero para treinar LLMs de raciocínio que podem autoevoluir a partir de 0 dados externos. O mesmo modelo é inicializado com dois papéis (Desafiante/Resolutor) que coevoluem em RL.

O Challenger é recompensado por gerar tarefas que são difíceis para as habilidades atuais do Solver, enquanto o Solver é recompensado por resolver essas tarefas cada vez mais difíceis impostas pelo Challenger. O R-Zero é uma estrutura independente de modelo, e eles mostram ganhos no modelo Qwen3-4b.

Eles também apresentam o CompassVerifier, uma família de modelos de verificação robustos. Treinado com dados da bancada original, dados aprimorados por fórmula ou dados de alucinação. Seu modelo tem um desempenho melhor do que outros modelos como Qwen2.5 & 3 series & é útil como um modelo de recompensa também.

Siga-nos @ritualdigest para mais informações sobre tudo relacionado à pesquisa em Crypto x AI, e @ritualnet para saber mais sobre o que a Ritual está construindo.

6,23K

Top

Classificação

Favoritos