Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Her er denne ukens Ritual Research Digest, et nyhetsbrev som dekker det siste i verden av LLM-er og skjæringspunktet mellom Crypto x AI.

Med hundrevis av artikler utgitt ukentlig, er det umulig å holde seg oppdatert med det siste. Vi leser slik at du ikke trenger å gjøre det.

GRPO med flere moduler: Komponering av policygradienter og rask optimalisering for språkmodellprogrammer

Denne artikkelen undersøker om ettertrening kan brukes til raske optimaliseringsrammeverk.

Dette er den første implementeringen av GRPO til komplekse LLM-rørledninger. Metoden MM-GRPO forbedrer ytelsen med 7 % i gjennomsnitt mot vanilje CoT. Selv om det ikke alltid overgår rask optimalisering, er det alltid et effektivt kompliment.

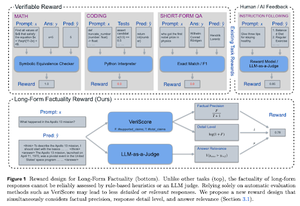

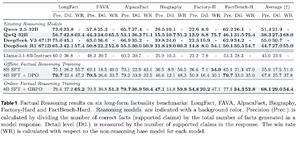

Å lære å resonnere for fakta

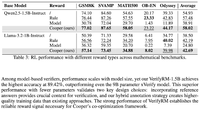

Denne artikkelen utvikler en belønningsfunksjon for å trene lang CoT (Chain of Thought) for fakta. Designet deres slutter å belønne hacking ved å favorisere presisjon, detaljer og kvalitet på samme tid.

De finner at belønningsfunksjonen deres i RL overgår basismodellen (Llama-3.1-8B-Instruct) i alle beregninger på tvers av flere datasett. Eksisterende resonnerende LLM-er (QwQ, R1) lider av faktareduksjon sammenlignet med basismodellen (Qwen 2.5 32B, DS v3).

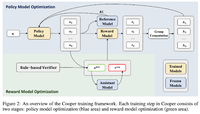

Cooper: Samoptimalisering av policy- og belønningsmodeller i forsterkende læring for store språkmodeller

I denne artikkelen foreslår de en RL-metode, Cooper, som trener policymodellen og belønningsmodellen samtidig.

De gir ut et datasett for belønningsmodellering, som er merket ved hjelp av en strategi som kombinerer regelbasert og LLM-som-en-dommer-verifisering. De finner ut at dynamisk justering av belønningsmodellen under RL effektivt kan redusere belønningshacking.

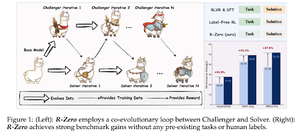

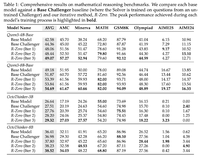

R-Zero: Selvutviklende resonnement LLM fra null data

I denne artikkelen foreslår de R-Zero for å trene resonnerende LLM-er som kan utvikle seg selv fra 0 eksterne data. Den samme modellen er initialisert med to roller (Challenger/Solver) som utvikler seg sammen i RL.

Utfordreren blir belønnet for å generere oppgaver som er vanskelige for Løserens nåværende evner, mens Løseren blir belønnet for å løse disse stadig vanskeligere oppgavene som Utfordreren stiller. R-Zero er et modellagnostisk rammeverk, og de viser gevinster på Qwen3-4b-modellen.

De presenterer også CompassVerifier, en familie av robuste verifiseringsmodeller. Trent med data fra den opprinnelige benken, formelforbedrede data og hallusinasjonsdata. Modellen deres yter bedre enn andre modeller som Qwen2.5 og 3-serien, og er også nyttig som belønningsmodell.

Følg oss @ritualdigest for mer om alt som har med Crypto x AI-forskning å gjøre, og @ritualnet for å lære mer om hva Ritual bygger.

3,76K

Topp

Rangering

Favoritter