Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeffrey Emanuel

El nuevo modelo de imagen de Gemini (también conocido como "nano banana") funciona bastante bien y es muy divertido de usar con sus hijos (hice una reina, la otra Blippi, a pedido de ellos).

Sin embargo, tiene algunas limitaciones bastante extrañas. A veces, obtiene la semejanza con mucha precisión. Otras veces, los rostros se ven totalmente irreconocibles. No parece haber mucho patrón que pueda discernir en términos de cuándo funciona y cuándo falla.

Google ya tiene una tecnología bastante buena para reconocer rostros, ya que lo hacen en Google Imágenes.

Me pregunto por qué no agregan un paso de control de calidad automático que verifica si la cara en la imagen generada es una buena coincidencia con la cara en la imagen original y vuelve a intentar automáticamente las que caen. La inconsistencia hace que el producto se sienta mucho menos mágico.

El mayor problema es que las revisiones de una imagen que ha salido mal literalmente nunca funcionan. Es totalmente incapaz de recuperarse una vez que va por un mal camino. Incluso si las revisiones son bastante claras y modestas. Casi se siente como un "envenenamiento del contexto" de algún tipo.

Este parece ser el problema mucho más serio de que esta sea una herramienta de productividad que compite con Photoshop. Pero también probablemente podría resolverse haciendo siempre varias generaciones detrás de escena y calificándolas y mostrando solo la mejor.

Tampoco te permiten regenerar ("volver a rodar") una imagen, por lo que tienes que iniciar una nueva conversación cada vez. Esto es molesto y contamina tu historial de conversaciones.

Pero con todo lo dicho, funciona bastante bien, y ciertamente mucho mejor que la funcionalidad similar en Facebook Messenger.

Adobe debe tener una respuesta a esto si quiere seguir siendo relevante.

7.4K

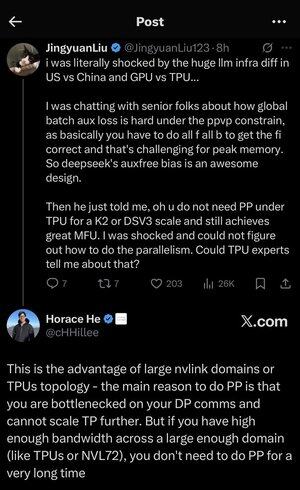

Me perdí un poco en todos los acrónimos y la jerga aquí, así que le pedí a Claude que lo explicara sin usar ningún acrónimo y ahora todo tiene mucho sentido (tldr; ancho de banda ⟹ simplicidad):

Esta es una discusión técnica fascinante sobre el entrenamiento de grandes modelos de lenguaje a escala.

La conversación central

Jingyuan Liu está expresando su sorpresa al descubrir que no necesita ciertas técnicas de optimización complejas cuando se usan TPU (Unidades de procesamiento tensorial, los chips de IA especializados de Google) frente a GPU (Unidades de procesamiento de gráficos, generalmente los chips de NVIDIA).

Explicación de conceptos técnicos clave:

Tipos de hardware:

•GPU (Unidad de procesamiento de gráficos): Originalmente diseñada para gráficos, ahora muy utilizada para IA. NVIDIA domina este mercado.

• TPU (Tensor Processing Unit): los chips diseñados a medida de Google específicamente para el aprendizaje automático.

Estrategias de paralelismo:

Al entrenar modelos masivos de IA, debe dividir el trabajo en muchos chips. Hay varias formas de hacer esto:

1) Paralelismo de datos (DP): cada chip procesa diferentes lotes de datos con la misma copia del modelo

2) Paralelismo tensorial (TP): Las operaciones matemáticas del modelo se dividen en chips

3) Paralelismo de tubería (PP): Diferentes capas del modelo se colocan en diferentes chips, creando una tubería

El desafío técnico que se está discutiendo:

El problema de la pérdida auxiliar: al entrenar modelos muy grandes, a menudo se agregan "pérdidas auxiliares" (objetivos de entrenamiento adicionales) en las capas intermedias para ayudar a que los gradientes fluyan mejor a través de la red. Bajo las restricciones PPVP (Paralelismo de canalización con partición de variables), esto se vuelve complejo porque:

•Necesitas hacer "todo f todo b" (todos los pases hacia adelante, luego todos los pases hacia atrás)

•Esto es un desafío para el uso máximo de memoria porque tiene que almacenar resultados intermedios

Innovación de DeepSeek: Desarrollaron un diseño de "sesgo sin aux" que aparentemente evita la necesidad de estas pérdidas auxiliares sin dejar de entrenar de manera efectiva.

La sorprendente revelación:

El experto senior le dijo a Jingyuan que con TPU a escala K2 o DSV3 (estas son configuraciones de clúster con cientos o miles de chips), puede lograr una excelente MFU (utilización de modelos FLOP, básicamente la eficiencia con la que está usando el hardware) SIN usar el paralelismo de tuberías.

¿Por qué es esto sorprendente?

•El paralelismo de canalización generalmente se considera esencial para la capacitación a gran escala

• Es una técnica compleja que requiere una optimización cuidadosa

• Poder evitarlo simplifica todo significativamente

La explicación de Horace He:

Explica POR QUÉ esto es posible con los TPU:

La ventaja del ancho de banda: los TPU y los clústeres NVIDIA de gama alta (como NVL72, la última configuración de 72 GPU de NVIDIA con interconexiones NVLink) tienen un ancho de banda tan alto entre chips que pueden manejar los requisitos de comunicación sin paralelismo de tuberías.

La idea clave:

•El paralelismo de canalización es necesario principalmente cuando tiene "cuellos de botella en las comunicaciones de DP" (limitado por la rapidez con la que puede comunicarse durante el entrenamiento paralelo de datos)

•Si tiene suficiente ancho de banda en un dominio lo suficientemente grande (clúster interconectado), puede utilizar estrategias de paralelismo más sencillas

•Esto funciona "durante mucho tiempo", lo que significa que puede entrenar incluso modelos muy grandes sin alcanzar los límites.

La intuición:

Piense en ello como un sistema de carreteras:

•Los clústeres de GPU tradicionales son como tener carreteras estrechas entre ciudades, por lo que necesita un enrutamiento complejo (paralelismo de canalización) para evitar atascos de tráfico

• Los clústeres de TPU o las GPU conectadas a NVLink son como tener superautopistas masivas: puede enviar todo directamente sin un enrutamiento sofisticado

Esto es un gran problema porque el paralelismo de canalización es complejo de implementar, depurar y optimizar. Ser capaz de evitarlo sin dejar de lograr una alta eficiencia hace que todo el proceso de entrenamiento sea mucho más simple y confiable.

La discusión destaca cómo los avances en la tecnología de interconexión de hardware (los "caminos" entre chips) pueden cambiar fundamentalmente las estrategias de software necesarias para un entrenamiento eficiente de IA.

25.74K

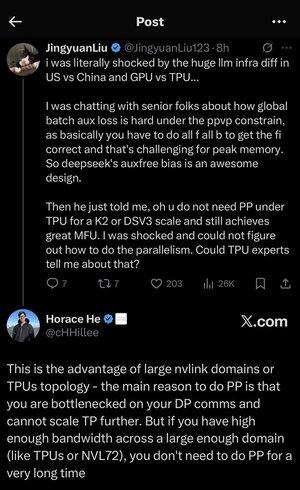

Me perdí un poco en todos los acrónimos y la jerga aquí, así que le pedí a Claude que lo explicara sin usar ningún acrónimo y ahora todo tiene mucho sentido (tldr; ancho de banda ⟹ simplicidad):

Esta es una discusión técnica fascinante sobre el entrenamiento de grandes modelos de lenguaje a escala.

La conversación central

Jingyuan Liu está expresando su sorpresa al descubrir que no necesita ciertas técnicas de optimización complejas cuando se usan TPU (Unidades de procesamiento tensorial, los chips de IA especializados de Google) frente a GPU (Unidades de procesamiento de gráficos, generalmente los chips de NVIDIA).

Explicación de conceptos técnicos clave:

Tipos de hardware:

•GPU (Unidad de procesamiento de gráficos): Originalmente diseñada para gráficos, ahora muy utilizada para IA. NVIDIA domina este mercado.

• TPU (Tensor Processing Unit): los chips diseñados a medida de Google específicamente para el aprendizaje automático.

Estrategias de paralelismo:

Al entrenar modelos masivos de IA, debe dividir el trabajo en muchos chips. Hay varias formas de hacer esto:

1Paralelismo de datos (DP): cada chip procesa diferentes lotes de datos con la misma copia del modelo

2Paralelismo tensorial (TP): Las operaciones matemáticas del modelo se dividen en chips

3Paralelismo de canalización (PP): Diferentes capas del modelo se colocan en diferentes chips, creando una canalización

El desafío técnico que se está discutiendo:

El problema de la pérdida auxiliar: al entrenar modelos muy grandes, a menudo se agregan "pérdidas auxiliares" (objetivos de entrenamiento adicionales) en las capas intermedias para ayudar a que los gradientes fluyan mejor a través de la red. Bajo las restricciones PPVP (Paralelismo de canalización con partición de variables), esto se vuelve complejo porque:

•Necesitas hacer "todo f todo b" (todos los pases hacia adelante, luego todos los pases hacia atrás)

•Esto es un desafío para el uso máximo de memoria porque tiene que almacenar resultados intermedios

Innovación de DeepSeek: Desarrollaron un diseño de "sesgo sin aux" que aparentemente evita la necesidad de estas pérdidas auxiliares sin dejar de entrenar de manera efectiva.

La sorprendente revelación:

El experto senior le dijo a Jingyuan que con TPU a escala K2 o DSV3 (estas son configuraciones de clúster con cientos o miles de chips), puede lograr una excelente MFU (utilización de modelos FLOP, básicamente la eficiencia con la que está usando el hardware) SIN usar el paralelismo de tuberías.

¿Por qué es esto sorprendente?

•El paralelismo de canalización generalmente se considera esencial para la capacitación a gran escala

• Es una técnica compleja que requiere una optimización cuidadosa

• Poder evitarlo simplifica todo significativamente

La explicación de Horace He:

Explica POR QUÉ esto es posible con los TPU:

La ventaja del ancho de banda: los TPU y los clústeres NVIDIA de gama alta (como NVL72, la última configuración de 72 GPU de NVIDIA con interconexiones NVLink) tienen un ancho de banda tan alto entre chips que pueden manejar los requisitos de comunicación sin paralelismo de tuberías.

La idea clave:

•El paralelismo de canalización es necesario principalmente cuando tiene "cuellos de botella en las comunicaciones de DP" (limitado por la rapidez con la que puede comunicarse durante el entrenamiento paralelo de datos)

•Si tiene suficiente ancho de banda en un dominio lo suficientemente grande (clúster interconectado), puede utilizar estrategias de paralelismo más sencillas

•Esto funciona "durante mucho tiempo", lo que significa que puede entrenar incluso modelos muy grandes sin alcanzar los límites.

La intuición:

Piense en ello como un sistema de carreteras:

•Los clústeres de GPU tradicionales son como tener carreteras estrechas entre ciudades, por lo que necesita un enrutamiento complejo (paralelismo de canalización) para evitar atascos de tráfico

• Los clústeres de TPU o las GPU conectadas a NVLink son como tener superautopistas masivas: puede enviar todo directamente sin un enrutamiento sofisticado

Esto es un gran problema porque el paralelismo de canalización es complejo de implementar, depurar y optimizar. Ser capaz de evitarlo sin dejar de lograr una alta eficiencia hace que todo el proceso de entrenamiento sea mucho más simple y confiable.

La discusión destaca cómo los avances en la tecnología de interconexión de hardware (los "caminos" entre chips) pueden cambiar fundamentalmente las estrategias de software necesarias para un entrenamiento eficiente de IA.

4.01K

Estoy un poco sorprendido de que nadie haya creado aún un servidor MCP de Dwarf Fortress que pueda permitir a un agente como Codex o Claude Code controlar eficientemente el juego y monitorear el estado y el progreso.

Realmente nunca lo jugué yo mismo, solo lo descargué y lo revisé brevemente hace unos 10 años, pero disfruté leyendo sobre él.

Parece que sería una muy buena prueba de un LLM para ver cuánto tiempo podría mantener a los enanos vivos y prósperos.

Debido a que cada juego eventualmente resulta en una catástrofe en cascada que hace que todos los enanos mueran, debería haber un punto de parada natural, lo que lo convierte en un buen candidato de referencia. Al menos eso es lo que entiendo (el lema de los jugadores es "Perder es divertido").

Hacer un buen trabajo con estos juegos dependería de la precisión de las llamadas de herramientas y la coherencia sostenida de las tareas largas, además de la capacidad de monitorear y comprender la dinámica de un sistema complejo y realizar intervenciones oportunas que anticipen y contrarresten los problemas.

Y debido a que es nativo de la terminal, podría transmitirse y procesarse de manera eficiente utilizando tokens regulares sin necesidad de procesamiento de imágenes multimodal, lo que lo haría mucho más eficiente que otros juegos.

Además, sabe que ningún laboratorio de IA se ha entrenado para esto (¡todavía!), Por lo que no está contaminado por "benchmaxxing".

4.42K

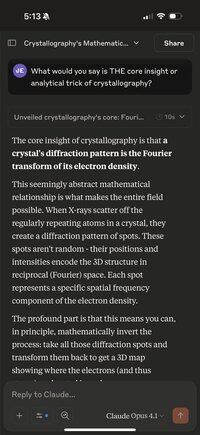

Una cosa divertida que puedes hacer cuando necesitas esperar unos minutos es usar tu teléfono para hacerle a Claude Opus la siguiente pregunta sobre alguna disciplina o campo aleatorio:

"¿Cuál dirías que es LA idea central o el truco analítico de la cristalografía?"

Reemplaza la cristalografía con cualquier cosa que se te ocurra. Hasta ahora, he intentado:

QED; el Modelo Estándar; Bioquímica; Probabilidad; Teoría evolutiva; y muchos más.

Hay algo en forzar al modelo a hacer lo imposible, a condensar un campo vasto y complejo en "un truco extraño", que lo hace realmente buscar el mejor principio unificador profundo en el campo y luego articularlo sucintamente.

Esto tiende a ser algo obvio para los profesionales, pero es muy probable que sea desconocido para la mayoría de las personas con un interés pasajero en el tema.

Curiosamente, también puede presionar repetidamente el botón "reintentar" con el mismo mensaje y, a veces, obtener explicaciones muy diferentes, pero generalmente muy fascinantes.

Ya he aprendido MUCHO al hacer esto, y podría ser la mayor "comprensión por minuto" que he encontrado en cualquier aprendizaje autodirigido.

Porque no son solo datos divertidos o cositas interesantes. Son, por construcción, ideas penetrantes y unificadoras que unen una gran cantidad de teoría y fenómenos observados en el mundo.

¡Ciertamente es mucho más ancho de banda que ver otro video explicativo de YouTube con animaciones y anuncios de Brilliant / KiwiCo! No es que haya nada malo en eso.

8.32K

La idea de que ha habido tal "éxodo de talento" de OpenAI recientemente que ya no están posicionados para ser un líder en el espacio es tan equivocada y errónea como la idea de que GPT-5 "fue un gran fracaso y el modelo no es tan bueno y es muy incremental".

GPT-5 Pro no solo es el modelo más inteligente del mundo ahora en gran medida en las tareas más desafiantes del mundo real (especialmente las tareas de codificación, que tienen la mayor importancia económica ahora), sino que la nueva herramienta codex cli de OpenAI está increíblemente bien ejecutada.

Pasaron de un distante tercer lugar en la codificación de herramientas cli a tener lo que podría decirse que es el mejor ahora (tenga en cuenta que todavía me gusta y uso Claude Code, ¡no es uno u otro!), con el mejor rendimiento, la latencia más baja, etc. porque está programado en Rust.

Y ahora esta herramienta cli se combina con el mejor modelo de codificación que tiene la mejor confiabilidad de llamada de herramientas y la mejor coherencia de tareas largas, con la menor cantidad de alucinaciones.

Y no hace falta decir que su aplicación iOS también es dramáticamente mejor que todas las demás aplicaciones de IA en términos de pulido y características. ¡La aplicación Claude es solo la aplicación web en una caja de arena de Safari! Y su aplicación web también sigue siendo la mejor. Cosas como la búsqueda funcionan mejor que en otras aplicaciones. Bloqueo y tacleada básicos.

Entonces, sí. Algunas personas muy inteligentes como Ilya y John Schulman se fueron a otras empresas. Pero todavía tienen un equipo técnico absolutamente increíble con personas de producto increíblemente buenas y habilidades de ingeniería increíbles.

No dejes que tu disgusto por Altman te ciegue a lo obvio. Cada vez que veo a otra persona hablar de lo malo que es GPT-5, me estremezco, porque la persona está demostrando que no puede pensar por sí misma basándose en la evidencia y la razón, y se memeó para que pensara una opinión (y la soltara en línea) porque cree que la hace parecer inteligente.

34.28K

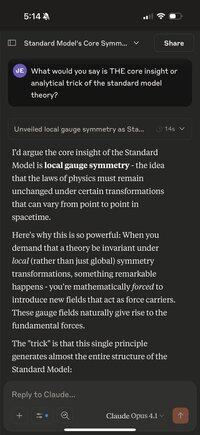

¿Qué tan genial es que cada uno de esos pequeños chips tenga 8 terabytes de almacenamiento súper rápido? Y puede conectarlos a ambos en esa carcasa azul y obtener 20 Gbps a través de USB 3.3 (no tengo puertos USB 4 y todas mis ranuras pci-e están ocupadas por GPU)

Vivimos en una época de tanta abundancia.

3.51K

Como actualización de mis dos hilos recientes sobre el uso de GPT-5 Pro para iniciar un proceso de descubrimiento de teorías innovadoras que combinan aplicaciones novedosas de matemáticas avanzadas en los casos de uso de IA, hice que el modelo creara implementaciones de demostración en Python usando Jax y Numpy para cada una de las 11 ideas.

Luego los junté en un proyecto y agregué una buena CLI para ejecutarlos, y una serie de pruebas de extremo a extremo que midieron si el código es matemáticamente correcto, verifican que el código tenga las propiedades matemáticas que queremos y, finalmente, si hace algo útil en comparación con los enfoques estándar actuales.

Usé codex CLI con GPT-5 para integrar todo y corregir errores. Enlazaré al repositorio, que contiene documentación detallada para todo el proyecto y luego reseñas para cada una de las 11 demostraciones que contienen toda la salida generada por el modelo durante el proceso.

4.08K

Populares

Ranking

Favoritas