Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

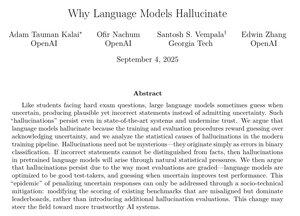

Este artigo da OpenAI tem algumas explicações muito convincentes sobre por que as alucinações persistem e o que fazer a respeito.

Especificamente no pós-treinamento, devemos parar de penalizar os modelos por dizerem que não sabem a resposta e parar de recompensar palpites excessivamente confiantes.

Erradicar as alucinações seria uma das maiores melhorias em IA para casos de uso corporativo, como direito, finanças, saúde e muitos outros campos de alto valor.

Isso seria um grande feito se conseguirmos continuar fazendo progressos significativos nesta área.

49,55K

Top

Classificação

Favoritos