Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

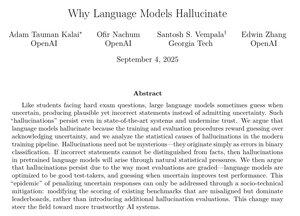

Ten artykuł OpenAI zawiera bardzo przekonujące wyjaśnienia dotyczące tego, dlaczego halucynacje się utrzymują i co można z tym zrobić.

Szczególnie w fazie po szkoleniu powinniśmy przestać karać modele za to, że mówią, iż nie znają odpowiedzi, oraz przestać nagradzać zbyt pewne zgadywanie.

Wyeliminowanie halucynacji byłoby jednym z największych ulepszeń AI w zastosowaniach korporacyjnych, takich jak prawo, finanse, opieka zdrowotna i wiele innych dziedzin o wysokiej wartości.

To byłoby bardzo ważne, jeśli uda nam się nadal osiągać znaczące postępy w tej dziedzinie.

49,55K

Najlepsze

Ranking

Ulubione