Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

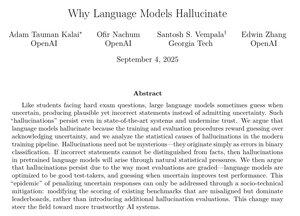

Este artículo de OpenAI tiene algunas explicaciones muy convincentes sobre por qué persisten las alucinaciones y qué hacer al respecto.

Específicamente en el entrenamiento posterior, deberíamos dejar de penalizar a los modelos por decir que no saben una respuesta y dejar de recompensar las conjeturas demasiado confiadas.

Erradicar las alucinaciones sería una de las mayores mejoras de IA para casos de uso corporativo como derecho, finanzas, atención médica y muchos otros campos de alto valor.

Esto sería muy importante si podemos seguir haciendo progresos significativos en este ámbito.

49.55K

Populares

Ranking

Favoritas