Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

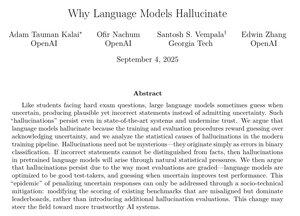

Ce document d'OpenAI contient des explications très convaincantes sur les raisons pour lesquelles les hallucinations persistent et ce qu'il faut faire à ce sujet.

Plus précisément, après l'entraînement, nous devrions cesser de pénaliser les modèles pour avoir déclaré qu'ils ne connaissent pas la réponse, et arrêter de récompenser les devinettes trop confiantes.

Éliminer les hallucinations serait l'une des plus grandes améliorations de l'IA pour des cas d'utilisation en entreprise tels que le droit, la finance, la santé et de nombreux autres domaines à forte valeur ajoutée.

Ce serait un événement très important si nous pouvons continuer à faire des progrès significatifs dans ce domaine.

49,55K

Meilleurs

Classement

Favoris