Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Momenteel zijn #AI en #RWA de belangrijkste onderzoeksgebieden van ons team, we bekijken dagelijks tientallen whitepapers of businessplannen. Eerlijk gezegd zijn er te veel projecten die "de hype volgen". Wat "#AI+#Web3" betreft, klinkt het geweldig, maar als je vraagt naar de praktische logica, is het negen van de tien keer niet echt. Maar toen ik de whitepaper van #OpenLedger las, voelde ik een schok: dit project heeft echt inhoud, het is geen PPT-financiering, maar het pakt de pijnpunten van de #AI-industrie aan en gaat er serieus mee aan de slag.

De ontwikkeling van #AI heeft nu een paar duidelijke pijnpunten:

1️⃣ Bijdragers verdienen geen geld

Gegevensleveranciers, modelontwikkelaars, annotators, en zelfs gebruikers die feedback geven op modellen, werken in feite voor grote bedrijven. Ze dragen hard bij, maar uiteindelijk is het het platform dat de winst opstrijkt, waardoor het ecosysteem niet kan groeien.

2️⃣ Modellen zijn een black box

Hoe worden de #AI-modellen die we gebruiken eigenlijk getraind? Welke gegevens zijn gebruikt? Waarom komt dit resultaat eruit? Niemand kan het duidelijk uitleggen. Dit is een groot probleem in sectoren zoals de gezondheidszorg en financiën - als je niet transparant bent, durven anderen het niet te gebruiken.

3️⃣ Algemene modellen zijn niet allesomvattend

Grote modellen zoals GPT-4 zijn natuurlijk indrukwekkend, maar als het gaat om specifieke gebieden (zoals kankerdiagnose of financiële risicoanalyse), schieten ze tekort. De toekomstige trend zal zeker zijn dat er kleinere, gespecialiseerde modellen komen, maar daarvoor zijn nauwkeurige gegevens en een prikkelsysteem nodig.

🎯 In de whitepaper van #OpenLedger wordt een bijzonder directe technische oplossing gepresenteerd: gebruik maken van de transparantie en prikkels van blockchain om de gegevensprikkels, waarde-toewijzing en betrouwbaarheid van #AI op te lossen.

De belangrijkste punten van #OpenLedger vind ik bijzonder indrukwekkend:

✅ Bewijs van toewijzing (Proof of Attribution)

Dit is als een "boekhoudsysteem" voor #AI. Wie gegevens heeft bijgedragen, wie het model heeft getraind, wie de rekenkracht heeft geleverd, kan allemaal worden vastgelegd. Belangrijker is dat wanneer het model wordt gebruikt om waarde te genereren, de opbrengsten automatisch naar deze bijdragers worden verdeeld op basis van hun bijdrage.

Nu is het goed, iedereen is geen "vrijwilliger voor het platform" meer, maar "partners"; hoe groter de bijdrage, hoe meer je verdient. Dit mechanisme lost direct de problemen van gegevensgebrek en onvoldoende prikkels op.

✅ Ingebouwd economisch systeem voor #AI

Vroeger was de internet-economie afhankelijk van advertenties en SEO, maar het tijdperk van #AI is anders. #OpenLedger biedt een complete "AI-economische basislaag": elke keer dat een model wordt aangeroepen, elke keer dat er een inferentie plaatsvindt, moet er betaald worden, en dit geld wordt transparant verdeeld. Dit is een duurzame vraag- en aanbodmarkt voor #AI, en geen simpele subsidie of luchtige transacties.

✅ Focus op gespecialiseerde modellen

Het gaat er niet om in een directe strijd met GPT te gaan, maar om een goede toolchain (Datanets, ModelFactory, OpenLoRA) op te zetten, zodat ontwikkelaars gemakkelijker modellen voor specifieke gebieden kunnen trainen. In sectoren zoals gezondheidszorg, financiën en cyberbeveiliging zijn gespecialiseerde modellen gemakkelijker te implementeren en hebben ze meer commerciële waarde.

Waarom heb ik vertrouwen in #OpenLedger?

1️⃣ Oplossing voor echte pijnpunten

Wat #AI nu het meest nodig heeft, is niet rekenkracht, maar prikkels en vertrouwen. Het "bewijs van toewijzing" van #OpenLedger raakt de kern; zodra het draait, ontstaat er een vliegwieleffect: meer mensen dragen gegevens bij → modellen worden beter → meer gebruikers gebruiken het → meer opbrengsten vloeien terug naar de bijdragers.

2️⃣ Volledige tech-stack

Het is geen loze belofte; de whitepaper bevat een duidelijke architectuur: EVM-compatibele keten, bewijs van toewijzing, toolkit. Wat ik zie is geen luchtfietserij, maar een systeem dat kan draaien en al operationeel is.

3️⃣ Redelijk token-economie ontwerp

De token $OPEN van #OpenLedger is niet alleen een "transactietoken", maar het "bloed" van het hele ecosysteem:

• Gebruikt om model-inferentiekosten en trainingskosten te betalen

• Gebruikt om gegevens- en modelbijdragen te stimuleren

• Gebruikt voor protocolbeheer

• Gebruikt voor Gas

De token is nauw verbonden met gebruiksscenario's; hoe meer mensen het gebruiken, hoe groter de vraag naar de token. Dit is een van de gezondste tokenomics die ik heb gezien.

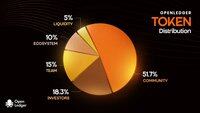

Daarnaast heb ik ook naar de tokenverdeling gekeken:

• Totale hoeveelheid 1 miljard

• Gemeenschap + ecosysteem in totaal 61,7% (5% voor airdrops, wat erg genereus is), een zeer hoog percentage, wat aangeeft dat het projectteam echt een ecosysteem wil opbouwen en niet alleen geld wil ophalen en vertrekken.

• Investeerders en team hebben een lock-up periode van 12 maanden + 36 maanden lineaire vrijgave, dit ontwerp is ook redelijk en kan een vroege dump voorkomen.

• TGE circulatie 21,55%, zowel liquiditeit als startbeloningen zijn gewaarborgd.

Dus al met al lijkt de TGE van #OpenLedger redelijk stabiel, het beschermt zowel de ontwikkeling van het ecosysteem als voorkomt kortetermijnbubbels.

Als ChatGPT ons de potentie van AI heeft laten zien, dan is een project als #OpenLedger bezig met het leggen van de fundamenten voor de #AI-economie. Het laat gegevens en waarde terugkeren naar de bijdragers en bevordert de ontwikkeling van gespecialiseerde modellen; als deze stap eenmaal is gezet, zal het in de toekomst een onmisbare infrastructuur in het #AI-gebied zijn, wat het waard is om nauwlettend in de gaten te houden.

4 sep, 04:08

Bitcoin heeft geld opnieuw gedefinieerd.

Ethereum heeft financiën opnieuw gedefinieerd.

OpenLedger herdefinieert de AI-economie.

Onze whitepaper legt de basis voor een verifieerbare en eerlijke toekomst van AI. Gebaseerd op het onderzoek naar data-attributie van Stanford, toont het aan dat elke bit data ertoe doet en elke bijdrager wordt erkend.

Geen zwarte-doosmodellen meer.

Open. Vertrouwd. Traceerbaar.

Lees verder:

47,62K

Boven

Positie

Favorieten