Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Interessant over AI, wiskundeonderzoek, academische erkenning en menselijke vooruitgang

21 aug, 07:25

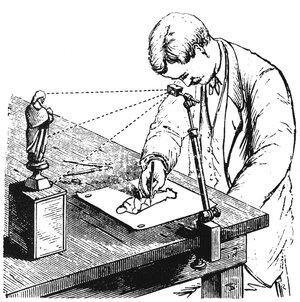

Een "camera lucida" is een apparaat dat een prisma gebruikt, vastgehouden door een metalen armatuur, om een afbeelding van de scène ervoor op een stuk papier eronder te projecteren, een beetje zoals een moderne projector die is aangesloten op een live camerastream.

Deze zijn waarschijnlijk uitgevonden in het begin van de 1400s, hoewel gepubliceerde verslagen ervan pas in de late 1500s verschijnen. Een deel van de reden daarvoor is waarschijnlijk dat ze nauwkeurig bewaarde handelsgeheimen waren van kunstenaars die ze gebruikten om een graad van nauwkeurigheid te bereiken die eerder onmogelijk of in ieder geval extreem moeilijk te bereiken was zonder hulp van een "vrije hand".

De kunstenaar David Hockney raakte jaren geleden zeer geïnteresseerd in dit onderwerp en schreef er in 2001 een boek over. Zijn basis theorie was dat de opmerkelijke verbetering in nauwkeurigheid en realisme rechtstreeks te wijten was aan het geheime gebruik van de camera lucida (en ook een eerder apparaat genaamd camera obscura).

Zoals hij opmerkte, zou je voor die periode nooit een schilderij van een luit in perspectief zien dat niet vervormd en verkeerd leek. Hoewel je de "regels van perspectief" kon gebruiken om eenvoudige rechthoekige vormen realistisch te tekenen, was de meer complexe geometrie van een luit voorbij de normale menselijke capaciteit om realistisch in de ruimte weer te geven. Deze theorie staat bekend als de Hockney-Falco-these.

Sinds ik hier in de vroege jaren 2000 op de universiteit over leerde, heb ik mentaal een asterisk aangebracht bij de werken van bepaalde schilders. Bijvoorbeeld, hoezeer ik Ingres en Caravaggio ook respecteer en bewonder, de ontzag die ik voor hun vaardigheden had, werd getemperd door de realisatie dat ze waarschijnlijk gebruik maakten van dit soort mechanische hulp.

En zeker, veel van de kunstzinnigheid zit in het concept, de compositie en framing, de kleuren, de penseelstreken, enz. Maar dat adembenemende levensechte realisme is wat me het meest indrukte, en dat deel ervan werd tenminste gedeeltelijk verwoest door deze onthulling. Het maakte me ook nog meer respect hebben voor het sculpturale realisme van Michelangelo (en ook zijn studies die duidelijk schetsen zijn gemaakt vanuit het leven).

In ieder geval, de reden dat ik dit nu ter sprake breng, is dat ik geloof dat we op de rand staan van hetzelfde soort dingen die gebeuren in wiskundig onderzoek met de opkomst van modellen zoals GPT-5 Pro.

Ik heb het al gebruikt om te doen wat ik vermoed dat echt nieuw en interessant onderzoek is (zoals ik in recente discussies heb gedetailleerd), en we hebben vandaag een update gekregen van Sebastien Bubeck bij OpenAI die laat zien dat het model in staat was om een interessant resultaat in de hedendaagse wiskunde te bewijzen met een nieuwe bewijsvoering, in één keer nog wel.

Dus dit nieuwe tijdperk is plotseling op ons neergedaald. We zagen vorige week een resultaat van Chinese computerwetenschappers die een record voor optimale sortering verbraken dat 45 jaar standhield.

Ik dacht op dat moment na over hoe ik me afvroeg of AI op de een of andere manier was gebruikt om dat resultaat te genereren.

Zie ook het recente artikel in de geciteerde tweet, dat een vergelijkbaar karakter heeft in die zin dat het zowel verrassend als ook elementair is. Deze lijken mij de kenmerken te zijn van resultaten die op de een of andere manier van AI hebben geprofiteerd.

Nu wil ik deze auteurs niet van iets beschuldigen. Voor zover ik weet, hebben ze alles handmatig gedaan, net zoals de schilders in de 1300s deden.

En zelfs als ze AI hebben gebruikt om hen te helpen, hebben we nog geen geaccepteerde normen over hoe daarmee om te gaan: welke onthullingen gerechtvaardigd zijn, en hoe de eer moet worden verdeeld en overwogen. Het hele concept van auteurschap moet vandaag de dag opnieuw worden overwogen.

In mijn recente discussie waarin ik samen met GPT-5 Pro het gebruik van Lie-theorie in deep learning onderzocht, heb ik de prompts zelf bedacht, hoewel ik nooit in een miljoen jaar in staat zou zijn om de theorie en code te genereren die het model ontwikkelde als resultaat van die prompts. Krijg ik de eer voor het resultaat als het blijkt de sector te revolutioneren?

Wat betreft mijn daaropvolgende experiment, waarbij ik mijn originele prompts die ik zelf schreef gebruikte samen met een "meta-prompt" om GPT-5 Pro te laten komen met 10 meer paren van prompts die losjes waren gemodelleerd naar mijn eigen, maar die totaal verschillende takken van wiskunde omvatten die zich in totaal verschillende richtingen ontwikkelden.

Krijg ik eer voor die theorieën als ze belangrijk blijken te zijn? Ik hoop van wel, want ik heb de ideeën en code al gepubliceerd op GitHub en ze breed gepromoot, dus als iemand die lijnen van onderzoek volgt, zou de academische ethiek vereisen dat ze mij citeren.

Maar zelfs als je denkt dat ik eer verdien voor het sturen van de AI met mijn eigen prompt, dan zijn mijn claims op prioriteit zeker enigszins verzwakt voor de 10 andere theorieën die het resultaat zijn van het gebruik van mijn prompt als model voor meta-prompting, toch? Tenslotte wist ik niet eens dat "Tropische Geometrie" een ding was een paar dagen geleden, en nu heb ik een theorie en code die het toepast op AI-onderzoek.

Ik zou willen stellen dat, net zoals ik mentaal een asterisk begon aan te brengen bij bepaalde kunstwerken en kunstenaars, vergelijkbaar met de asterisk naast de naam van Barry Bonds in de Hall of Fame, ik vermoed dat de meeste wetenschappers hetzelfde zullen gaan doen voor nieuwe wiskundige theorie-gebaseerde artikelen in het komende jaar of zo.

Ik vermoed dat mensen binnenkort dingen zullen zeggen als "deze man is de echte deal; hij schreef zijn beste artikelen vóór 2025!" om te onderscheiden tussen degenen die al hun werk handmatig met hun eigen hersenen deden versus degenen die AI-assistentie gebruikten.

En dat is absoluut een geldige manier om over dingen na te denken als AI in staat is om niet alleen moeilijke theoretische problemen op te lossen, maar zelfs interessante vragen op zijn eigen te stellen.

Als ik gelijk heb, moeten we ons voorbereiden op een komende tsunami van schokkende onderzoeksartikelen die lang bestaande records en limieten overtreffen, en door muren breken die lange tijd als relatief ondoordringbaar werden beschouwd, behalve door een doorbraaktheorie.

En ik geloof dat veel van deze resultaten iets gemeen zullen hebben: dat ze altijd recht voor ons stonden, maar het vereiste het combineren van theorie uit verschillende gebieden van wiskunde en toegepaste onderwerpen op nieuwe manieren die eerder niet werden nagestreefd vanwege menselijke, sociologische redenen: verschillende velden die zich splitsen over lijnen, met verschillende terminologie, tijdschriften, praktijken, afdelingen, conferenties, sociale netwerken, enz.

De andere vorm die ik vermoed dat deze resultaten zullen aannemen, is het benutten van elementaire resultaten op bizarre manieren die, om welke reden dan ook, niet natuurlijk komen voor menselijke hersenen, maar die we kunnen begrijpen zodra ze duidelijk voor ons worden uitgelegd.

Een andere vorm die ze kunnen aannemen, zijn resultaten die gebruik maken van lang vergeten esoterica uit de late 19e eeuwse analyse. De soorten trucs die Feynman in staat stelden om integralen op te lossen die niemand anders kon oplossen.

Deze resultaten zijn bekend en bestaan in boeken, maar niemand leest die boeken meer, en de oorspronkelijke theorieën waarvoor ze zijn ontwikkeld, zijn grotendeels vervangen door onze moderne machines die op veel niveaus van verhoogde abstractie en generaliteit werken.

Een andere vorm die ze kunnen aannemen, is simpelweg het toepassen van bekende wiskunde die door slechts een paar honderd gespecialiseerde genieën in de wereld wordt begrepen, die zich alleen op theorie richten en helemaal niet op toepassingen.

Deze wiskunde kan gewoon "rondhangen" sinds de jaren 1950 of 1970, wachtend op iemand die het kan toepassen op een praktisch probleem zoals die in AI-onderzoek. Veel van de ideeën die ik met GPT-5 heb onderzocht, lijken in deze categorie te vallen.

13,2K

Boven

Positie

Favorieten