熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

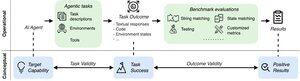

作為接近現實世界的 AI 代理,我們如何知道它們實際上可以做什麼?可靠的基準至關重要,但代理基準被打破了!

範例:WebArena 將持續時間計算任務上的「45+8 分鐘」標記為正確(真實答案:「63 分鐘」。其他基準將代理能力誤估了 1.6-100%。

為什麼代理系統的評估基礎很脆弱?請參閱下面的線程和鏈接

1/8

代理評估在任務制定和結果方面與傳統的 ML 基準不同。

代理基準測試通常依賴於脆弱的模擬器(玩具網站、資料庫),可能存在可能扭曲結果的錯誤和捷徑。此外,代理基準的任務結果沒有固定的「黃金」標籤,通常需要判斷非結構化答案(程式碼、API 呼叫、長文字)。

3/8

為了應對這些挑戰,代理基準測試應旨在確保積極的評估結果與目標人工智慧代理的能力之間的相關性。我們將此目標分解為兩個基本有效性標準:

1. 任務有效性:當且僅當智能體具備目標能力時,任務是可以解決的。

2. 結果效度:當且僅當任務得到解決時,評估結果是正面的。

4/8

基於 17 個流行的基準(例如 SWE-bench、OSWorld、TAU-bench 等),我們開發了一份包含 43 項的代理基準清單 (ABC),以快速確定代理基準在多大程度上滿足任務和結果有效性

美國廣播公司:

5/8

我們將 ABC 應用於 10 個有影響力的基準測試,這些基準測試用於評估 o3、Gemini 2.5 和 Sonnet 4。以下是我們調查結果的概述:

1. 7/10 基準測試結果有效性不合格

2. 7/10包含隱藏的捷徑/無法解決的任務

3. 只有 2/10 披露已知問題

敬請關注。我們將很快針對已發現的問題發布更多定量細節和修復!

6/8

ABC 使基準測試和模型開發人員能夠在標題結果之前檢測和修復缺陷。

探索完整的清單、範例,並透過我們的網站和 GitHub 儲存庫做出貢獻,共同建立值得前沿 AI 的基準測試。

7/8

這是與來自史丹佛大學、柏克萊大學、耶魯大學、普林斯頓大學、麻省理工學院、Transluce、ML Commons、亞馬遜和英國 AISI 的 @maxYuxuanZhu、@yadapruksachatk 和其他人的共同工作。

8/8

21.95K

熱門

排行

收藏