Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Como agentes de IA quase no mundo real, como sabemos o que eles podem realmente fazer? Benchmarks confiáveis são críticos, mas benchmarks agenticos são quebrados!

Exemplo: WebArena marca "45+8 minutos" em uma tarefa de cálculo de duração como correta (resposta real: "63 minutos"). Outros benchmarks estimam erroneamente a competência do agente em 1,6-100%.

Porque é que as bases de avaliação para sistemas agenticos são frágeis? Veja abaixo o tópico e os links

1/8

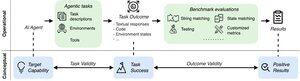

As avaliações agentic diferem das referências tradicionais de ML em termos de formulação de tarefas e resultados.

Os benchmarks agenticos geralmente dependem de simuladores frágeis (sites de brinquedos, bancos de dados) potencialmente com bugs e atalhos que podem distorcer os resultados. Além disso, os resultados de tarefas de benchmarks agenticos não têm rótulos fixos de "ouro" e muitas vezes precisam julgar respostas não estruturadas (código, chamadas de API, textos longos).

3/8

Para enfrentar esses desafios, os benchmarks agenticos devem ter como objetivo garantir a correlação entre um resultado positivo da avaliação e a capacidade dos agentes de IA alvo. Decompomos esta meta em dois critérios essenciais de validade:

1. Validade da tarefa: Uma tarefa é solucionável se e somente se o agente possuir a capacidade de destino.

2. Validade do Resultado: O resultado da avaliação é positivo se e somente se a tarefa for resolvida.

4/8

Com base em 17 benchmarks populares (por exemplo, SWE-bench, OSWorld, TAU-bench, etc.), desenvolvemos uma lista de verificação de benchmark agentic (ABC) de 43 itens para identificar rapidamente até que ponto um benchmark agentic satisfaz a validade da tarefa e do resultado

ABC:

5/8

Aplicamos o ABC a 10 benchmarks impactantes que foram usados para avaliar o3, Gemini 2.5 e Sonnet 4. Aqui está uma visão geral de nossas descobertas:

1. 7/10 índices de referência falham na validade dos resultados

2. 7/10 contêm atalhos ocultos/tarefas insolúveis

3. Apenas 2/10 divulgam problemas conhecidos

Fique atento. Em breve divulgaremos mais detalhes quantitativos e correções para os problemas identificados!

6/8

O ABC permite que ambos os desenvolvedores de modelos de benchmark ou de referência detetem falhas e corrijam falhas antes dos resultados de manchete.

Explore a lista de verificação completa, exemplos e contribua através do nosso site e do repositório GitHub para construir benchmarks dignos de IA de fronteira juntos.

7/8

Este é um trabalho conjunto com @maxYuxuanZhu, @yadapruksachatk e outras pessoas de Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon e UK AISI.

8/8

22,03K

Top

Classificação

Favoritos