Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hur vet vi vad AI-agenter faktiskt kan göra när de används i den verkliga världen? Tillförlitliga riktmärken är avgörande, men agentiska riktmärken är trasiga!

Exempel: WebArena markerar "45+8 minuter" på en varaktighetsberäkningsuppgift som korrekt (riktigt svar: "63 minuter"). Andra riktmärken missbedömer agenternas kompetens med 1,6-100 %.

Varför är utvärderingsgrunderna för agentiska system bräckliga? Se nedan för tråd och länkar

1/8

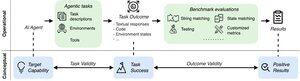

Agentiska utvärderingar skiljer sig från traditionella ML-riktmärken när det gäller uppgiftsformulering och resultat.

Agentic benchmarks förlitar sig ofta på ömtåliga simulatorer (leksakswebbplatser, databaser) potentiellt med buggar och genvägar som kan snedvrida resultaten. Dessutom har uppgiftsresultat av agentiska riktmärken inga fasta "guld"-etiketter och behöver ofta bedöma ostrukturerade svar (kod, API-anrop, långa texter.)

3/8

För att ta itu med dessa utmaningar bör agentiska riktmärken syfta till att säkerställa korrelationen mellan ett positivt utvärderingsresultat och mål-AI-agenternas förmåga. Vi delar upp detta mål i två viktiga giltighetskriterier:

1. Uppgiftens giltighet: En uppgift kan lösas om och endast om agenten har målkapaciteten.

2. Resultatvaliditet: Utvärderingsresultatet är positivt om och endast om uppgiften löses.

4/8

Baserat på 17 populära benchmarks (t.ex. SWE-bench, OSWorld, TAU-bench, etc.) utvecklar vi en checklista med 43 punkter för agentic benchmark (ABC) för att snabbt identifiera i vilken utsträckning en agentic benchmark uppfyller giltigheten för uppgifter och resultat

ABC:

5/8

Vi tillämpade ABC på 10 effektfulla benchmarks som användes för att utvärdera o3, Gemini 2.5 och Sonnet 4. Här är en översikt över våra resultat:

1. 7/10 benchmarks misslyckas med utfallet validitet

2. 7/10 innehåller dolda genvägar/olösliga uppgifter

3. Endast 2/10 avslöjar kända problem

Håll ögonen öppna. Vi kommer snart att släppa mer kvantitativ information och korrigeringar för de identifierade problemen!

6/8

ABC gör det möjligt för både benchmark- och modellutvecklare att upptäcka och åtgärda brister – innan de ger resultat.

Utforska hela checklistan, exemplen och bidra via vår webbplats och GitHub-lagringsplats för att tillsammans bygga riktmärken som är värdiga AI i framkant.

7/8

Detta är ett gemensamt arbete med @maxYuxuanZhu, @yadapruksachatk och andra personer från Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon och UK AISI.

8/8

22,03K

Topp

Rankning

Favoriter