Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Pe măsură ce agenții AI sunt aproape de utilizarea în lumea reală, de unde știm ce pot face de fapt? Benchmark-urile fiabile sunt critice, dar benchmark-urile agentice sunt rupte!

Exemplu: WebArena marchează "45+8 minute" pe o sarcină de calcul a duratei ca fiind corect (răspuns real: "63 minute"). Alți indici de referință estimează greșit competența agentului cu 1,6-100%.

De ce sunt fragile bazele de evaluare pentru sistemele agentice? Vezi mai jos subiectul și link-urile

1/8

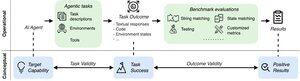

Evaluările agentice diferă de benchmark-urile tradiționale ML în ceea ce privește formularea sarcinilor și rezultatul.

Benchmark-urile agentice se bazează adesea pe simulatoare fragile (site-uri web de jucării, baze de date) potențial cu erori și comenzi rapide care pot distorsiona rezultatele. Mai mult, rezultatele sarcinilor de referință agentice nu au etichete fixe de "aur" și adesea trebuie să judece răspunsuri nestructurate (cod, apeluri API, texte lungi).

3/8

Pentru a aborda aceste provocări, criteriile de referință agențice ar trebui să vizeze asigurarea corelației dintre un rezultat pozitiv al evaluării și capacitatea agenților de IA țintă. Descompunem această țintă în două criterii esențiale de validitate:

1. Validitatea sarcinii: O sarcină poate fi rezolvată dacă și numai dacă agentul posedă capacitatea țintă.

2. Validitatea rezultatului: Rezultatul evaluării este pozitiv dacă și numai dacă sarcina este rezolvată.

4/8

Bazându-ne pe 17 benchmark-uri populare (de exemplu, SWE-bench, OSWorld, TAU-bench etc.), dezvoltăm o listă de verificare a benchmark-ului agentic (ABC) cu 43 de itemi pentru a identifica rapid în ce măsură un benchmark agentic satisface validitatea sarcinii și a rezultatului

ABC:

5/8

Am aplicat ABC la 10 benchmark-uri de impact care au fost utilizate pentru a evalua o3, Gemini 2.5 și Sonnet 4. Iată o prezentare generală a constatărilor noastre:

1. 7/10 criterii de referință nu respectă validitatea rezultatelor

2. 7/10 conține comenzi rapide ascunse/sarcini de nerezolvat

3. Doar 2/10 dezvăluie probleme cunoscute

Rămâneți pe fază. Vom publica în curând mai multe detalii cantitative și remedieri pentru problemele identificate!

6/8

ABC permite atât dezvoltatorilor de benchmark-uri, cât și modelelor să detecteze și să remedieze defectele – înainte de rezultatele principale.

Explorați lista de verificare completă, exemple și contribuiți prin intermediul site-ului nostru web și al depozitului GitHub pentru a construi împreună benchmark-uri demne de IA de frontieră.

7/8

Aceasta este o lucrare comună cu @maxYuxuanZhu, @yadapruksachatk și alți oameni de la Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon și UK AISI.

8/8

22,03K

Limită superioară

Clasament

Favorite