Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

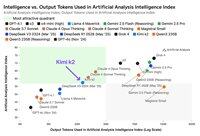

Vaikka Moonshot AI:n Kimi k2 on johtava avoimen painon ei-päättelymalli Artificial Analysis Intelligence Indexissä, se tuottaa ~3 kertaa enemmän tokeneita kuin muut ei-päättelymallit, mikä hämärtää päättelyn ja ei-päättelyn välisiä rajoja

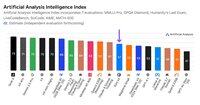

Kimi k2 on tähän mennessä suurin suuri avopainomalli - 1T kokonaisparametrit 32B aktiivisella (tämä vaatii massiivisen 1 Tt muistia alkuperäisessä FP8:ssa painojen pitämiseen). Meillä on k2 57:ssä Artificial Analysis Intelligence Indexissä, mikä on vaikuttava pistemäärä, joka asettaa sen GPT-4.1:n ja DeepSeek V3:n kaltaisten mallien yläpuolelle, mutta johtavien päättelymallien taakse.

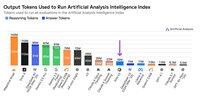

Tähän asti päättelymallien ja ei-päättelymallien välillä on ollut selkeä ero evaleissamme - ei vain sen mukaan, käyttääkö malli <reasoning> tunnisteita, vaan ensisijaisesti tokenien käytön perusteella. Artificial Analysis Intelligence Indexin kaikkiin evaleihin vastaamiseen käytettyjen tokenien mediaanimäärä on ~10 kertaa suurempi päättelymalleissa kuin ei-päättelymalleissa.

@Kimi_Moonshot:n Kimi k2 käyttää ~3x enemmän tokeneita kuin mediaani ei-päättelymalli käyttää. Sen tokenien käyttö on vain jopa 30 % pienempi kuin Claude 4 Sonnetin ja Opuksen käyttö, kun niitä käytetään niiden maksimibudjetin laajennetussa ajattelutilassa, ja se on lähes kolminkertainen sekä Claude 4 Sonnetin että Opuksen tokenien käyttöön verrattuna, kun päättely on pois päältä.

Siksi suosittelemme, että Kimi k2:ta verrataan Claude 4 Sonetiin ja Opukseen niiden maksimibudjetin laajennetussa ajattelutilassa, ei Claude 4 -mallien ei-päättelypisteisiin.

Kimi k2 on saatavilla @Kimi_Moonshot:n ensimmäisen osapuolen API:ssa sekä @FireworksAI_HQ, @togethercompute, @novita_labs ja @parasail_io.

Katso alta ja keinotekoisesta analyysistä lisäanalyysi 👇

60,67K

Johtavat

Rankkaus

Suosikit