Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

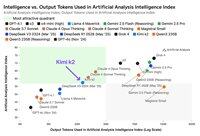

Embora o Kimi k2 da Moonshot AI seja o principal modelo de não-raciocínio de pesos abertos no Índice de Inteligência de Análise Artificial, ele produz ~3x mais tokens do que outros modelos sem raciocínio, borrando as linhas entre raciocínio e não raciocínio

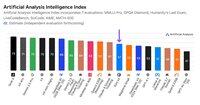

Kimi k2 é o maior modelo de pesos abertos até agora - 1T parâmetros totais com 32B ativos (isso requer um enorme 1TB de memória no FP8 nativo para manter os pesos). Temos k2 em 57 no Artificial Analysis Intelligence Index, uma pontuação impressionante que o coloca acima de modelos como GPT-4.1 e DeepSeek V3, mas atrás de modelos de raciocínio líderes.

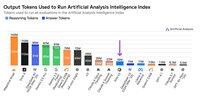

Até agora, havia uma distinção clara entre modelo de raciocínio e modelos sem raciocínio em nossos evals - definidos não apenas pelo <reasoning> uso de tags pelo modelo, mas principalmente pelo uso de tokens. O número mediano de tokens usados para responder a todos os evals no Índice de Inteligência de Análise Artificial é ~10x maior para modelos de raciocínio do que para modelos sem raciocínio.

O Kimi k2 da @Kimi_Moonshot usa ~3x o número de tokens que o modelo mediano sem raciocínio usa. Seu uso de token é apenas até 30% menor do que Claude 4 Sonnet e Opus quando executado em seu modo de pensamento estendido de orçamento máximo, e é quase o triplo do uso de token de Claude 4 Sonnet e Opus com o raciocínio desligado.

Portanto, recomendamos que Kimi k2 seja comparado com Claude 4 Sonnet e Opus em seus modos de pensamento estendido de orçamento máximo, não com as pontuações sem raciocínio para os modelos Claude 4.

O Kimi k2 está disponível na API de primeira parte da @Kimi_Moonshot, bem como @FireworksAI_HQ, @togethercompute, @novita_labs e @parasail_io.

Veja abaixo e em Análise Artificial para uma análise 👇 mais aprofundada

60,68K

Top

Classificação

Favoritos