Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Att fråga i JSON- eller XML-format ökar LLM-utdata med 10 gånger

Varför

eftersom strukturerade format ger modellen tydliga gränser och förväntningar

när du ber om ostrukturerad text måste LLM gissa:

Hur lång tid ska detta ta?

vilka sektioner behöver jag?

när är jag klar?

Vilken detaljnivå?

men med JSON/XML tillhandahåller du bokstavligen en mall:

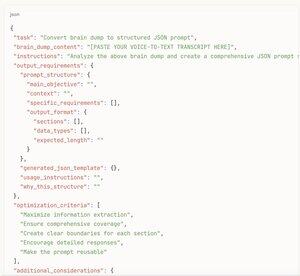

json{

"summary": "",

"key_points": [],

"analysis": "",

"rekommendationer": []

}

Nu vet modellen exakt vad som ska fyllas i och ungefär hur mycket innehåll varje avsnitt behöver

Det är som skillnaden mellan "Skriv något om bilar" vs "fyll i det här bilrecensionsformuläret med dessa 12 specifika fält"

Strukturen tar bort beslutsförlamning och ger modellen tillåtelse att vara heltäckande

plus att JSON/XML naturligtvis uppmuntrar modellen att tänka i organiserade bitar snarare än att bara strömma text tills den känns "klar"

[Här är meta hacka]

Försök inte ens att skriva strukturerade uppmaningar från grunden

istället:

1. Röst-till-text-hjärnan dumpar allt du vill ha analyserat/undersökt/skrivit om

2. klistra in den röriga utskriften till AI:n

3. be den att "skapa en JSON-promptstruktur baserad på denna hjärndump som skulle få bästa möjliga utdata"

4. Ta den genererade JSON-mallen

5. Skicka tillbaka den som din faktiska uppmaning

Du får alla fördelar med strukturerade uppmaningar utan att behöva tänka igenom strukturen själv

AI:n vet vilka fält som skulle vara mest användbara bättre än du gör ändå

förvandlar din medvetandeström till en uppmaning av professionell kvalitet på 30 sekunder

Prova själv - be om samma analys i styckeform vs strukturerat format

Den strukturerade versionen kommer att vara 3-5 gånger längre och mycket mer detaljerad varje gång

17,27K

Topp

Rankning

Favoriter