トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

JSON または XML 形式でプロンプトを表示すると、LLM 出力が 10 倍に増加します

なぜでしょうか

構造化された形式は、モデルに明確な境界と期待を与えるためです

非構造化テキストを要求すると、LLM は以下を推測する必要があります。

これはどのくらいの長さにする必要がありますか?

どのセクションが必要ですか?

いつ終わるの?

どの程度の詳細レベル?

しかし、JSON / XMLでは、文字通りテンプレートを提供しています。

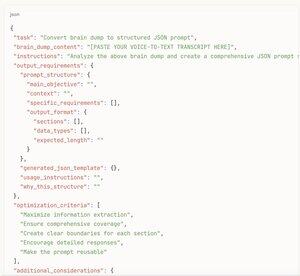

json{

"概要": ""、

"key_points": []、

"分析": ""、

"推奨事項": []

}

これで、モデルは何を埋めるか、各セクションに必要なコンテンツの量を正確に認識しています

これは、「車について何か書く」と「この車のレビュー フォームにこれら 12 の特定のフィールドを記入する」の違いのようなものです。

この構造は、意思決定の麻痺を取り除き、モデルに包括的な権限を与えます

さらに、JSON / XMLは、モデルが「完了」と感じるまでテキストをストリーミングするのではなく、整理されたチャンクで考えることを自然に奨励します

[メタハックはこちら]

構造化されたプロンプトを最初から書こうとさえしないでください

その代わりに:

1. 音声からテキストへのブレインダンプは、分析/調査/書きたいものをすべてダンプします

2. その乱雑なトランスクリプトを AI に貼り付ける

3. 「このブレインダンプに基づいて、可能な限り最高の出力を得る JSON プロンプト構造を作成する」ように依頼します。

4. 生成された JSON テンプレートを取得する

5. 実際のプロンプトとして送り返す

構造化プロンプトのすべての利点を、自分で考えなくても得られます

とにかく、AI はどの分野があなたよりも役立つかを知っています

30秒で意識の流れをプロ仕様のプロンプトに変えます

自分で試してみてください - 段落形式と構造化形式で同じ分析を求める

構造化バージョンは、毎回3〜5倍長く、はるかに詳細になります

17.26K

トップ

ランキング

お気に入り