Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

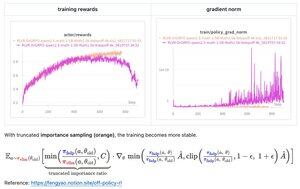

Met slechts een paar regels code heeft Feng's (@fengyao1909) voorgestelde oplossing—het toepassen van importance sampling op het gedrag beleid—de trainingsinstabiliteit in mijn geval (oat) opgelost. Ik geloof dat het resultaat ook kan generaliseren naar andere RL-frameworks. Geweldig werk, Feng!

39,24K

Boven

Positie

Favorieten