Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

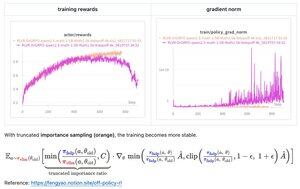

Con solo unas pocas líneas de código, la solución sugerida por Feng (@fengyao1909)—aplicando muestreo de importancia en la política de comportamiento—resolvió la inestabilidad del entrenamiento en mi caso (oat). Creo que el resultado puede generalizarse a otros marcos de RL también. ¡Gran trabajo, Feng!

39,24K

Parte superior

Clasificación

Favoritos