Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

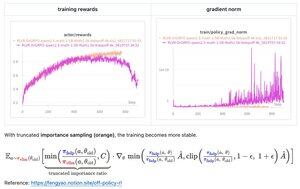

Avec juste quelques lignes de code, la solution suggérée par Feng (@fengyao1909) — appliquer un échantillonnage d'importance sur la politique de comportement — a résolu l'instabilité de l'entraînement dans mon cas (oat). Je crois que le résultat peut se généraliser à d'autres frameworks RL également. Excellent travail, Feng !

39,24K

Meilleurs

Classement

Favoris