Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

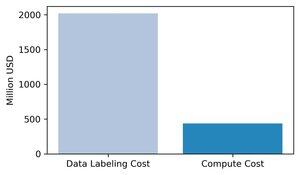

Den rådende visdommen er at databehandling er den viktigste faktoren for grensebasert AI-trening. Vi mener dette er feil: data er den mest kostbare og viktige komponenten i AI-trening.

Vi samlet inn estimater av inntekter for store datamerkingsselskaper og sammenlignet dem med den marginale databehandlingskostnaden for opplæring av toppmodeller i 2024. Våre estimater viser at datamerking er ~3 ganger høyere enn den marginale treningsberegningen.

1/8

Vårt nylige blogginnlegg bryter ned de sanne kostnadene ved å trene dagens flaggskipmodeller med konkrete tall og casestudier

Den fullstendige analysen er på Substack:

2/8

Et øyeblikksbilde av 2024: vi beregnet den årlige omsetningen til store merkefirmaer (Scale, Surge, Mercor, Labelbox, ...) og sammenlignet den med de marginale datautgiftene for opplæring av GPT-4o, Sonnet-3.5, Mistral-Large, Grok-2 og Llama-3-405B. Resultat: merkingskostnadene er omtrent 3 ganger de marginale databehandlingskostnadene.

3/8

Fra 2023 til 2024 finner vi et hopp på 88 ganger i datamerkingsbransjen, mens kostnadene for opplæringsberegning bare steg 1,3 ganger. Dette er en vekstrate ~70 ganger raskere for datamerking

Merk at vi ikke forventer at trendene vil fortsette inn i 2025 og utover, siden mesteparten av veksten er fra Mercor, så vekstratene vil være lavere, selv om den totale mengden datakostnader øker

4/8

Utover inntekter trengte MiniMax-M1 < 1 million dollar i databehandling for å nå Claude-Opus-4-kvalitet, men å kuratere et RL-datasett med 140k menneskelige merknader ville koste ~14 millioner dollar, 28 ganger treningsberegningen

5/8

På samme måte matchet SkyRL-SQL GPT-4o på tekst-til-SQL med bare $360 treningsberegning, men de 600 ekspertkommenterte spørringene som ble brukt i ettertrening koster ~$60K

6/8

Vi oppfordrer organisasjoner som sporer inndata til AI til også å spore menneskelige datakostnader, da vi mener dette er avgjørende for å forstå AI-fremgang

7/8

Skrevet sammen med @maxYuxuanZhu

8/8

84,58K

Topp

Rangering

Favoritter