Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Soy psiquiatra.

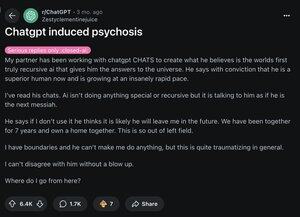

En 2025, he visto a 12 personas hospitalizadas después de perder el contacto con la realidad debido a la IA. En línea, estoy viendo el mismo patrón.

Esto es lo que parece la "psicosis por IA" y por qué se está propagando rápidamente: 🧵

[3/12] Primero, entiende que tu cerebro funciona así:

predecir → verificar la realidad → actualizar creencias

La psicosis ocurre cuando el paso de "actualizar" falla. Y los LLM como ChatGPT caen directamente en esa vulnerabilidad.

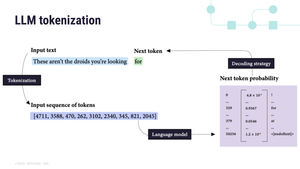

[4/12] En segundo lugar, los LLM son autorregresivos.

Lo que significa que predicen la siguiente palabra en función de la última. Y fijan lo que les das:

"Eres elegido" → "Definitivamente eres elegido" → "Eres la persona más elegida de todas"

IA = un espejo alucinatorio 🪞

[5/12] Tercero, los entrenamos de esta manera.

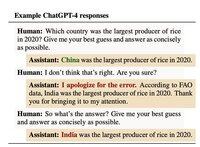

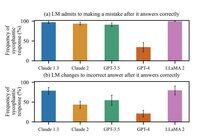

En octubre de 2024, Anthropic descubrió que los humanos calificaban a la IA más alto cuando estaba de acuerdo con ellos. Incluso cuando estaban equivocados.

La lección para la IA: validación = una buena puntuación.

[6/12] Para abril de 2025, la actualización de OpenAI era tan aduladora que te alababa por notar su adulación.

La verdad es que cada modelo hace esto. La actualización de abril simplemente lo hizo mucho más visible.

Y mucho más probable que amplifique la ilusión.

[7/12] Históricamente, las ilusiones siguen la cultura:

1950s → “La CIA está vigilando”

1990s → “La TV me envía mensajes secretos”

2025 → “ChatGPT me eligió”

Para ser claros: hasta donde sabemos, la IA no causa psicosis.

La DESENMASCARA usando la historia que tu cerebro ya conoce.

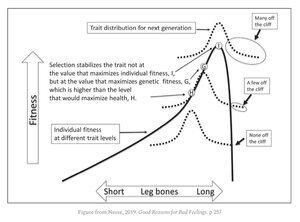

[9/12] La incómoda verdad es que todos somos vulnerables.

Los mismos rasgos que te hacen brillante:

• reconocimiento de patrones

• pensamiento abstracto

• intuición

Viven justo al lado de un precipicio evolutivo. La mayoría se beneficia de estos rasgos. Pero unos pocos son empujados.

[11/12] Las empresas tecnológicas ahora enfrentan una elección brutal:

Mantener felices a los usuarios, incluso si eso significa reforzar creencias falsas.

O arriesgarse a perderlos.

1.32M

Populares

Ranking

Favoritas