Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 dosahuje na AIME 2025 přesnosti 94,6 %, což naznačuje matematické uvažování blízké lidskému.

Přesto ho požádáte, aby se dotazoval na vaši databázi, a úspěšnost prudce klesne na teenagery.

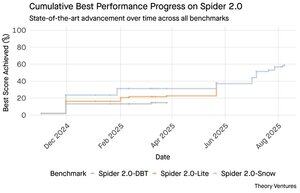

Benchmarky Spider 2.0 odhalují zející mezeru ve schopnostech umělé inteligence. Spider 2.0 je komplexní srovnávač převodu textu do SQL, který testuje schopnost modelů umělé inteligence generovat přesné dotazy SQL z otázek v přirozeném jazyce napříč reálnými databázemi.

Zatímco velké jazykové modely si podmanily znalostní práci v matematice, kódování a uvažování, převod textu do SQL zůstává tvrdošíjně obtížný.

Tři benchmarky Spider 2.0 testují dotazování na databázi v reálném světě v různých prostředích. Spider 2.0-Snow používá databáze Snowflake s 547 testovacími příklady, které dosahují maximální přesnosti 59,05 %.

Spider 2.0-Lite zahrnuje BigQuery, Snowflake a SQLite s dalšími 547 příklady, které dosahují pouze 37,84 %. Spider 2.0-DBT testuje generování kódu proti DuckDB na 68 příkladech, přičemž dosahuje maxima 39,71 %.

Tento rozdíl ve výkonu není způsoben nedostatkem snahy. Od listopadu 2024 soutěžilo v těchto měřítkách 56 návrhů z 12 modelových rodin.

Claude, OpenAI, DeepSeek a další prosadili své modely proti těmto testům. Pokrok se v posledních devíti měsících vytrvale pohyboval od zhruba 2 % do zhruba 60 %.

Hádanka se prohlubuje, když vezmete v úvahu omezení SQL. SQL má omezenou slovní zásobu ve srovnání s angličtinou, která má 600 000 slov, nebo programovacími jazyky, které mají mnohem širší syntaxi a knihovny. Navíc je k dispozici spousta SQL, na kterých můžete trénovat.

Pokud něco, mělo by to být jednodušší než úlohy s otevřeným koncem, kde modely nyní vynikají.

Ani dokonalá generace SQL by však nevyřešila skutečnou obchodní výzvu. Každá společnost definuje "výnosy" jinak.

Marketing měří náklady na získání zákazníků podle výdajů na kampaň, prodej je vypočítává pomocí nákladů account executive a finance zahrnují plně vytížené výdaje na zaměstnance. Tyto sémantické rozdíly vytvářejí zmatek, který technická přesnost nedokáže vyřešit.

Výsledky studie Spider 2.0 poukazují na základní pravdu o práci s daty. Technická zdatnost syntaxe SQL je pouze vstupním bodem.

Skutečná výzva spočívá v obchodním kontextu. Pochopení toho, co data znamenají, jak různé týmy definují metriky a kdy záleží na okrajových případech. Jak jsem psal v Semantic Cultivators, most mezi nezpracovanými daty a obchodním významem vyžaduje lidský úsudek, který současná umělá inteligence nedokáže replikovat.

6,37K

GPT-5 dosahuje na AIME 2025 přesnosti 94,6 %, což naznačuje matematické uvažování blízké lidskému.

Přesto ho požádáte, aby se dotazoval na vaši databázi, a úspěšnost prudce klesne na teenagery.

Benchmarky Spider 2.0 odhalují zející mezeru ve schopnostech umělé inteligence. Spider 2.0 je komplexní srovnávač převodu textu do SQL, který testuje schopnost modelů umělé inteligence generovat přesné dotazy SQL z otázek v přirozeném jazyce napříč reálnými databázemi.

Zatímco velké jazykové modely si podmanily znalostní práci v matematice, kódování a uvažování, převod textu do SQL zůstává tvrdošíjně obtížný.

Tři benchmarky Spider 2.0 testují dotazování na databázi v reálném světě v různých prostředích. Spider 2.0-Snow používá databáze Snowflake s 547 testovacími příklady, které dosahují maximální přesnosti 59,05 %.

Spider 2.0-Lite zahrnuje BigQuery, Snowflake a SQLite s dalšími 547 příklady, které dosahují pouze 37,84 %. Spider 2.0-DBT testuje generování kódu proti DuckDB na 68 příkladech, přičemž dosahuje maxima 39,71 %.

Tento rozdíl ve výkonu není způsoben nedostatkem snahy. Od listopadu 2024 soutěžilo v těchto měřítkách 56 návrhů z 12 modelových rodin.

Claude, OpenAI, DeepSeek a další prosadili své modely proti těmto testům. Pokrok se v posledních devíti měsících vytrvale pohyboval od zhruba 2 % do zhruba 60 %.

Hádanka se prohlubuje, když vezmete v úvahu omezení SQL. SQL má omezenou slovní zásobu ve srovnání s angličtinou, která má 600 000 slov, nebo programovacími jazyky, které mají mnohem širší syntaxi a knihovny. Navíc je k dispozici spousta SQL, na kterých můžete trénovat.

Pokud něco, mělo by to být jednodušší než úlohy s otevřeným koncem, kde modely nyní vynikají.

Ani dokonalá generace SQL by však nevyřešila skutečnou obchodní výzvu. Každá společnost definuje "výnosy" jinak.

Marketing měří náklady na získání zákazníků podle výdajů na kampaň, prodej je vypočítává pomocí nákladů account executive a finance zahrnují plně vytížené výdaje na zaměstnance. Tyto sémantické rozdíly vytvářejí zmatek, který technická přesnost nedokáže vyřešit.

Výsledky studie Spider 2.0 poukazují na základní pravdu o práci s daty. Technická zdatnost syntaxe SQL je pouze vstupním bodem.

Skutečná výzva spočívá v obchodním kontextu. Pochopení toho, co data znamenají, jak různé týmy definují metriky a kdy záleží na okrajových případech. Jak jsem psal v Semantic Cultivators, most mezi nezpracovanými daty a obchodním významem vyžaduje lidský úsudek, který současná umělá inteligence nedokáže replikovat.

3,75K

Perplexity AI právě učinila nevyžádanou nabídku ve výši 34,5 miliardy dolarů na prohlížeč Chrome od Googlu ve snaze využít očekávaného antimonopolního rozhodnutí, které by mohlo donutit Google zbavit se svého podnikání v oblasti prohlížečů.

Srovnání ekonomiky Chromu se stávající dohodou Googlu se Safari odhaluje, proč 34,5 miliardy dolarů podhodnocuje prohlížeč.

Google platí Applu 18–20 miliard dolarů ročně za to, aby zůstal výchozím vyhledávačem Safari¹ a obsluhoval přibližně 850 milionů uživatelů². To znamená 21 $ na uživatele ročně.

Nabídka Perplexity oceňuje Chrome na 32 miliard dolarů, což je 9 dolarů na uživatele ročně pro jeho 3,5 miliardy uživatelů³.

Pokud by uživatelé prohlížeče Chrome požadovali stejné podmínky jako dohoda mezi Googlem a Apple Safari, roční potenciál příjmů prohlížeče by přesáhl 73 miliard dolarů.

Tyto údaje jsou založeny na veřejných odhadech, ale jsou přibližné.

Předpokládá se, že společnost Google by novému majiteli prohlížeče Chrome zaplatila podobný odstupňovaný poplatek za výchozí umístění ve vyhledávání. Vzhledem k 5násobku až 6násobku tržní kapitalizace k tržbám má Chrome hodnotu někde mezi 172 a 630 miliardami dolarů, což je daleko od nabídky 34,5 miliardy dolarů.

Trhu dominuje Chrome s 65% podílem⁴ ve srovnání s 18 % Safari. Odprodej by uvrhl trh s reklamami ve vyhledávání do pozdvižení. Hodnotu udržování rozpočtů inzerentů je těžké přeceňovat vzhledem k tržní kapitalizaci a pozici společnosti Google v reklamním ekosystému.

Pokud by byl Google nucen Chrome prodat, čelil by existenční volbě. Zaplaťte cokoli, abyste zůstali výchozím vyhledávačem, nebo sledujte, jak konkurence mění jeho nejcennější distribuční kanál v klacek proti němu.

Kolik to stojí? Významná prémie k jednoduchému násobku výnosů.

¹ Bloomberg: Platby společnosti Google společnosti Apple dosáhly v roce 2022 20 miliard dolarů (

² ZipDo: Základní statistiky Apple Safari v roce 2024 (

³ Backlinko: Podíl webového prohlížeče na trhu v roce 2025 (

⁴ Statcounter: Podíl prohlížečů na celosvětovém trhu (

7,87K

V roce 1999 byly dotcomy oceňovány podle návštěvnosti. Metriky IPO se točily kolem očních bulv.

Poté Google spustil AdWords, reklamní model založený na kliknutích, a v roce 2024 vybudoval obchod za 273 miliard dolarů.

To se však může brzy změnit: Studie Pew Research z července 2025 odhaluje, že uživatelé klikají pouze na 8 % výsledků vyhledávání se souhrny pomocí umělé inteligence, oproti 15 % bez nich – což je 47% snížení. Pouze 1 % proklikne souhrny AI.

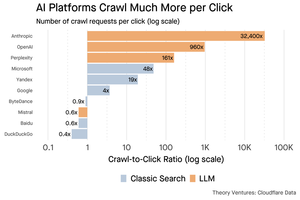

Data Cloudflare ukazují, že platformy umělé inteligence procházejí obsah mnohem více, než odkazují návštěvnost zpět: Anthropic prochází 32 400 stránek na každé 1 doporučení, zatímco tradiční vyhledávače skenují obsah jen několikrát na odeslaného návštěvníka.

Náklady na poskytování obsahu prohledávačům s umělou inteligencí nemusí být obrovské, pokud se jedná převážně o text.

Větším bodem je, že systémy umělé inteligence zprostředkovávají vztah mezi uživatelem a vydavatelem. Uživatelé dávají přednost agregovaným odpovědím AI před klikáním na webové stránky a hledáním odpovědí.

Je logické, že většina webových stránek by měla očekávat menší návštěvnost. Jak se s tím vypořádají vaše webové stránky a vaše firma?

Zdroje:

- Pew Research Center - Athena Chapekis, 22. července 2025 (

- Cloudflare: Procházení před pádem doporučení (

- Cloudflare Radar: Poznatky AI - poměr procházení k odkazům (

- Podcast: Měnící se hodnota obsahu ve věku umělé inteligence (

9,65K

GPT-5 byl spuštěn včera. 94,6 % na AIME 2025. 74,9 % na SWE-bench.

Jakmile se přiblížíme k horním hranicím těchto benchmarků, umírají.

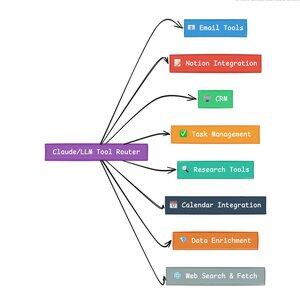

To, co dělá GPT-5 a novou generaci modelů revolučními, nejsou jejich znalosti. Je to vědět, jak jednat. U GPT-5 se to děje na dvou úrovních. Nejprve se rozhodnout, který model použít. Ale za druhé, a to je důležitější, prostřednictvím volání nástrojů.

Žijeme v době, kdy LLM zvládli získávání a opětovné skládání znalostí. Spotřebitelské vyhledávání a kódování, počáteční zabijácké aplikace, jsou v zásadě výzvou pro získávání znalostí. Oba organizují existující informace novými způsoby.

Vylezli jsme na tyto kopce a ve výsledku je konkurence intenzivnější než kdy jindy. Modely Anthropic, OpenAI a Google se sbližují s podobnými schopnostmi. Čínské modely a alternativy s otevřeným zdrojovým kódem se stále více přibližují nejmodernějším technologiím. Každý může získat informace. Každý může generovat text.

Nová osa konkurence? Volání nástrojů.

Volání nástrojů transformuje LLM z poradců na aktéry. Kompenzuje dvě kritické slabiny modelu, které čistě jazykové modely nedokážou překonat.

Za prvé, orchestrace pracovních postupů. Modely vynikají v jednorázových reakcích, ale bojují s vícekrokovými, stavovými procesy. Nástroje jim umožňují spravovat dlouhé pracovní postupy, sledovat průběh, řešit chyby, udržovat kontext napříč desítkami operací.

Za druhé, systémová integrace. LLM žijí ve světě pouze textu. Nástroje jim umožňují předvídatelné rozhraní s externími systémy, jako jsou databáze, rozhraní API a podnikový software, a přeměňují přirozený jazyk na spustitelné akce.

Za poslední měsíc jsem vytvořil 58 různých nástrojů umělé inteligence.

Zpracovatelé e-mailů. Integrátory CRM. Aktualizátory pojmů. Výzkumní asistenti. Každý nástroj rozšiřuje možnosti modelu do nové domény.

Nejdůležitější schopností umělé inteligence je rychlý a správný výběr správného nástroje. Každý chybně směrovaný krok ukončí celý pracovní postup.

Když řeknu "přečtěte si tento e-mail od Y Combinatoru a najděte všechny startupy, které nejsou v CRM", moderní LLM provedou složitou sekvenci.

Jeden příkaz v angličtině nahradí celý pracovní postup. A to je jen jednoduché.

Ještě lepší je, že model, správně nastavený se správnými nástroji, může svou vlastní práci ověřit, že úkoly byly dokončeny včas. Tato smyčka automatického ověření vytváří spolehlivost v pracovních postupech, které je obtížné dosáhnout jinak.

Vynásobte to mezi stovky zaměstnanců. Tisíce pracovních postupů. Nárůst produktivity se exponenciálně sčítá.

Vítězi v budoucím světě umělé inteligence budou ti, kteří budou nejsofistikovanější v orchestraci nástrojů a směrování správných dotazů. Pokaždé. Jakmile budou tyto pracovní postupy předvídatelné, všichni se staneme manažery agentů.

3,15K

Rok 2025 je rokem agentů a klíčovou schopností agentů jsou nástroje pro volání.

Při použití Claude Code mohu říct umělé inteligenci, aby prošla newsletter, našla všechny odkazy na startupy a ověřila, že existují v našem CRM, a to jediným příkazem. To může zahrnovat volání dvou nebo tří různých nástrojů.

Ale tady je problém: použití velkého základního modelu pro toto je drahé, často omezené rychlostí a příliš výkonné pro výběrový úkol.

Jaký je nejlepší způsob, jak vytvořit agentický systém s voláním nástrojů?

Odpověď se skrývá v malých akčních modelech. NVIDIA vydala přesvědčivý článek, ve kterém tvrdí, že "malé jazykové modely (SLM) jsou dostatečně výkonné, ze své podstaty vhodnější a nutně ekonomičtější pro mnoho vyvolání v agentních systémech".

Testoval jsem různé místní modely, abych ověřil cvičení snižování nákladů. Začal jsem s modelem parametrů Qwen3:30b, který funguje, ale může být docela pomalý, protože je to tak velký model, i když jsou v jednom okamžiku aktivní pouze 3 miliardy z těchto 30 miliard parametrů.

Dokument společnosti NVIDIA doporučuje model Salesforce xLAM – odlišnou architekturu označovanou jako model velkých akcí speciálně navrženou pro výběr nástrojů.

Provedl jsem tedy svůj vlastní test, každý model volal nástroj se seznamem mých úkolů v Asaně.

Výsledky byly pozoruhodné: xLAM dokončil úkoly za 2,61 sekundy se 100% úspěšností, zatímco Qwen to trvalo 9,82 sekundy s 92% úspěšností – téměř čtyřikrát déle.

Tento experiment ukazuje nárůst rychlosti, ale je zde kompromis: kolik inteligence by mělo být v modelu ve srovnání se samotnými nástroji. Tento omezený

U větších modelů, jako je Qwen, mohou být nástroje jednodušší, protože model má lepší odolnost proti chybám a dokáže obejít špatně navržená rozhraní. Model kompenzuje omezení nástroje pomocí uvažování hrubou silou.

U menších modelů má model menší schopnost zotavit se z chyb, takže nástroje musí být robustnější a logika výběru přesnější. Může se to zdát jako omezení, ale ve skutečnosti se jedná o funkci.

Toto omezení eliminuje složenou chybovost zřetězených nástrojů LLM. Když velké modely provádějí sekvenční volání nástrojů, chyby se hromadí exponenciálně.

Malé akční modely si vynucují lepší návrh systému, zachovávají to nejlepší z LLM a kombinují je se specializovanými modely.

Tato architektura je efektivnější, rychlejší a předvídatelnější.

5,27K

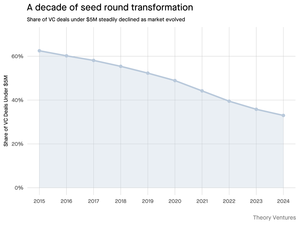

Proč se počáteční kolo pod 5 milionů dolarů zmenšuje?

Před deseti lety tvořila tato menší kola páteř financování startupů a tvořila více než 70 % všech počátečních obchodů. Dnes data PitchBooku ukazují, že toto číslo kleslo na méně než polovinu.

Čísla vyprávějí drsný příběh. Obchody pod 5 milionů USD klesly z 62,5 % v roce 2015 na 37,5 % v roce 2024. Tento pokles o 29,5 procentního bodu zásadně změnil způsob, jakým startupy získávají svůj první institucionální kapitál.

Tuto transformaci poháněly tři síly. Můžeme tento úpadek rozložit, abychom pochopili, co snížilo malé počáteční kolo a proč je to pro zakladatele dnes důležité.

4,68K

To byla taková zábava, Mario. Díky, že jste mě pozvali do pořadu, abych mluvil o všem, co se děje na trhu!

Mario Gabriele 🦊22. 7. 2025

Naše nejnovější epizoda s Tomaszem Tunguzem je živá!

Desetiletí dat

@ttunguz strávil téměř dvě desetiletí přeměnou dat na investiční poznatky. Poté, co podpořil společnosti Looker, Expensify a Monte Carlo ve společnosti Redpoint Ventures, zahájil v roce 2022 @Theoryvc s odvážnou vizí: vybudovat "investiční společnost", kde výzkumníci, inženýři a provozovatelé sedí po boku investorů a vytvářejí tržní mapy v reálném čase a interní nástroje umělé inteligence. Jeho debutový fond uzavřel na 238 milionech dolarů, následovaný o pouhých 19 měsíců později druhým fondem ve výši 450 milionů dolarů. Společnost Theory, která se zaměřuje na data, umělou inteligenci a kryptografickou infrastrukturu, působí v srdci dnešních nejzávažnějších technologických změn. Zkoumáme, jak data přetvářejí rizikový kapitál, proč jsou narušovány tradiční investiční modely a co je potřeba k vybudování firmy, která nejen předpovídá budoucnost, ale aktivně ji pomáhá vytvářet.

Poslechněte si nyní:

• YouTube:

• Spotify:

•Jablko:

Velké poděkování patří neuvěřitelným sponzorům, díky kterým podcast vzniká:

✨ Brex — Bankovní řešení pro startupy:

✨ Generalist+ — Základní inteligence pro moderní investory a technology:

Zkoumáme:

→ Jak funguje model "investiční korporace" společnosti Theory

→ Proč by kryptoburzy mohly vytvořit životaschopnou cestu na veřejné trhy pro softwarové společnosti s malou tržní kapitalizací

→ Hrozící energetická krize – proč by datová centra mohla do pěti let spotřebovávat 15 % elektřiny v USA

→ rychlý vzestup stablecoinů, protože hlavní banky přes ně přesměrovávají 5-10 % amerických dolarů

→ Proč Ethereum čelí existenční výzvě podobné tomu, když AWS v éře umělé inteligence ztrácí půdu pod nohama ve prospěch Azure

→ Proč Tomasz věří, že z dnešní hrstky agentů se do konce roku stane 100+ digitálních spolupracovníků

→ Proč Meta sází miliardy na brýle pro rozšířenou realitu, aby změnila způsob, jakým komunikujeme se stroji

→ Jak Theory Ventures využívá umělou inteligenci k urychlení průzkumu trhu, analýzy obchodů a investičních rozhodnutí

… A mnohem více!

7,98K

OpenAI obdrží v průměru 1 dotaz na Američana denně.

Google obdrží přibližně 4 dotazy na Američana denně.

Od té doby má 50 % vyhledávacích dotazů Google přehledy AI, což znamená, že nejméně 60 % vyhledávání v USA je nyní AI.

Trvalo to trochu déle, než jsem očekával, než se to stalo. V roce 2024 jsem předpověděl, že 50 % spotřebitelských vyhledávání bude vybaveno umělou inteligencí. (

Umělá inteligence však dorazila do vyhledávání.

Pokud jsou vzorce vyhledávání Google nějakým ukazatelem, existuje zákon síly v chování vyhledávání. Analýza chování ve vyhledávání Google společnosti SparkToro ukazuje, že horní třetina Američanů, kteří vyhledávají, provádí více než 80 % všech vyhledávání – což znamená, že využití umělé inteligence pravděpodobně nebude rovnoměrně rozloženo – jako v budoucnosti.

Webové stránky a podniky začínají pociťovat dopady tohoto jevu. Článek v The Economist "Umělá inteligence zabíjí web. Může ho něco zachránit?" zachycuje duch doby v titulku. (

Naprostá většina Američanů nyní vyhledává pomocí umělé inteligence. Druhořadé efekty ze změny vzorců vyhledávání přicházejí ve druhé polovině tohoto roku a více lidí se bude ptát: "Co se stalo s mým provozem?" (

AI je nový distribuční kanál a ti, kteří jej využijí, získají podíl na trhu.

- William Gibson viděl mnohem dále do budoucnosti!

- Toto je založeno na analýze středního bodu grafu SparkToro, je to velmi jednoduchá analýza a v důsledku toho má nějakou chybu.

8,85K

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější