Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Tomasz Tunguz

GPT-5 oppnår 94.6 % nøyaktighet på AIME 2025, noe som tyder på nesten menneskelig matematisk resonnement.

Men be den om å spørre databasen din, og suksessraten stuper til tenåringene.

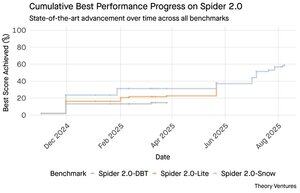

Spider 2.0-referansene avslører et gapende gap i AI-evner. Spider 2.0 er en omfattende tekst-til-SQL-referanse som tester AI-modellers evne til å generere nøyaktige SQL-spørringer fra spørsmål på naturlig språk på tvers av databaser i den virkelige verden.

Mens store språkmodeller har erobret kunnskapsarbeid innen matematikk, koding og resonnement, er tekst-til-SQL fortsatt vanskelig.

De tre Spider 2.0-referansene tester databasespørringer i den virkelige verden på tvers av forskjellige miljøer. Spider 2.0-Snow bruker Snowflake-databaser med 547 testeksempler, og topper seg med 59,05 % nøyaktighet.

Spider 2.0-Lite spenner over BigQuery, Snowflake og SQLite med ytterligere 547 eksempler, og når bare 37,84 %. Spider 2.0-DBT tester kodegenerering mot DuckDB med 68 eksempler, og topper på 39.71 %.

Dette ytelsesgapet er ikke på grunn av mangel på forsøk. Siden november 2024 har 56 bidrag fra 12 modellfamilier konkurrert på disse referansene.

Claude, OpenAI, DeepSeek og andre har alle presset modellene sine mot disse testene. Fremgangen har vært jevn, fra omtrent 2 % til rundt 60 %, de siste ni månedene.

Puslespillet blir dypere når du vurderer SQLs begrensninger. SQL har et begrenset ordforråd sammenlignet med engelsk, som har 600 000 ord, eller programmeringsspråk som har mye bredere syntakser og biblioteker å kjenne til. I tillegg er det nok av SQL der ute å trene på.

Om noe, burde dette være enklere enn de åpne resonneringsoppgavene der modeller nå utmerker seg.

Men selv perfekt SQL-generering ville ikke løse den virkelige forretningsutfordringen. Hvert selskap definerer "inntekt" forskjellig.

Marketing måler kundeanskaffelseskostnader etter kampanjeutgifter, salg beregner det ved hjelp av kontolederkostnader, og økonomi inkluderer fulllastede ansattutgifter. Disse semantiske forskjellene skaper forvirring som teknisk nøyaktighet ikke kan løse.

Spider 2.0-resultatene peker på en grunnleggende sannhet om dataarbeid. Tekniske ferdigheter i SQL-syntaks er bare inngangspunktet.

Den virkelige utfordringen ligger i forretningssammenheng. Forstå hva dataene betyr, hvordan ulike team definerer beregninger, og når kanttilfeller betyr noe. Som jeg skrev om i Semantic Cultivators, krever broen mellom rådata og forretningsmening menneskelig dømmekraft som dagens AI ikke kan replikere.

9,22K

GPT-5 oppnår 94.6 % nøyaktighet på AIME 2025, noe som tyder på nesten menneskelig matematisk resonnement.

Men be den om å spørre databasen din, og suksessraten stuper til tenåringene.

Spider 2.0-referansene avslører et gapende gap i AI-evner. Spider 2.0er en omfattende tekst-til-SQL-referanse som tester AI-modellers evne til å generere nøyaktige SQL-spørringer fra naturlige språkspørsmål på tvers av virkelige databaser.

Mens store språkmodeller har erobret kunnskapsarbeid innen matematikk, koding og resonnement, er tekst-til-SQL fortsatt vanskelig.

De tre Spider 2.0-referansene tester databasespørringer i den virkelige verden på tvers av forskjellige miljøer. Spider 2.0-Snow bruker Snowflake-databaser med 547 testeksempler, og topper seg med 59,05 % nøyaktighet.

Spider 2.0-Lite spenner over BigQuery, Snowflake og SQLite med ytterligere 547 eksempler, og når bare 37,84 %. Spider 2.0-DBT tester kodegenerering mot DuckDB med 68 eksempler, og topper på 39.71 %.

Dette ytelsesgapet er ikke på grunn av mangel på forsøk. Siden november 2024 har 56 bidrag fra 12 modellfamilier konkurrert på disse referansene.

Claude, OpenAI, DeepSeek og andre har alle presset modellene sine mot disse testene. Fremgangen har vært jevn, fra omtrent 2 % til rundt 60 %, de siste ni månedene.

Puslespillet blir dypere når du vurderer SQLs begrensninger. SQL har et begrenset ordforråd sammenlignet med engelsk, som har 600 000 ord, eller programmeringsspråk som har mye bredere syntakser og biblioteker å kjenne til. I tillegg er det nok av SQL der ute å trene på.

Om noe, burde dette være enklere enn de åpne resonneringsoppgavene der modeller nå utmerker seg.

Men selv perfekt SQL-generering ville ikke løse den virkelige forretningsutfordringen. Hvert selskap definerer "inntekt" forskjellig.

Marketing måler kundeanskaffelseskostnader etter kampanjeutgifter, salg beregner det ved hjelp av kontolederkostnader, og økonomi inkluderer fulllastede ansattutgifter. Disse semantiske forskjellene skaper forvirring som teknisk nøyaktighet ikke kan løse.

Spider 2.0-resultatene peker på en grunnleggende sannhet om dataarbeid. Tekniske ferdigheter i SQL-syntaks er bare inngangspunktet.

Den virkelige utfordringen ligger i forretningssammenheng. Forstå hva dataene betyr, hvordan ulike team definerer beregninger, og når kanttilfeller betyr noe. Som jeg skrev om i Semantic Cultivators, krever broen mellom rådata og forretningsmening menneskelig dømmekraft som dagens AI ikke kan replikere.

4,1K

Perplexity AI ga nettopp et uoppfordret tilbud på 34.5 milliarder dollar for Googles Chrome-nettleser, og forsøkte å utnytte den ventende antitrust-kjennelsen som kan tvinge Google til å selge nettleservirksomheten sin.

Å sammenligne Chromes økonomi med Googles eksisterende Safari-avtale avslører hvorfor 34.5 milliarder dollar undervurderer nettleseren.

Google betaler Apple 18–20 milliarder dollar årlig for å forbli Safaris standard søkemotor¹, og betjener omtrent 850 millioner brukere². Dette tilsvarer $21 per bruker per år.

Perplexity-tilbudet verdsetter Chrome til $32b, som er $9 per bruker per år for sine 3.5b brukere³.

Hvis Chrome-brukere hadde de samme vilkårene som Google/Apple Safari-avtalen, ville nettleserens årlige inntektspotensial overstige 73 milliarder dollar.

Disse dataene er basert på offentlige estimater, men er en tilnærming.

Dette forutsetter at Google betaler en ny eier av Chrome et tilsvarende skalert gebyr for standard søkeplassering. Gitt en 5x til 6x markedsverdi til inntektsmultiplum, er Chrome verdt et sted mellom 172 milliarder dollar og 630 milliarder dollar, langt fra tilbudet på 34,5 milliarder dollar.

Chrome dominerer markedet med 65 % andel⁴, sammenlignet med Safaris 18 %. Et nedsalg vil sette søkeannonsemarkedet i omveltning. Verdien av å holde annonsørbudsjetter er vanskelig å overvurdere for Googles markedsverdi og posisjon i annonseøkosystemet.

Hvis de blir tvunget til å selge Chrome, vil Google stå overfor et eksistensielt valg. Betal det som trengs for å forbli standard søkemotor, eller se konkurrenter gjøre den mest verdifulle distribusjonskanalen til en kamp mot den.

Hvor mye er det verdt? En betydelig premie til en enkel inntektsmultipel.

¹ Bloomberg: Googles betalinger til Apple nådde 20 milliarder dollar i 2022 (

² ZipDo: Viktig Apple Safari-statistikk i 2024 (

³ Backlinko: Markedsandel for nettlesere i 2025 (

⁴ Statcounter: Nettlesermarkedsandel over hele verden (

8,08K

I 1999 ble dotcomene verdsatt på trafikk. IPO-beregninger dreide seg om øyeepler.

Så lanserte Google AdWords, en annonsemodell basert på klikk, og bygde en virksomhet på 273 milliarder dollar i 2024.

Men det kan være i ferd med å endre seg: Pew Researchs studie fra juli 2025avslører at brukere klikker på bare 8 % av søkeresultatene med AI-sammendrag, mot 15 % uten - en reduksjon på 47 %. Bare 1 % klikker seg gjennom fra AI-sammendrag.

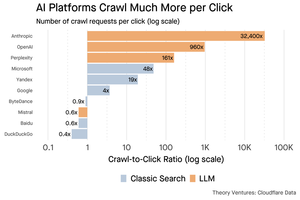

Cloudflare-data viser at AI-plattformer gjennomsøker innhold langt mer enn de henviser trafikk tilbake: Anthropic gjennomsøker 32 400 sider for hver 1 henvisning, mens tradisjonelle søkemotorer skanner innhold bare et par ganger per besøkende som sendes.

Utgiftene ved å servere innhold til AI-crawlerne er kanskje ikke store hvis det for det meste er tekst.

Det større poenget er at AI-systemer forstyrrer forholdet mellom bruker og utgiver. Brukere foretrekker aggregerte AI-svar fremfor å klikke gjennom nettsteder for å finne svarene deres.

Det er logisk at de fleste nettsteder bør forvente mindre trafikk. Hvordan vil nettstedet ditt og virksomheten din håndtere det?

Kilder:

- Pew Research Center - Athena Chapekis, 22 juli 2025 (

- Cloudflare: Krypingen før henvisningene faller (

- Cloudflare-radar: AI-innsikt - Gjennomsøk for å henvise forhold (

- Podcast: Den skiftende verdien av innhold i AI-alderen (

9,74K

GPT-5 ble lansert i går. 94.6 % på AIME 2025. 74,9 % på SWE-benken.

Når vi nærmer oss de øvre grensene for disse referansene, dør de.

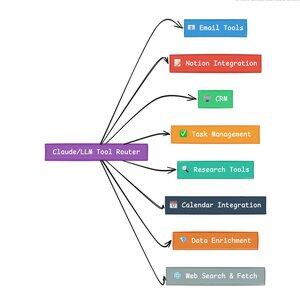

Det som gjør GPT-5 og neste generasjon modeller revolusjonerende er ikke deres kunnskap. Det er å vite hvordan man skal handle. For GPT-5 skjer dette på to nivåer. Først å bestemme hvilken modell du skal bruke. Men for det andre, og enda viktigere, gjennom verktøykall.

Vi har levd i en tid der LLM-er mestret kunnskapsinnhenting og remontering. Forbrukersøk og koding, de første morderapplikasjonene, er grunnleggende kunnskapsinnhentingsutfordringer. Begge organiserer eksisterende informasjon på nye måter.

Vi har klatret disse bakkene, og som et resultat er konkurransen mer intens enn noen gang. Anthropic, OpenAI og Googles modeller konvergerer på lignende funksjoner. Kinesiske modeller og åpen kildekode-alternativer fortsetter å presse seg stadig nærmere toppmoderne. Alle kan hente informasjon. Alle kan generere tekst.

Den nye konkurranseaksen? Verktøy-kall.

Tool-calling forvandler LLM-er fra rådgivere til skuespillere. Det kompenserer for to kritiske modellsvakheter som rene språkmodeller ikke kan overvinne.

For det første, orkestrering av arbeidsflyt. Modeller utmerker seg ved enkeltbilderesponser, men sliter med flertrinns, tilstandsfulle prosesser. Verktøy gjør dem i stand til å administrere lange arbeidsflyter, spore fremdrift, håndtere feil, opprettholde kontekst på tvers av dusinvis av operasjoner.

For det andre, systemintegrasjon. LLM-er lever i en verden med kun tekst. Verktøy lar dem kommunisere forutsigbart med eksterne systemer som databaser, APIer og bedriftsprogramvare, og gjøre naturlig språk til kjørbare handlinger.

I løpet av den siste måneden har jeg bygget 58 forskjellige AI-verktøy.

E-postbehandlere. CRM-integratorer. Oppdaterere av forestillinger. Vitenskapelige assistenter. Hvert verktøy utvider modellens muligheter til et nytt domene.

Den viktigste funksjonen for AI er å velge riktig verktøy raskt og riktig. Hvert feildirigerte trinn dreper hele arbeidsflyten.

Når jeg sier "les denne e-posten fra Y Combinator og finn alle oppstartene som ikke er i CRM", utfører moderne LLM-er en kompleks sekvens.

Én kommando på engelsk erstatter en hel arbeidsflyt. Og dette er bare en enkel en.

Enda bedre, modellen, riktig satt opp med de riktige verktøyene, kan verifisere sitt eget arbeid at oppgavene ble fullført i tide. Denne selvverifiseringssløyfen skaper pålitelighet i arbeidsflyter som er vanskelig å oppnå ellers.

Multipliser dette på tvers av hundrevis av ansatte. Tusenvis av arbeidsflyter. Produktivitetsgevinstene sammensettes eksponentielt.

Vinnerne i fremtidens AI-verden vil være de som er mest sofistikerte til å orkestrere verktøy og rute de riktige spørringene. Hver gang. Når disse arbeidsflytene er forutsigbare, er det da vi alle vil bli agentledere.

3,22K

2025 er agentenes år, og nøkkelfunksjonen til agenter er å ringe verktøy.

Når jeg bruker Claude Code, kan jeg be AI om å sile gjennom et nyhetsbrev, finne alle lenkene til startups, bekrefte at de finnes i CRM-en vår, med en enkelt kommando. Dette kan innebære at to eller tre forskjellige verktøy kalles.

Men her er problemet: å bruke en stor fundamentmodell for dette er dyrt, ofte prisbegrenset og overmannet for en utvalgsoppgave.

Hva er den beste måten å bygge et agentisk system med verktøykall?

Svaret ligger i små handlingsmodeller. NVIDIA ga ut en overbevisende artikkel som argumenterte for at "Små språkmodeller (SLM-er) er tilstrekkelig kraftige, iboende mer egnet og nødvendigvis mer økonomiske for mange påkallelser i agentiske systemer."

Jeg har testet forskjellige lokale modeller for å validere en kostnadsreduksjonsøvelse. Jeg startet med en Qwen3:30b-parametermodell, som fungerer, men som kan være ganske treg fordi det er en så stor modell, selv om bare 3 milliarder av de 30 milliarder parameterne er aktive til enhver tid.

NVIDIA-dokumentet anbefaler Salesforce xLAM-modellen – en annen arkitektur kalt en stor handlingsmodell spesielt designet for verktøyvalg.

Så jeg kjørte en egen test, hver modell kalte et verktøy for å liste opp Asana-oppgavene mine.

Resultatene var slående: xLAM fullførte oppgaver på 2,61 sekunder med 100 % suksess, mens Qwen tok 9,82 sekunder med 92 % suksess – nesten fire ganger så lenge.

Dette eksperimentet viser hastighetsøkningen, men det er en avveining: hvor mye intelligens som skal bo i modellen kontra i selve verktøyene. Denne begrensede

Med større modeller som Qwen kan verktøy være enklere fordi modellen har bedre feiltoleranse og kan omgå dårlig utformede grensesnitt. Modellen kompenserer for verktøybegrensninger gjennom brute-force-resonnement.

Med mindre modeller har modellen mindre kapasitet til å komme seg etter feil, så verktøyene må være mer robuste og seleksjonslogikken mer presis. Dette kan virke som en begrensning, men det er faktisk en funksjon.

Denne begrensningen eliminerer sammensetningsfeilraten for LLM-kjedede verktøy. Når store modeller foretar sekvensielle verktøykall, akkumuleres feil eksponentielt.

Små handlingsmodeller tvinger frem bedre systemdesign, beholder det beste fra LLM-er og kombinerer det med spesialiserte modeller.

Denne arkitekturen er mer effektiv, raskere og mer forutsigbar.

5,34K

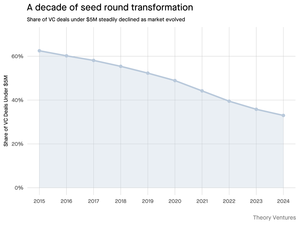

Hvorfor krymper frørunden på under 5 millioner dollar?

For et tiår siden utgjorde disse mindre rundene ryggraden i oppstartsfinansiering, og utgjorde over 70 % av alle såkornavtaler. I dag avslører PitchBook-data at tallet har stupt til mindre enn halvparten.

Tallene forteller en sterk historie. Avtaler under 5 millioner dollar falt fra 62,5 % i 2015 til 37,5 % i 2024. Dette fallet på 29,5 prosentpoeng endret fundamentalt hvordan startups skaffer sin første institusjonelle kapital.

Tre krefter drev denne transformasjonen. Vi kan bryte ned nedgangen for å forstå hva som reduserte den lille frørunden og hvorfor den er viktig for gründere i dag.

4,74K

Dette var så gøy, Mario. Takk for at jeg var med på showet for å snakke om alt som skjer på markedet!

Mario Gabriele 🦊22. juli 2025

Vår siste episode med Tomasz Tunguz er live!

Tiåret med data

@ttunguz har brukt nesten to tiår på å gjøre data om til investeringsinnsikt. Etter å ha støttet Looker, Expensify og Monte Carlo hos Redpoint Ventures, lanserte han @Theoryvc i 2022 med en dristig visjon: bygge et "investeringsselskap" der forskere, ingeniører og operatører sitter sammen med investorer, og lager markedskart i sanntid og interne AI-verktøy. Debutfondet hans stengte på 238 millioner dollar, etterfulgt bare 19 måneder senere av et andre fond på 450 millioner dollar. Theory er sentrert om data, AI og kryptoinfrastruktur, og opererer i hjertet av dagens mest betydningsfulle teknologiske skift. Vi utforsker hvordan data omformer risikokapital, hvorfor tradisjonelle investeringsmodeller blir forstyrret, og hva som skal til for å bygge et firma som ikke bare forutsier fremtiden, men aktivt bidrar til å skape den.

Hør nå:

• YouTube:

• Spotify:

•Eple:

En stor takk til de utrolige sponsorene som gjør podcasten mulig:

✨ Brex — Bankløsningen for startups:

✨ Generalist+ — Viktig intelligens for moderne investorer og teknologer:

Vi utforsker:

→ Hvordan Theorys «investerende selskap»-modell fungerer

→ Hvorfor kryptobørser kan skape en levedyktig vei til offentlige markeder for små programvareselskaper

→ Den truende strømkrisen – hvorfor datasentre kan forbruke 15 % av amerikansk elektrisitet innen fem år

→ Stablecoins' raske oppstigning når store banker ruter 5-10 % av amerikanske dollar gjennom dem

→ Hvorfor Ethereum står overfor en eksistensiell utfordring som ligner på at AWS taper terreng til Azure i AI-æraen

→ Hvorfor Tomasz tror dagens håndfull agenter vil bli 100+ digitale medarbeidere innen utgangen av året

→ Hvorfor Meta satser milliarder på AR-briller for å endre hvordan vi samhandler med maskiner

→ Hvordan Theory Ventures bruker AI for å akselerere markedsundersøkelser, avtaleanalyse og investeringsbeslutninger

… Og mye mer!

8,05K

OpenAI mottar i gjennomsnitt 1 spørring per amerikaner per dag.

Google mottar omtrent 4 søk per amerikaner per dag.

Siden den gang har 50 % av Google-søkene AI-oversikter, noe som betyr at minst 60 % av amerikanske søk nå er AI.

Det har tatt litt lengre tid enn jeg forventet før dette skulle skje. I 2024 spådde jeg at 50 % av forbrukersøk ville være AI-aktivert. (

Men AI har kommet i søket.

Hvis Googles søkemønstre er noen indikasjon, er det en maktlov i søkeatferd. SparkToros analyse av Googles søkeatferd viser at den øverste tredjedelen av amerikanere som søker, utfører oppover 80 % av alle søk – noe som betyr at AI-bruk sannsynligvis ikke er jevnt fordelt – som fremtiden.

Nettsteder og bedrifter begynner å føle virkningene av dette. The Economists artikkel "AI dreper nettet. Kan noe redde det?» fanger tidsånden i en overskrift. (

Et overveldende flertall av amerikanere søker nå med AI. Andreordenseffektene fra endrede søkemønstre kommer i andre halvdel av dette året, og flere vil spørre: "Hva skjedde med trafikken min?" (

AI er en ny distribusjonskanal, og de som griper den vil ta markedsandeler.

- William Gibson så mye lenger inn i fremtiden!

- Dette er basert på en midtpunktsanalyse av SparkToro-diagrammet, er en veldig enkel analyse, og har noen feil som resultat.

8,92K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til