Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dyk ner i @nvidia 🐰 Hopper vs ⚙️ Blackwell GPU-arkitekturer – successiva språng i beräkningskraft och sammankopplingar för dina AI-arbetsbelastningar👇

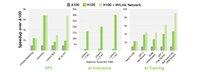

🐰 Hopper (H100 och H200) introducerade 4:e generationens Tensor-kärnor + en FP8 transformatormotor, vilket ger upp till 9 × snabbare träning och 30 × snabbare inferens jämfört med A100.

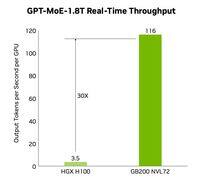

⚙️ Blackwell (B200) – som levereras i slutet av 2024 – parar ihop två matriser över en NV-HBI på 10 TB/s, lägger till FP4 och använder NVLink-5 för upp till 30 × klusterinferens.

🐰 @nvidia Hopper specifikationer

Tensor-kärnor: blandad FP8/FP16/TF32

Minne:

- H100 → 80 GB HBM3 @ 3,35 TB/s

- H200 → 141 GB HBM3e @ 4,8 TB/s

NVLink: upp till 900 GB/s per GPU

🐰 @nvidia Hopper i aktion

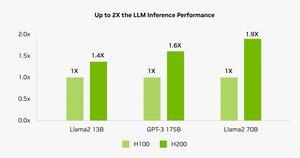

Benchmarks visar att H200 driver Llama-2 70B-inferens 45–100 % snabbare jämfört med H100.

⚠️ Båda upplevde försörjningskriser under 2023–25.

💻 I Hyperbolics moln: H100 VM:er och bare-metal-kluster med Ethernet + InfiniBand från $1.49/timme. H200 och B200 via omedelbar offert.

⚙️ @nvidia Blackwell Innovationer

- Chiplet-design (TSMC 4NP, 208 B-transistorer, 10 TB/s NV-HBI)

- 2:a generationens transformatormotor: FP4 + förbättrad FP8

- NVLink-5: 18 länkar @ 1,8 TB/s totalt

- Dekomprimeringsmotor: 800 GB/s CPU↔GPU

- Fullständig RAS och konfidentiell beräkning

📊 Jämföra prestanda

H100 SXM: 80 GB @ 3,35 TB/s, 3,96 PFLOPS (FP8), 1,98 PFLOPS (FP16), 67 TFLOPS (FP32), NVLink 900 GB/s, 700 W

H200 SXM: 141 GB @ 4,8 TB/s, samma PFLOPS/TFLOPS, NVLink 900 GB/s, 700 W

HGX B200: 180 GB @ 7.7 TB/s, 9 PFLOPS (FP8), 4.5 PFLOPS (FP16), 75 TFLOPS (FP32), NVLink 1.8 TB/s, 1000 W

❓ @nvidia Vad är en FLOPP?

1 flyttalsoperation (add/mul)

1 TFLOP = 10¹² ops/s

1 PFLOP = 10¹⁵ ops/s = 1000× en TFLOP

Dessa mätvärden visar hur snabbt GPU:er bearbetar den massiva matematiken bakom AI-träning och HPC.

🔚 @nvidia Avslutning:

🐰 Hopper sätter ribban med FP8 mixed-precision & asynkrona pipelines.

⚙️ Blackwell pushar nästa generation med FP4, mer minne, NVLink-5.

H100 är fortfarande arbetshästen – hyran är 1,49 dollar i timmen.

H200 och B200 finns tillgängliga på begäran via

@nvidia Läs hela artikeln på:

6,99K

Topp

Rankning

Favoriter