Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jakub Pachocki

OpenAI

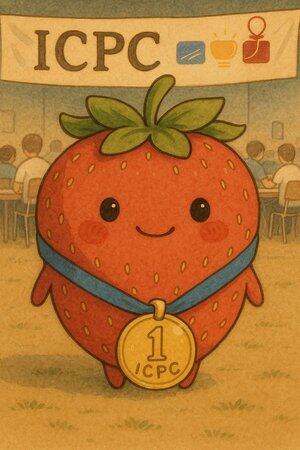

La scorsa settimana, i nostri modelli di ragionamento hanno partecipato al Concorso Internazionale di Programmazione Universitaria (ICPC) 2025, la principale competizione di programmazione a livello universitario al mondo. Il nostro sistema ha risolto tutti e 12 i problemi, una prestazione che avrebbe garantito il primo posto nel mondo (il miglior team umano ha risolto 11 problemi).

Questo traguardo conclude due mesi intensi di prestazioni competitive dei nostri modelli:

- Un secondo posto alle Finali Mondiali di AtCoder Heuristics

- Medaglia d'oro alle Olimpiadi Matematiche Internazionali

- Medaglia d'oro alle Olimpiadi Internazionali di Informatica

- E ora, una medaglia d'oro, primo posto alle Finali Mondiali ICPC.

Credo che questi risultati, provenienti da una famiglia di modelli di ragionamento generale radicati nel nostro principale programma di ricerca, siano forse il benchmark più chiaro dei progressi di quest'anno. Queste competizioni sono ottimi test autonomi e a tempo limitato per la capacità di scoprire nuove idee. Anche prima che i nostri modelli fossero competenti in aritmetica semplice, guardavamo a questi concorsi come traguardi di progresso verso un'intelligenza artificiale trasformativa.

I nostri modelli ora si collocano tra i migliori umani in questi ambiti, quando vengono posti di fronte a domande ben specificate e limitati a circa 5 ore. La sfida ora è passare a problemi più aperti e a orizzonti temporali molto più lunghi. Questo livello di capacità di ragionamento, applicato per mesi e anni a problemi che contano davvero, è ciò che stiamo cercando: automatizzare la scoperta scientifica.

Questo rapido progresso sottolinea anche l'importanza della ricerca sulla sicurezza e sull'allineamento. Abbiamo ancora bisogno di una maggiore comprensione delle proprietà di allineamento dei modelli di ragionamento a lungo termine; in particolare, consiglio di rivedere i risultati affascinanti dello studio sul complottare nei modelli di ragionamento che abbiamo rilasciato oggi (

Congratulazioni ai miei compagni di squadra che hanno messo il cuore per ottenere questi risultati nelle competizioni, e a tutti coloro che contribuiscono alla ricerca fondamentale sottostante che li rende possibili!

Mostafa Rohaninejad18 set, 01:06

1/n

Sono davvero entusiasta di condividere che il nostro sistema di ragionamento @OpenAI ha ottenuto un punteggio perfetto di 12/12 durante le Finali Mondiali ICPC 2025, la principale competizione di programmazione universitaria in cui i migliori team universitari di tutto il mondo risolvono complessi problemi algoritmici. Questo lo avrebbe collocato al primo posto tra tutti i partecipanti umani. 🥇🥇

190

Sono estremamente entusiasta del potenziale della fedeltà e dell'interpretabilità della catena di pensiero. Ha influenzato in modo significativo la progettazione dei nostri modelli di ragionamento, a partire da o1-preview.

Poiché i sistemi di intelligenza artificiale spendono più calcolo lavorando, ad esempio, su problemi di ricerca a lungo termine, è fondamentale avere un modo per monitorare il loro processo interno. La meravigliosa proprietà dei CoT nascosti è che, sebbene inizino con un linguaggio che possiamo interpretare, la procedura di ottimizzazione scalabile non è in contrasto con la capacità dell'osservatore di verificare l'intento del modello, a differenza ad esempio della supervisione diretta con un modello di ricompensa.

La tensione qui è che se i CoT non sono stati nascosti per impostazione predefinita, e consideriamo il processo come parte dell'output dell'IA, c'è un sacco di incentivo (e in alcuni casi, la necessità) di mettere una supervisione su di esso. Credo che qui possiamo lavorare per ottenere il meglio da entrambi i mondi: addestrare i nostri modelli a spiegare il loro ragionamento interno, ma allo stesso tempo mantenere la capacità di verificarlo occasionalmente.

La fedeltà al CoT fa parte di una più ampia direzione di ricerca, che è la formazione all'interpretabilità: fissare gli obiettivi in modo da formare almeno una parte del sistema a rimanere onesto e monitorabile con la scala. Stiamo continuando ad aumentare il nostro investimento in questa ricerca in OpenAI.

Bowen Baker16 lug 2025

I moderni modelli di ragionamento pensano in un inglese semplice.

Monitorare i loro pensieri potrebbe essere uno strumento potente, ma fragile, per supervisionare i futuri sistemi di intelligenza artificiale.

Io e i ricercatori di molte organizzazioni pensiamo che dovremmo lavorare per valutare, preservare e persino migliorare la monitorabilità del CoT.

379

Principali

Ranking

Preferiti