Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jakub Pachocki

OpenAI

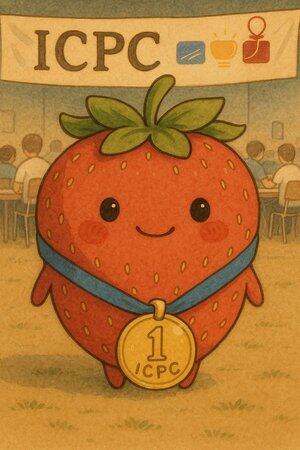

La semaine dernière, nos modèles de raisonnement ont participé au Concours International de Programmation Collégiale (ICPC) 2025, la première compétition de programmation au niveau universitaire au monde. Notre système a résolu tous les 12 problèmes sur 12, une performance qui aurait placé la première au monde (la meilleure équipe humaine a résolu 11 problèmes).

Cette étape clôture deux mois intenses de performances en compétition de nos modèles :

- Une deuxième place lors des finales mondiales d'AtCoder Heuristics

- Médaille d'or à l'Olympiade Mathématique Internationale

- Médaille d'or à l'Olympiade Internationale d'Informatique

- Et maintenant, une médaille d'or, une première place aux finales mondiales de l'ICPC.

Je crois que ces résultats, provenant d'une famille de modèles de raisonnement général ancrés dans notre programme de recherche principal, sont peut-être le meilleur indicateur de progrès cette année. Ces compétitions sont d'excellents tests autonomes et limités dans le temps pour la capacité à découvrir de nouvelles idées. Même avant que nos modèles ne soient compétents en arithmétique simple, nous avons considéré ces concours comme des jalons de progrès vers une intelligence artificielle transformative.

Nos modèles se classent désormais parmi les meilleurs humains dans ces domaines, lorsqu'ils sont confrontés à des questions bien spécifiées et limités à environ 5 heures. Le défi maintenant est de passer à des problèmes plus ouverts et à des horizons temporels beaucoup plus longs. Ce niveau de capacité de raisonnement, appliqué sur des mois et des années à des problèmes qui comptent vraiment, est ce que nous recherchons - automatiser la découverte scientifique.

Ce progrès rapide souligne également l'importance de la recherche sur la sécurité et l'alignement. Nous avons encore besoin de mieux comprendre les propriétés d'alignement des modèles de raisonnement à long terme ; en particulier, je recommande de revoir les résultats fascinants de l'étude sur la planification dans les modèles de raisonnement que nous avons publiés aujourd'hui.

Félicitations à mes coéquipiers qui ont mis tout leur cœur pour obtenir ces résultats en compétition, et à tous ceux qui contribuent à la recherche fondamentale sous-jacente qui les rend possibles !

Mostafa Rohaninejadil y a 20 heures

1/n

Je suis vraiment ravi de partager que notre système de raisonnement @OpenAI a obtenu un score parfait de 12/12 lors des finales mondiales ICPC 2025, la première compétition universitaire de programmation où les meilleures équipes universitaires du monde résolvent des problèmes algorithmiques complexes. Cela l'aurait placé en première position parmi tous les participants humains. 🥇🥇

140

Je suis extrêmement enthousiaste à propos du potentiel de la fidélité et de l’interprétabilité de la chaîne de pensée. Il a considérablement influencé la conception de nos modèles de raisonnement, à commencer par o1-preview.

Comme les systèmes d’IA consacrent plus de calcul à des problèmes de recherche à long terme, il est essentiel que nous disposions d’un moyen de surveiller leur processus interne. La merveilleuse propriété des CoT cachés est que, bien qu’ils soient initialement fondés sur un langage que nous pouvons interpréter, la procédure d’optimisation évolutive n’est pas antagoniste à la capacité de l’observateur à vérifier l’intention du modèle - contrairement par exemple à la supervision directe avec un modèle de récompense.

La tension ici est que si les CoTs n’ont pas été cachés par défaut, et que nous considérons le processus comme faisant partie de la production de l’IA, il y a beaucoup d’incitation (et dans certains cas, de nécessité) à y mettre une supervision. Je crois que nous pouvons travailler vers le meilleur des deux mondes ici - entraîner nos modèles à être excellents pour expliquer leur raisonnement interne, tout en conservant la capacité de le vérifier de temps en temps.

La fidélité CoT fait partie d’une direction de recherche plus large, qui est l’entraînement à l’interprétabilité : fixer des objectifs de manière à former au moins une partie du système à rester honnête et contrôlable à grande échelle. Nous continuons d’augmenter notre investissement dans cette recherche chez OpenAI.

Bowen Baker16 juil. 2025

Modern reasoning models think in plain English.

Monitoring their thoughts could be a powerful, yet fragile, tool for overseeing future AI systems.

I and researchers across many organizations think we should work to evaluate, preserve, and even improve CoT monitorability.

325

Meilleurs

Classement

Favoris