Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Professor Jo

Sulla base della sua carriera nel settore dell'acquisition finance, è un "Joseon" agricoltore DeFi che corre verso un sogno più grande nella DeFi. @0xundefined_

<Intervista ai Pudgy Penguins>

I Pudgy Penguins (@pudgypenguins) sono emersi come uno degli IP più amati nel mondo delle criptovalute, unendo la cultura crypto con il mainstream attraverso giocattoli, meme e narrazione.

Guidato dal CEO @LucaNetz, il progetto si sta ora espandendo in ETF, Layer 2 e licenze globali.

Stasera alle 23:00 KST, saremo accompagnati da Luca per parlare del prossimo Pudgy ETF, del loro nuovo L2 "Abstract" e di come Pudgy stia trasformando la dolcezza in capitale.

👉

25,75K

<Perché ZK ha fallito e cosa vuole cambiare Succinct?>

1. Consapevolezza del problema

Il creatore di Bitcoin, Satoshi Nakamoto, ha espresso scetticismo sulle prove a conoscenza zero (ZKP).

"Per dimostrare che qualcosa non esiste, è necessario conoscere l'intera transazione", ha affermato, e ha giudicato che l'applicazione degli ZKP alle blockchain è strutturalmente difficile.

Tuttavia, ha anche detto: "Se troviamo una soluzione, sarà possibile implementare Bitcoin molto meglio, più facilmente e più conveniente". In altre parole, pur riconoscendo i limiti tecnici di ZK, hanno riconosciuto che se venissero affrontati, potrebbero essere un importante punto di svolta nell'evoluzione della blockchain.

Ora, anni dopo, la comunità cypherpunk e i ricercatori di ZK hanno finalmente trovato una soluzione. Zcash è stato il primo ad applicare ZKP alle criptovalute del mondo reale e da allora progetti come StarkWare, zkSync e Scroll hanno sviluppato questa tecnologia come mezzo chiave per migliorare la scalabilità e la verificabilità di Ethereum.

Tuttavia, c'è ancora un divario nella realtà. La creazione di zkEVM richiede competenze approfondite, anni di sviluppo e hardware ad alte prestazioni e la maggior parte dei progetti si affida a fornitori di prove specifici invece di gestire la propria infrastruttura ZKP. Di conseguenza, le ZKP sono rimaste uno strumento complesso che solo pochi potevano gestire, piuttosto che una "tecnologia che chiunque può utilizzare".

2. Che cos'è Succinct?

Succinct (@SuccinctLabs) è un tentativo di affrontare questo problema frontalmente. La chiave è trasformare gli ZKP in un'infrastruttura che possa essere facilmente utilizzata da tutti gli sviluppatori e aiutare chiunque a creare un "sistema trustless" senza la necessità di circuiti o infrastrutture complesse.

Succinct è un'infrastruttura che trasforma l'ideale di un sistema "trustless" che la blockchain ha perseguito in una realtà che può essere effettivamente realizzata. Trustless non significa "inaffidabile", ma si riferisce a una struttura che opera da sola senza la premessa della fiducia, cioè un sistema che può essere verificabile matematicamente senza la necessità di una terza parte o di un'autorità centrale.

Tuttavia, l'attuale ecosistema blockchain si basa ancora molto sulla fiducia. Gli hack dei bridge, le operazioni multisig e la delega centralizzata dei validatori sono la prova che il sistema funziona solo quando ci fidiamo ancora delle persone e delle organizzazioni.

Un tentativo di superare questo limite basato sulla fiducia è la tecnologia ZKP, o Zero-Knowledge Proof. Questa tecnologia, che ci permette di dimostrare matematicamente che "questo calcolo è corretto" senza doverci fidare di nessuno, è chiaramente una base fondamentale per i sistemi decentralizzati. Il problema era che gli ZKP erano troppo complessi e pesanti per essere effettivamente scritti.

3. Perché le ZKP erano difficili?

La tecnologia ZKP è stata tanto alta quanto il suo potenziale. In particolare, la creazione di zkEVM ha richiesto un team di professionisti, anni di sviluppo e un'infrastruttura costosa. La maggior parte dei progetti zk doveva progettare i propri circuiti, costruire zkVM dedicate e persino gestire l'hardware da soli. È stato solo dopo aver attraversato tutti questi processi che sono stati in grado di chiamarsi "ZK rollups".

Inoltre, le zkVM tradizionali per uso generico sono state altamente inefficienti nel generare dimostrazioni. Normalmente, la dimostrazione di un blocco richiedeva un cluster di dozzine di macchine ad alte prestazioni e il costo raggiungeva $ 10 ~ $ 20 per blocco. A causa di questo elevato onere tecnico e dei costi operativi, molti progetti hanno abbandonato l'introduzione delle ZKP o hanno optato per strutture che si basano su alcuni fornitori centralizzati di prove.

4. Il tentativo di Succinto

@SuccinctLabs considera questi problemi strutturali come "problemi di infrastrutture". Gli ZKP sono abbastanza potenti dal punto di vista tecnico, ma il problema è chi li implementa, come e a quale costo. Ecco perché Succinct sta creando una rete di prova decentralizzata che è facilmente accessibile a tutti, senza la necessità che i singoli progetti gestiscano la propria infrastruttura di prova.

Gli sviluppatori non devono configurare zkVM complesse o fornire hardware. Quando una richiesta di prova viene inviata alla rete, i prober con hardware diverso fanno un'offerta in un'asta per elaborarla. I costi di prova diminuiscono naturalmente a causa della concorrenza e i probatori generano in modo efficiente prove con apparecchiature ad alte prestazioni. Il risultato sono prove rapide ed economiche per gli sviluppatori e un'infrastruttura di prove altamente disponibile e resistente alla censura per l'intero ecosistema.

Succinct non sta solo dimostrando le sue possibilità tecniche, ma sta anche dimostrando il suo ruolo nelle aree in cui sorge una domanda reale. Un esempio tipico è il flusso "CLOBs on Blobs" emerso nell'ecosistema @celestia. Con l'emergere di order book decentralizzati (CLOB) ad alte prestazioni in cima allo spazio blob di Celestia, l'elaborazione dei dati su larga scala e le prove di stato rapide sono esigenze infrastrutturali essenziali.

Progetti come Hyperliquid e @hibachi_xyz stanno implementando complesse transazioni di order book e logiche di scoperta dei prezzi on-chain, che richiedono scalabilità e prestazioni che vanno oltre i semplici rollup. È qui che sono necessari il livello di disponibilità dei dati ad alte prestazioni di Celestia e l'infrastruttura decentralizzata a prova ZK fornita da Succinct .

In effetti, Celestia sta registrando un rapido aumento del tasso di utilizzo effettivo dello spazio blob, con l'infrastruttura ZK come Succinct che contribuisce silenziosamente dietro di essa. Se Celestia fornisce un "archivio dati verificabile", Succinct è responsabile della creazione di una "transizione di stato verificabile" su tali dati. Questa combinazione è il punto di partenza per la tecnologia ZKP per andare oltre le teorie astratte verso i sistemi del mondo reale.

5. zkEVM, SP1 e SP1 Reth che possono essere gestiti da chiunque

Succinct, che ha risolto in questo modo l'accessibilità dell'infrastruttura, ha sviluppato una zkVM open source chiamata SP1 (Succinct Processor 1) per abbassare la barriera all'ingresso per le zkVM stesse. SP1 è una zkVM generica implementata in Rust, progettata per essere utilizzata direttamente da chiunque senza la necessità di una complessa progettazione di circuiti come le zkEVM tradizionali.

Un primo esempio del potenziale di SP1 è SP1 Reth. SP1 Reth è uno zkEVM di tipo 1 implementato con circa 2.000 righe di codice Rust ed è facilmente costruibile riutilizzando componenti dall'ecosistema client Ethereum esistente (Reth, Revm, Alloy, ecc.). Ciò che è ancora più sorprendente sono le sue prestazioni. SP1 Reth ha un costo medio di prova per transazione Ethereum di soli $ 0,01 ~ 0,02, che è inferiore ai comuni costi di disponibilità dei dati su L2.

Queste prestazioni sono possibili grazie al sistema di "precompilazione" di SP1. Le operazioni ad alta intensità di calcolo, come le funzioni hash e la verifica delle firme, vengono gestite con una struttura pre-ottimizzata, riducendo significativamente le risorse consumate dalle zkVM. Fino ad ora, l'implementazione di zkEVM con zkVM è costata fino a $ 10 ~ 20 per blocco, ma SP1 Reth è riuscito a ridurre questo valore a una cifra.

Sia SP1 che SP1 Reth sono completamente open-source e chiunque può biforcarli per creare il proprio zkEVM o aggiungere precompilazioni per migliorare le prestazioni. Questo è un cambiamento che ribalta completamente l'attuale ambiente di sviluppo zk ad alto costo e ad alta difficoltà e apre un'era in cui qualsiasi sviluppatore di Rust può partecipare al sistema zk.

6. Dopotutto, ZK è ora disponibile per tutti

Succintt non riguarda solo il potenziale tecnico della tecnologia ZKP, ma anche l'ultimo pezzo del puzzle: accessibilità e praticità. Senza circuiti complessi o hardware dedicato, chiunque può creare applicazioni utilizzando ZKP e la prova viene gestita da una rete decentralizzata.

Un'epoca in cui tutti i rollup possono essere ZK rollup, e Internet che funziona solo con la verità. A quel punto di partenza ci sono Succinct e SP1. Ora, le ZKP sono la tecnologia di tutti, non di alcuni.

9,7K

<Perché il TVL di Ethereum sta aumentando rapidamente?>

L'emissione dello stablecoin di Ethereum, USDe, ha superato i 4 trilioni di won (3,1 miliardi di dollari). Questa cifra è superiore al totale degli afflussi netti dell'ETF di Ethereum e dell'ETF di Bitcoin di BlackRock combinati negli ultimi 20 giorni.

Cosa sta succedendo?

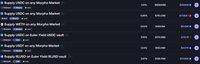

La ragione è sorprendentemente semplice. Fornendo il 50% di sUSDe e il 50% di USDe staked su Aave come garanzia, e prendendo in prestito USDC o USDT, gli utenti possono ricevere un reddito aggiuntivo attraverso una 'piattaforma di distribuzione degli incentivi'.

Grazie a questa struttura, è possibile un APY fino al 12%. Poiché consente rendimenti a due cifre con basso rischio utilizzando stablecoin, la domanda sta naturalmente aumentando.

Questa struttura che aumenta il TVL è una strategia spesso utilizzata nel DeFi. Ad esempio, all'inizio di quest'anno, Unichain ha offerto 21 milioni di dollari in incentivi e ha attratto oltre 250 milioni di dollari in fondi in un solo giorno.

L'aumento recente del TVL per Morpho ed Euler è simile. Dopo che Gauntlet, una società di gestione di vault, ha aperto vault per protocolli di prestito di piccole e medie dimensioni, hanno dato priorità alla fornitura di USDC e hanno stabilito asset collaterali preferiti dalle istituzioni per depositare garanzie e recuperare USDC. Questo ha portato a un aumento dell'APY e ha creato un ciclo virtuoso di afflussi di fondi retail.

In definitiva, comprendere il contesto dell'aumento del TVL nei protocolli DeFi consente di anticipare l'aumento corrispondente dei prezzi dei token.

4,6K

Il fulcro dell'industria dell'IA non è più l'informatica o i modelli, ma i "dati di alta qualità". Proprio come la civiltà umana è stata avanzata al livello successivo attraverso il petrolio in passato, anche l'IA ha bisogno di un nuovo "carburante" per andare oltre. Proprio come prima e dopo la seconda guerra mondiale, quando il petrolio veniva utilizzato come fonte di energia e materiale, l'industrializzazione progredì rapidamente. Ora, chi e come otterrà ed elaborerà i dati determinerà l'iniziativa nell'era dell'intelligenza artificiale.

Lo ha detto anche Elon Musk quest'anno. "Abbiamo esaurito tutta la somma cumulativa della conoscenza umana nell'apprendimento dell'intelligenza artificiale". È vero che modelli come GPT sono cresciuti rapidamente, raschiando dati pubblici come siti web, libri, codice e immagini. Ma ora abbiamo bisogno di una nuova forma di dati che sia protetta da copyright o che non esista affatto.

Ad esempio, in campi come i veicoli autonomi e la robotica, è necessario andare oltre il semplice testo e aver bisogno di dati complessi basati su più sensori che combinino telecamere, radar, lidar, ecc., nonché di dati di casi raccolti nell'ambiente reale, che non esistono sul web.

Il problema più grande non riguarda tanto la tecnologia, quanto "come combinarla bene". Migliaia di persone hanno bisogno di raccogliere, etichettare e aggiornare i dati in tutto il mondo ed è difficile gestire questa diversità e scalare con un approccio centralizzato al passato. Pertanto, l'industria dell'intelligenza artificiale è sempre più d'accordo sul fatto che il metodo decentralizzato sia la risposta.

È qui che appare "Poseidon (@psdnai)". Poseidon non è solo un data warehouse, ma un'infrastruttura che alimenta dati reali, li verifica e li perfeziona in un set di dati di addestramento che può essere utilizzato senza preoccuparsi del copyright.

Per usare un'analogia, Poseidon è una "raffineria di petrolio". Prende i dati grezzi e li raffina in carburante che l'intelligenza artificiale può utilizzare per l'apprendimento. L'intero processo va avanti e indietro sul @StoryProtocol. Registra in modo trasparente chi ha fornito i dati e chi li ha scritti in quali condizioni on-chain. Coloro che forniscono dati sono equamente ricompensati e gli sviluppatori di intelligenza artificiale possono utilizzarli con fiducia.

Penso che Poseidon, che innoverà a livello di dati, non di GPU o modelli, possa essere il miglior esempio di applicazione della tecnologia Web3 al settore Web2.

Chris Dixon23 lug 2025

Siamo entusiasti di annunciare che stiamo guidando un seed round da 15 milioni di dollari in Poseidon, che è stato incubato da @StoryProtocol e sta costruendo un livello di dati decentralizzato per coordinare la domanda e l'offerta di dati di addestramento dell'intelligenza artificiale.

La prima generazione di modelli di base dell'intelligenza artificiale è stata addestrata su dati che sembravano essere una risorsa effettivamente illimitata. Oggi, le risorse più accessibili come libri e siti web sono state per lo più esaurite e i dati sono diventati un fattore limitante per il progresso dell'intelligenza artificiale.

La maggior parte dei dati che rimangono ora sono di qualità inferiore o off-limits a causa delle protezioni IP. Per alcune delle applicazioni di intelligenza artificiale più promettenti, attraverso la robotica, i veicoli autonomi e l'intelligenza spaziale, i dati non esistono ancora. Ora questi sistemi hanno bisogno di tipi di informazioni completamente nuovi: multisensoriali, ricche di casi limite, catturate in natura. Da dove verranno tutti questi dati del mondo fisico?

La sfida non è solo tecnica, ma anche di coordinamento. Migliaia di collaboratori devono lavorare insieme in modo distribuito per reperire, etichettare e mantenere i dati fisici di cui l'IA di nuova generazione ha bisogno. Riteniamo che nessun approccio centralizzato sia in grado di orchestrare in modo efficiente la creazione e la cura dei dati necessarie al livello di scalabilità e diversità richiesto. Un approccio decentralizzato può risolvere questo problema.

@psdnai consente ai fornitori di raccogliere i dati di cui le aziende di intelligenza artificiale hanno bisogno, garantendo al contempo la sicurezza della proprietà intellettuale tramite la licenza IP programmabile di Story. Questo cerca di stabilire una nuova base economica per Internet, in cui i creatori di dati vengono equamente compensati per aiutare le aziende di intelligenza artificiale ad alimentare la prossima generazione di sistemi intelligenti.

Il team di Poseidon, guidato dal Chief Scientist e cofondatore @SPChinchali, apporta una profonda esperienza nell'infrastruttura AI. Sandeep è un professore presso l'UT Austin specializzato in intelligenza artificiale, robotica e sistemi distribuiti, con un dottorato di ricerca a Stanford in intelligenza artificiale e sistemi distribuiti. Head of Product e cofondatore @sarickshah trascorso un decennio come ingegnere di machine learning, scalando i prodotti di intelligenza artificiale per grandi aziende nei settori dei servizi finanziari, delle telecomunicazioni e della sanità.

Siamo entusiasti di supportare Poseidon nel suo lavoro per risolvere uno dei colli di bottiglia più critici nello sviluppo dell'intelligenza artificiale.

2,97K

<Perché Sonic è venuto in Corea?>

All'inizio di quest'anno, @SonicLabs entusiasmato i cuori di DeFi Diegen. In cima alla catena rapidamente riorganizzata, i nostalgici prodotti DeFi sono apparsi per la prima volta dopo molto tempo. A quel tempo si diceva che sarebbero stati distribuiti circa 200 milioni di token $S su base puntiforme, ovvero circa il 6% dell'offerta totale in circolazione, quindi c'era un grande clamore.

Tuttavia, poiché l'interesse globale per le chain specializzate nella DeFi è diminuito, Sonic deve sapere che non ci sono molti utenti all'estero che accetteranno questo volume.

Alla fine, penso che abbiamo pianificato questo evento basandoci sul fatto che l'unico mercato che poteva aspettarsi una risposta era la Corea. Tuttavia, ora che anche gli investitori coreani sono istruiti, si renderanno presto conto che non è così facile come una volta. Questo perché la maggior parte delle persone riunite all'evento sono agricoltori di airdrop, e i partecipanti di Yaping sono "debiti" dal punto di vista del progetto.

Dopotutto, se non si scommette su prodotti reali con uno spirito DeFi come prima, penso che sia difficile attirare di nuovo l'attenzione. Personalmente, è triste vedere il mio vecchio Sonic preferito essere spinto fuori dai riflettori come Vera.

seg.sonic17 lug 2025

Airdrop IRL @SonicLabs Corea 🔥🔥

1,69K

<La storia sta guadagnando nuovo slancio>

Si è unita una nuova figura @StoryProtocol sta rimodellando l'industria dei contenuti attraverso la tokenizzazione dell'IP.

Si tratta di Sandeep Chincharly, professore all'UT Austin ed esperto di intelligenza artificiale, robotica e sistemi distribuiti.

Sandeep Chin Charlie è un ex ricercatore della NASA che ha studiato intelligenza artificiale generativa e robotica cloud a Stanford ed è attualmente professore all'UT Austin, dove si occupa di guida autonoma e modelli di apprendimento automatico distribuito.

Nel corso della sua ricerca, ha installato una dash cam direttamente sul veicolo per raccogliere dati reali e ha analizzato scene rare chiamate "long-tails". Abbiamo etichettato questi dati, addestrato modelli di intelligenza artificiale leggeri direttamente sull'hardware TPU per il deep learning e apprezzato profondamente l'importanza della qualità e della scarsità dei dati.

Poi ha detto di essersi fatto una domanda.

"Affinché l'intelligenza artificiale funzioni correttamente nella realtà, ha bisogno di dati di alta qualità, non solo di modelli. E per raccogliere volontariamente tali dati, è necessaria un'efficace struttura di incentivi".

E ho trovato la risposta in Story.

@StoryProtocol definisce i dati come IP, non solo come risorse, e sta costruendo un sistema di ricompensa on-chain.

Raccolta di dati rari→ etichettatura→ sintesi → registrazione on-chain → distribuzione di royalty

Traccia in modo trasparente tutto sulla catena. Il professor Sandeep lo spiega così:

"Registro una rara scena di guida che ho girato con una dashcam su Story e il mio amico la etichetta. Quando l'intelligenza artificiale crea dati sintetici basati su di essi, viene generato un IP collegato lungo il percorso e le royalties vengono distribuite automaticamente a tutti i contributori".

In qualità di Chief AI Officer di Story, il professor Sandeep Chinchaly guiderà la strategia generale di intelligenza artificiale, l'infrastruttura dei dati di apprendimento on-chain e la progettazione di un sistema di ricompensa dei dati decentralizzato. E definisce il valore dei dati in questo modo.

"I dati sono la nuova proprietà intellettuale".

Story17 lug 2025

Ti presentiamo il nuovo Chief AI Officer di Story, @SPChinchali.

Sandeep è professore presso l'UT Austin e si occupa di GenAI, robotica e sistemi distribuiti. È un ex ricercatore della NASA, uno dei primi ingegneri di una startup acquisita da VMware, e ha conseguito un dottorato di ricerca a Stanford in intelligenza artificiale e sistemi distribuiti.

In qualità di Chief AI Officer, Sandeep guiderà la strategia di intelligenza artificiale di Story, guidando le incubazioni chiave e consigliando l'ecosistema più ampio su come cogliere l'immensa opportunità dell'intelligenza artificiale che si presenta.

Il lavoro di Sandeep si è a lungo concentrato su come robot, sensori e modelli ML possono imparare dal disordinato mondo fisico. Ora sta portando la sua esperienza nel web3 e nella Story.

Questo perché il prossimo salto dell'IA non riguarda più GPU. Si tratta di sbloccare la categoria di proprietà intellettuale più preziosa (e poco servita): i dati del mondo reale.

La nomina di Sandeep è un passo importante verso la realizzazione della visione del Capitolo 2 di Story. La prossima settimana, questa visione prenderà vita in grande stile.

Restate sintonizzati.

9,72K

<Intervista a RedStone>

RedStone è un progetto modulare di oracoli blockchain che fornisce feed di dati sicuri, veloci ed economici per oltre 1.250 asset in più di 70 catene.

La sua architettura separa la raccolta dei dati off-chain dalla consegna on-chain, supportando sia i meccanismi pull che push. Questo design offre agli sviluppatori la flessibilità necessaria per ottimizzare i costi del gas e le prestazioni in tempo reale.

Stasera alle 22:00 KST, saremo raggiunti dal fondatore di RedStone per conoscere la loro visione e le loro strategie per i mercati in rapida crescita delle stablecoin e degli RWA.

👉

5,78K

@Mira_Network's Verify è l'infrastruttura che risponde a questa domanda. Invece di un unico modello, valutiamo ogni affermazione attraverso tre modelli di verifica specializzati e li classifichiamo come "vero", "falso" o "nessun consenso" in base ai risultati.

Se tutti i modelli prendono la stessa decisione, è considerato un risultato affidabile e se esprimono giudizi diversi, solleva segnali sospetti. Non si tratta solo di trovare la risposta giusta, ma di fornire l'"incertezza" stessa sotto forma di dati.

Verify non è solo una demo, è una "infrastruttura di fiducia". Si tratta di un backend basato su API che consente alle aziende di rilevare l'autenticità dei contenuti dell'intelligenza artificiale, filtrare automaticamente la disinformazione e collegarla a una posizione rivedibile dall'uomo quando necessario.

Mira16 lug 2025

Internet ha un problema di verità.

Così abbiamo creato Mira Verify, che utilizza il consenso multi-modello per identificare allucinazioni e disinformazione.

Mira è il multi-sigillo della verità.

2,78K

<Cosa hai provato guardando Sharplink Gaming>

Sento che Consensys ha preso l'iniziativa e la "strategia finanziaria di Ethereum" è diventata una grande tendenza. Sharplink Gaming sta aumentando costantemente Ethereum raccogliendo circa 500 miliardi di won attraverso PIPE, e la differenza rispetto alla strategia finanziaria di Bitcoin è che Ethereum può realizzare profitti attraverso la gestione patrimoniale oltre la semplice detenzione.

Quello che mi incuriosisce qui è come gestire gli Ethereum accumulati in questo modo. Se si guarda @SharpLinkGaming esempio, si può vedere che gli asset sono gestiti in base a LST o LRT tramite Figment.

Figment è uno dei migliori validatori su Ethereum e gestisce un caveau dedicato per gli investitori istituzionali, fornendo al contempo rendimenti stabili in staking. E progetti come @Obol_Collective stanno aiutando grandi operatori come Figment a rendere la convalida più affidabile ed efficiente.

Man mano che sempre più istituzioni adottano la strategia Ethereum, credo che la domanda e l'offerta di Ethereum saranno inevitabilmente indirizzate verso questi validatori che si rivolgono esclusivamente alle istituzioni. In particolare, la gestione del rischio è la chiave per le istituzioni, quindi gestiscono i nodi in modo molto conservativo per ridurre al minimo i rischi come i tempi di inattività e i tagli.

Ad esempio, se si verifica un disastro naturale durante l'esecuzione di un nodo con una singola chiave validatore, non solo le ricompense che riceverai in futuro, ma anche il principale di staking possono andare persi. Al fine di ridurre questo rischio, la domanda di DVT (Distributed Validator Technology) (DVT), che distribuisce le chiavi di convalida su più nodi, continuerà a crescere.

La differenza decisiva nell'infrastruttura tra Ethereum e Solana è la sua struttura di calcolo decentralizzata. Anche se il mondo viene distrutto, è progettato per evitare un singolo punto di errore attraverso almeno 5~6 client. Affinché le istituzioni possano abbracciare correttamente questa narrativa di Ethereum, devono elaborare una strategia a livello di validatore per ridurre i singoli punti di errore, e ci sono progetti come @Obol_Collective al centro di esso.

Alla fine, penso che più aziende sceglieranno la strategia finanziaria di Ethereum, più aumenterà naturalmente la domanda di progetti che le aiutino a fare una migliore convalida o a semplificare la gestione degli asset.

Lido6 lug 2025

DVV Massimo di tutti i tempi + Aumento limite

Il Decentralized Validator Vault ha raggiunto il massimo storico a 14.344 wstETH (~$44m).

In aggiunta a ciò, il limite di deposito è stato aumentato a 20.000 wstETH, alimentando l'adozione della DVT attraverso Lido, Obol e SSV.

Limiti più alti. Più decentralizzazione.

8,02K

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari