Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Teknikjättar använder Multimodal RAG varje dag i produktionen!

- Spotify använder det för att svara på musikfrågor

- YouTube använder det för att förvandla uppmaningar till spår

- Amazon Music använder den för att skapa en spellista från en prompt

Låt oss lära oss hur man bygger en Multimodal Agentic RAG (med kod):

Idag ska vi bygga en multimodal Agentic RAG som kan fråga dokument och ljudfiler med hjälp av användarens tal.

Teknisk stack:

- @AssemblyAI för transkribering.

- @milvusio som vektorn DB.

- @beam_cloud för distribution.

- @crewAIInc Flöden för orkestrering.

Låt oss bygga det!

Här är arbetsflödet:

- Användarinmatningsdata (ljud + dokument).

- AssemblyAI transkriberar ljudfilerna.

- Transkriberad text och dokument är inbäddade i Milvus vektordatabas.

- Research Agent hämtar information från en användarfråga.

- Svarsagenten använder den för att skapa ett svar.

Kolla in det här👇

1️⃣ Inmatning av data

Till att börja med tillhandahåller användaren text- och ljudindata i datakatalogen.

CrewAI Flow implementerar logiken för att upptäcka filerna och göra dem redo för vidare bearbetning.

Kolla in det här👇

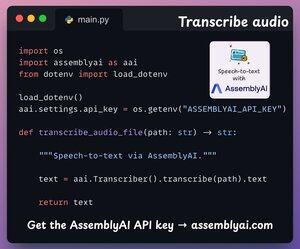

2️⃣ Transkribera ljud

Därefter transkriberar vi användarens ljudindata med hjälp av AssemblyAI:s tal-till-text-plattform.

AssemblyAI är inte öppen källkod, men det ger gott om gratis krediter för att använda deras SOTA-transkriptionsmodeller, som är mer än tillräckliga för den här demon.

Kolla in det här👇

3️⃣ Bädda in indata

När vi går vidare bäddas de transkriberade indata från ovanstående steg och inmatade textdata in och lagras i Milvus-vektorns DB.

Så här gör 👇 vi

4️⃣ Förfrågan från användare

Inmatningen är över.

Nu går vi vidare till inferensfasen!

Därefter matar användaren in en röstfråga som transkriberas av AssemblyAI.

Kolla in det här👇

5️⃣ Hämta kontext

Därefter genererar vi en inbäddning för frågan och hämtar de mest relevanta segmenten från Milvus-vektordatabasen.

Så här gör 👇 vi

6️⃣ Generera ett svar

När vi har det relevanta sammanhanget anropas vårt team för att generera ett tydligt och citerat svar för användaren.

Kolla in det här 👇

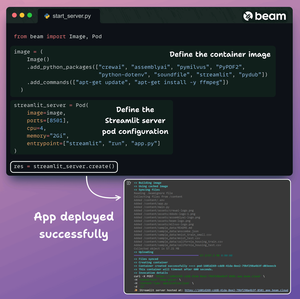

Slutligen sammanfattar vi allt i ett rent Streamlit-gränssnitt och distribuerar appen till en serverlös behållare med hjälp av Beam.

Vi importerar nödvändiga Python-beroenden och anger beräkningsspecifikationerna för containern.

Och sedan distribuerar vi appen i några rader kod👇

När den väl har distribuerats får vi en 100 % privat distribution för det Multimodal RAG Agentic-arbetsflöde som vi just har byggt.

Kolla in den här demon 👇

Här är arbetsflödet som vi implementerade:

- Användaren gav data (ljud + dokument)

- AssemblyAI transkriberade ljudfilerna

- Transkriberade data är inbäddade i vektordatabasen

- Research Agent hämtade information från användarfråga

- Svarsagenten använde den för att skapa ett svar

Kolla in det här👇

Om du tyckte att det var insiktsfullt, dela det igen med ditt nätverk.

Hitta mig → @akshay_pachaar ✔️

För fler insikter och handledningar om LLM:er, AI-agenter och maskininlärning!

5 aug. 20:30

Teknikjättar använder Multimodal RAG varje dag i produktionen!

- Spotify använder det för att svara på musikfrågor

- YouTube använder det för att förvandla uppmaningar till spår

- Amazon Music använder den för att skapa en spellista från en prompt

Låt oss lära oss hur man bygger en Multimodal Agentic RAG (med kod):

106,56K

Topp

Rankning

Favoriter