Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

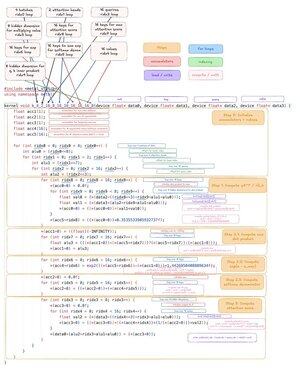

Ora con la fusione dei loop e senza ricalcolo. Se puoi costruire un "compilatore" da cui l'attenzione flash semplicemente emerge, immagina cos'altro potrebbe fondere.

4 ago, 04:34

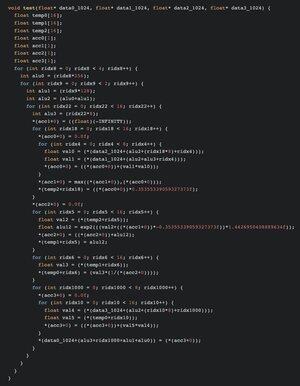

Ho annotato il kernel di flash attention di tinygrad per assicurarmi di capirlo.

Generare questo in modo GENERICO è davvero interessante!

29,72K

Principali

Ranking

Preferiti