Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Yohei

Yohei a reposté

Présentation d'un nouveau type de technologie civique rendu possible par l'IA. Chaque citoyen devrait avoir une vue en direct et systémique de son gouvernement et aujourd'hui, nous l'apportons à SF !

Suivez les entités gouvernementales, les dépenses, les actualités, et plus encore en temps réel. Avec les LLM, nous pouvons apporter cela à chaque ville. Qui est le prochain ?

48,83K

Yohei a reposté

À l'ère du pré-entraînement, ce qui comptait, c'était le texte d'internet. Vous voudriez principalement une grande collection diversifiée et de haute qualité de documents internet à partir desquels apprendre.

À l'ère du finetuning supervisé, ce sont les conversations qui comptaient. Des travailleurs sous contrat sont engagés pour créer des réponses à des questions, un peu comme ce que vous verriez sur Stack Overflow / Quora, etc., mais orienté vers les cas d'utilisation des LLM.

Aucun des deux précédents ne disparaîtra (à mon avis), mais à cette époque de l'apprentissage par renforcement, ce sont maintenant les environnements qui comptent. Contrairement aux précédents, ils donnent au LLM l'opportunité d'interagir réellement - de prendre des actions, de voir des résultats, etc. Cela signifie que vous pouvez espérer faire beaucoup mieux qu'une imitation experte statistique. Et ils peuvent être utilisés à la fois pour l'entraînement et l'évaluation du modèle. Mais tout comme auparavant, le problème central est maintenant de nécessiter un ensemble large, diversifié et de haute qualité d'environnements, comme exercices pour que le LLM puisse s'entraîner.

D'une certaine manière, je me rappelle du tout premier projet d'OpenAI (gym), qui était exactement un cadre espérant construire une grande collection d'environnements dans le même schéma, mais c'était bien avant les LLM. Donc, les environnements étaient des tâches de contrôle académique simples de l'époque, comme cartpole, ATARI, etc. Le hub d'environnements @PrimeIntellect (et le dépôt `verifiers` sur GitHub) construit la version modernisée ciblant spécifiquement les LLM, et c'est un grand effort/une grande idée. J'ai proposé que quelqu'un construise quelque chose comme ça plus tôt cette année :

Les environnements ont la propriété qu'une fois que le squelette du cadre est en place, en principe, la communauté/l'industrie peut paralléliser à travers de nombreux domaines différents, ce qui est excitant.

Dernière pensée - personnellement et à long terme, je suis optimiste sur les environnements et les interactions agentiques mais je suis pessimiste sur l'apprentissage par renforcement spécifiquement. Je pense que les fonctions de récompense sont super suspectes, et je pense que les humains n'utilisent pas l'apprentissage par renforcement pour apprendre (peut-être le font-ils pour certaines tâches motrices, etc., mais pas pour des tâches de résolution de problèmes intellectuels). Les humains utilisent différents paradigmes d'apprentissage qui sont significativement plus puissants et efficaces en échantillonnage et qui n'ont pas encore été correctement inventés et mis à l'échelle, bien que des esquisses et des idées précoces existent (comme juste un exemple, l'idée de "l'apprentissage par prompt système", déplaçant la mise à jour vers des tokens/contextes et non des poids et distillant éventuellement vers des poids comme un processus séparé un peu comme le sommeil le fait).

372,6K

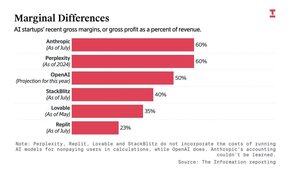

« Perplexity, Replit, Lovable et Stackblitz n'incorporent pas les coûts de fonctionnement des modèles d'IA pour les utilisateurs non payants »

Tanay Jaipuria26 août, 07:07

Bon graphique de @theinformation sur les marges brutes des entreprises d'IA

23,68K

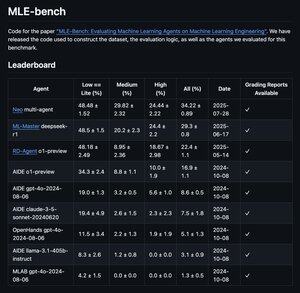

maintenant officiellement #1 sur le classement MLE d'@openai !

792BB823 août, 00:01

Présentation de NEO :

Le premier ingénieur en apprentissage automatique autonome.

Il fonctionne comme un ingénieur ML full-stack qui ne dort jamais : gérant l'exploration des données, l'ingénierie des fonctionnalités, l'entraînement, le réglage, le déploiement et la surveillance, de bout en bout.

Propulsé par 11 agents spécialisés, NEO fonctionne de manière autonome, économisant aux ingénieurs ML des milliers d'heures et les rendant 10 fois plus rapides.

Références :

Testé sur 75 compétitions Kaggle, NEO a obtenu une médaille dans 34,2 % d'entre elles, surpassant significativement l'agent RD de Microsoft (22,4 %) sur le banc d'essai MLE d'OpenAI.

Cela établit un nouvel état de l'art pour les systèmes ML autonomes.

NEO fonctionne sur un nouvel orchestrateur multi-agents, alimenté par un moteur de raisonnement multi-étapes, un protocole de transfert de contexte et une mémoire d'agent, conçu pour résoudre des flux de travail complexes de bout en bout.

Et avec le mode humain dans la boucle, vous pouvez guider, inspecter et remplacer n'importe quelle étape.

Vous êtes toujours aux commandes.

NEO est conçu pour des flux de travail du monde réel et prêt pour la production.

NEO est là pour rendre chaque ingénieur ML véritablement surhumain.

Regardez NEO en action :

24,38K

Meilleurs

Classement

Favoris