Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

GPT-5 wurde als eine Lösung zur Reduzierung von Halluzinationen beworben, und es scheint, dass es funktioniert. 99,5 -> 99,9 bedeutet 80 % weniger Fehler.

Ich verstehe nicht, warum die Leute nicht mehr Aufhebens darum machen. Halluzinationen sind eines der größten Probleme von LLMs, und einige dachten, sie seien unlösbar.

15. Aug., 00:29

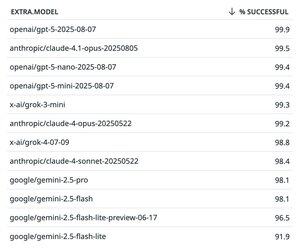

Nach einer Woche hat GPT-5 unsere proprietären Modellcharts für die Genauigkeit beim Tool-Calling angeführt🥇

Auf dem zweiten Platz liegt Claude 4.1 Opus mit 99,5%

Details 👇

135,46K

Top

Ranking

Favoriten