Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Trochu jsem se ztratil ve všech těch zkratkách a žargonu, takže jsem si nechal od Clauda vysvětlit bez použití zkratek a teď to všechno dává dokonalý smysl (tldr; šířka pásma ⟹ jednoduchost):

Toto je fascinující technická diskuse o trénování velkých jazykových modelů ve velkém měřítku.

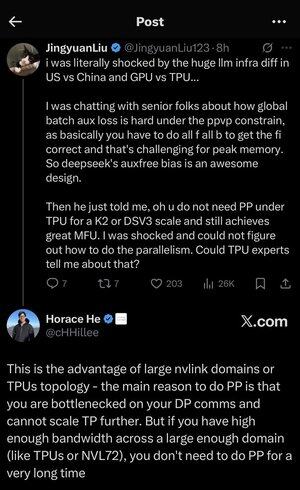

Základní konverzace

Jingyuan Liu vyjadřuje překvapení nad zjištěním, že při používání TPU (Tensor Processing Units - specializované AI čipy Google) oproti GPU (Graphics Processing Units - typicky čipy NVIDIA) nepotřebujete určité složité optimalizační techniky.

Vysvětlení klíčových technických pojmů:

Typy hardwaru:

•GPU (Graphics Processing Unit): Původně navržený pro grafiku, nyní se hojně používá pro umělou inteligenci. NVIDIA tomuto trhu dominuje.

•TPU (Tensor Processing Unit): Čipy navržené na míru společnosti Google speciálně pro strojové učení.

Strategie paralelismu:

Při trénování masivních modelů umělé inteligence je potřeba rozdělit práci na mnoho čipů. To lze provést několika způsoby:

1) Datový paralelismus (DP): Každý čip zpracovává různé dávky dat se stejnou kopií modelu

2) Tenzorový paralelismus (TP): Matematické operace modelu jsou rozděleny mezi čipy

3) Paralelismus potrubí (PP): Různé vrstvy modelu jsou umístěny na různých čipech, čímž se vytvoří potrubí

Diskutovaná technická výzva:

Problém pomocných ztrát: Při trénování velmi velkých modelů často přidáváte "pomocné ztráty" (dodatečné cíle trénování) do mezilehlých vrstev, aby gradienty lépe proudily sítí. Při omezeních PPVP (Pipeline Parallelism with Variable Partitioning) se to stává složitým, protože:

•Musíte provést "all f all b" (všechny průchody vpřed, pak všechny průchody vzad)

•To je náročné pro špičkové využití paměti, protože je nutné ukládat mezivýsledky

Inovace DeepSeek: Vyvinuli design "auxfree bias", který se zjevně vyhýbá potřebě těchto pomocných ztrát a přitom stále efektivně trénuje.

Překvapivé odhalení:

Starší odborník řekl Jingyuanovi, že s TPU v měřítku K2 nebo DSV3 (jedná se o konfigurace clusterů se stovkami nebo tisíci čipů) můžete dosáhnout vynikajícího MFU (využití modelových flopů - v podstatě jak efektivně používáte hardware) BEZ použití Pipeline Parallelism.

Proč je to překvapivé?

•Paralelismus zřetězení je obvykle považován za nezbytný pro rozsáhlé školení

•Jedná se o složitou techniku, která vyžaduje pečlivou optimalizaci

•Schopnost vyhnout se tomu vše výrazně zjednodušuje

Vysvětlení Horace He:

Vysvětluje, PROČ je to možné s TPU:

Výhoda šířky pásma: TPU a high-end clustery NVIDIA (jako NVL72 - nejnovější konfigurace NVIDIA se 72 GPU s propojením NVLink) mají tak velkou šířku pásma mezi čipy, že zvládnou komunikační požadavky bez paralelismu Pipeline.

Klíčový poznatek:

•Pipeline Parallelism je primárně potřeba, když jste "úzkým hrdlem DP komunikace" (omezeno rychlostí komunikace během tréninku datové paralely)

•Pokud máte dostatečnou šířku pásma v dostatečně velké doméně (propojeném clusteru), můžete použít jednodušší paralelistické strategie

•To funguje "po velmi dlouhou dobu" - to znamená, že můžete trénovat i velmi velké modely, aniž byste narazili na limity

Intuice:

Představte si to jako dálniční systém:

•Tradiční GPU clustery se podobají úzkým silnicím mezi městy, takže potřebujete složité směrování (Pipeline Parallelism), abyste se vyhnuli dopravním zácpám

•TPU clustery nebo GPU připojené k NVLink jsou jako masivní superdálnice - vše můžete jednoduše poslat přímo bez efektního směrování

To je velký problém, protože paralelismus kanálů je složité implementovat, ladit a optimalizovat. Díky možnosti vyhnout se tomu a zároveň dosáhnout vysoké efektivity je celý proces školení mnohem jednodušší a spolehlivější.

Diskuse zdůrazňuje, jak pokroky v technologii hardwarového propojení ("cesty" mezi čipy) mohou zásadně změnit softwarové strategie potřebné pro efektivní trénink AI.

10,2K

Top

Hodnocení

Oblíbené